蜗居的阿宅终于有了正当理由不出门,那么他们的生存秘诀是什么?全新上线的#宅家生活手册#征稿活动火热进行中,来分享你特殊时期的宅居规划吧>活动详情戳这里<时间:1月28日-2月29日全文约4800字,完整阅读约15min。

GG写这篇文章的主要原因是近年来许多厂商对于“像素”“分辨率”不负责任的宣传误导了很多吃瓜群众,而且该领域存在大量历史遗留问题,很多朋友在讨论相关产品的时候常常会犯一些概念性的错误。GG也是花了很大时间才从一堆真真假假的文章资料中理清个中真相,遂整理成文,希望帮各位值友深入理解这两个概念,如有疏漏错误请评论中指出,感激不尽。

1.从“图片像素”说起

我们平时看到的大部分图片,是以位图的形式表示的。所谓位图就是以一个个像素点像拼图那样拼接在一起组成的图像。每一个像素点有不同的明暗色彩,拼在一起构成不同的图像。我们将图像一直放大就可以看到组成的像素点,俗称“马赛克”:

原图

放大

再放大,像素点已经明显

那么在理想情况下,图片应该是像素数越高越清晰,像素低的图片模糊不清,像素高的图片则十分精细。

500W像素图片(上)5W像素图片(下)

我们所说的图片分辨率,则一般以图片长宽像素数相乘表示,如上面长宽比为3:2,500W像素的图片,分辨率为2768×1826,表示图片每一行有2768个像素,每一列有1826个像素,一共是5,054,368个像素。

而视频则是由一系列静止的图片连续播放形成的。视频的分辨率就是里面每一帧的分辨率。如常见的1080P,其分辨率为1080×1920,其每一帧的图像都是由1080×1920分辨率的图片构成。

那么在非理想情况下,比如手机、电脑、电视上,是不是也是图片、视频的像素数、分辨率越高越好呢?这就要牵扯到下面的知识:

2.屏幕里的像素妈妈和像素儿子

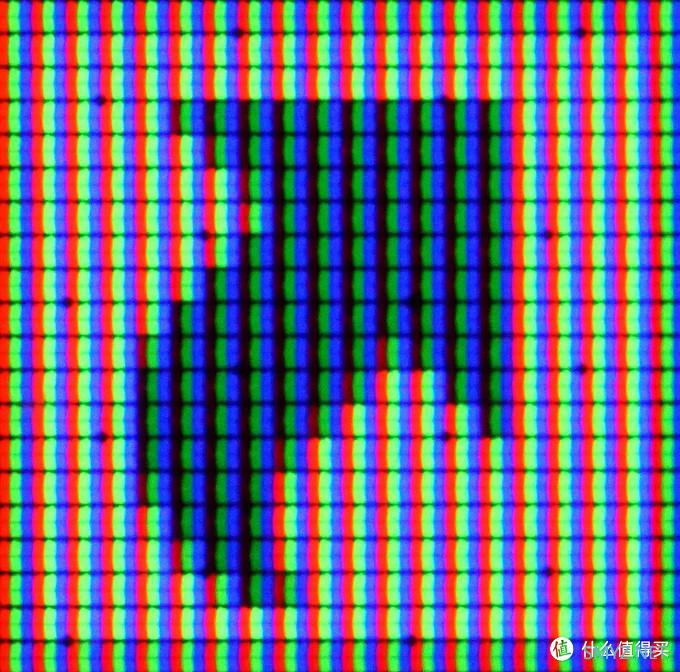

常见的屏幕显示原理和位图一样,是以一个个发光单元作为拼凑在一起显示图像的。如果我们用微距镜头拍摄屏幕,可以明显的看到组成图像的一个个色彩明暗不一的发光小方块,这样的每一个方块称为显示器的像素:

每个小方块就是一个屏幕像素

而为了使像素点显示出不同的颜色,每个像素点又由多个子像素构成,例如最常见的RGB型,通过红绿蓝三种颜色子像素的明暗组合来显示出像素的颜色。从下图可以看出,RGB三个子像素同时高亮,从远处看就是一个白色像素点;红色像素不亮,绿、蓝子像素低亮,则从远处看就成为一个普鲁士蓝色的像素点。再拉远距离看就是我们平时看到的快捷方式图标。

子像素为RGB型的显示器下的快捷方式图标

一般情况下,我们所说的屏幕像素,指屏幕上由子像素组成的像素点的数量,而不是子像素数量。对于屏幕我们更习惯于用分辨率表示,如1080屏,4K屏(一般指3840×2160)。

(然而在某些产品中,如相机屏幕上像素指的是子像素数量,如索尼α7Ⅲ的92W像素液晶屏实际分辨率为640×480,这是个历史遗留问题。)

显而易见的是,对于同一尺寸的屏幕而言,像素数越高显示效果越精细——和图片、视频的原理一样。

3.当调整屏幕分辨率时发生了什么?

那么我们平时说的调整屏幕分辨率是什么意思呢,实际上是将屏幕上的像素进行合并显示。比如我是一个原生分辨率1920×1080的屏幕,如果在设置里改成960×540的分辨率,那屏幕就让相邻的两个像素点发出完全的一样的光,相当于把两个像素点当成一个用。这样显示质量会有下降,但也减少了设备运行的负担。但如果更改后的屏幕分辨率不是原生分辨率的整数倍,比如改成1440×900,这样屏幕就不能像刚才那样简单粗暴的用两个像素点合一这样的方式显示了,而是有的像素二合一,有的还是一个,有的还需要更改显示的色彩,这样就会造成一些混乱,导致显示效果不如同尺寸原生1440×900的屏幕。这也是很多人推荐显示器尽量使用整数倍缩放的原因。

4.屏幕像素和图片像素有什么关系?

在屏幕显示图片时,如果屏幕的长宽比、像素数和图片一致,只需要每个屏幕像素用子像素的敏感组合表示出图片上的像素就可以了。等等,那如果图片像素数和屏幕像素数不一样呢?

这就是一切误会的根源了。

事实上,当图片像素大于屏幕像素时,屏幕也是进行合并显示的。比如一张1200W像素的图片,要在300W像素的显示器(长宽比一致)上显示,那么系统就需要将图片像素进行四合一计算然后再显示。比如相邻的四个图片像素分别是白色、浅蓝、深蓝、深蓝,经过计算之后就当成一个浅蓝的像素进行显示(仅作为举例)。而图片像素低于屏幕像素时也类似,系统会将一个蓝色像素当成四个蓝色像素在屏幕上显示。

根据上面的结论,我们可以推导出一个非常简单但却经常被忽视的结论,那就是:当图片像素数大于屏幕像素数时,高像素图片和低像素图片的显示精细度是一样的!

还是刚才那张图,刚才我们看到,500W像素的图片确实比5W像素的图片清晰的多,但是在GG这块175W像素的屏幕(1920×1080,3:2显示下为1620×1080)下,4200W像素的图片和500W像素图片显示效果是一样的。

4200W像素图片(上)500W像素图片(下)

这也是“高像素无用论”说法的来源:像素高了也显示不出来,徒增文件体积。

GG这里列一下常见各种屏幕的分辨率和像素数,大家可以匹配一下,我们现在的显示设备最多可以用上多少像素:

1920×1080,207W像素,常见于笔记本、电脑显示器、电视;

2560×1440,368W像素,常见于电脑显示器(最常见的2K);

3840×2160,829W像素,常见于高端电脑显示器、电视(4K屏);

2340×1080,252W像素,常见于手机;

3040×1440,438W像素,常见于高端手机(2K手机屏)。

可见即使是目前很高端的4K,也只能显示出800多万像素。

那么是否多出来的像素就一定没用呢?倒也不是。高像素的图片,除了能在未来的高分辨率屏幕上更清楚的显示外,还有一个作用,就能放大更多倍。因为缩放图片实际上相当于从原来的图片中截取一部分,然后铺满屏幕。仍以那张图片举例,4200W的图片截取中间1/20的部分放大,仍有210W像素,可以铺满屏幕;而200W像素的图片这样放大之后只剩下1W像素,远低于屏幕像素数,已经不够看了。

4200W像素图片放大(上),200W像素图片放大(下)

一番讨论下来,结论很明显了,那就是:

对于不需要放大查看的图片,如各种社交网站上的大部分晒图,各种视频,图片像素数(分辨率)稍大于查看设备的像素数(分辨率)即可,考虑到大部分人手里都是2K以下的显示设备,400W像素的图片足矣;即使考虑长宽比不一致的损失和4K战未来,1000W像素也是足够用的了。如果确实需要放大仔细查看,图片像素当然是越高越好,但也要考虑文件体积的问题。

但对于视频而言,目前大部分情况都是视频的分辨率低于屏幕分辨率:

各大视频网站上大部分片源还是最高1080P,如果没有会员基本是720P封顶。一些年代比较老的片子很多还是480P(或者假1080),真正能用上4K的视频作品目前还很少。因为高分辨率屏幕播放低分辨率视频不会有任何加成,如果手上播放设备不是太老旧的话,买个会员对视觉的加成效果比花大价钱买高分辨率屏更实在。

OK,屏幕和图片上像素的关系理清了,下面再说说相机像素的纠葛。

5.相机像素——被营销和误解最多的可怜虫

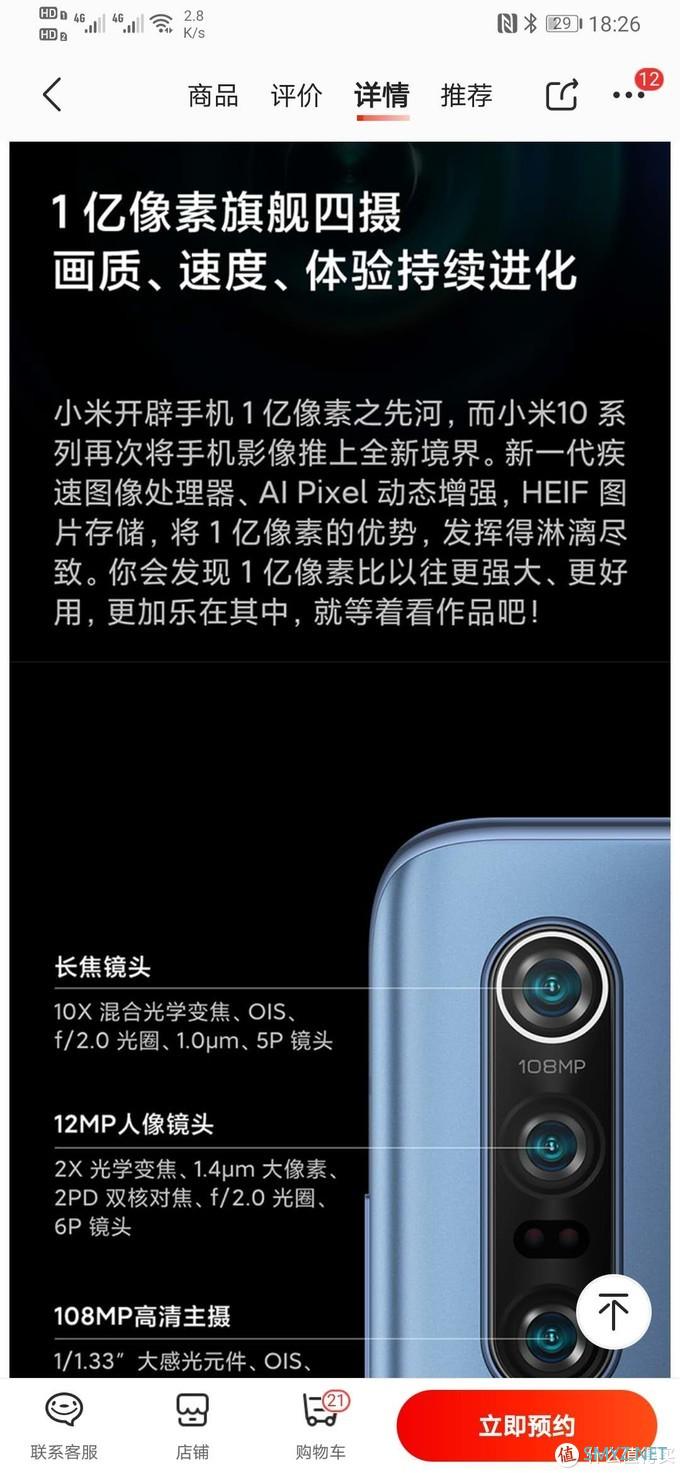

数码相机的成像原理,是利用镜头将所摄物体成像,所成的像被镜头后面的感光元件记录下来,再转化为数字信号。感光元件中的每一个感光单元即为相机的像素。相机的像素数即其输出图像像素的上限(一般情况下),2400W像素相机拍出照片默认就是2400W。在不需要经常放大查看的情况下,常见手机的1200W直出摄像头都是足够我们的屏幕看的。当然,为了有更多裁剪放大空间,相机像素确实是越高越好。但是,更高的像素也会给处理器等模块带来压力,比如小米CC9Pro上搭载的1.08亿像素摄像头,全像素输出时要卡顿好几秒。对于专业的相机而言,相机的速度还涉及连拍、对焦这些指标,一味地堆像素并不可取。目前相机的像素数一般在2000~6000W范围内,是综合考虑速度和显示设备等要求后比较平衡的选择。

看起来很简单?还没完。GG这里想科普的是两个常见的误区,包括“单像素面积与暗光拍摄能力”和“四合一提升夜拍画质”。

很容易想到,对于感光元件上的一个个像素来说,单个像素的面积越大,在同样条件下其接受的光线越多,这样输出的信号就越接近于真实值,在光线不足时成像也会越好。这是没有问题的。

“所以我们的单个像素面积更大,能够获得更好的夜拍画质。”某些手机厂商如是说。

错!单像素面积和暗光拍摄画质没有必然联系,这是因为我们所看到的图像是由几百万几千万个像素共同组成的,而不仅仅是由单个像素显示出来的。

试想两块同样尺寸的感光元件,一块是1000W像素,一块是4000W像素,很明显,低像素的版本单像素面积是高像素版的四倍。那么,拍同样场景的照片,在同一块200W像素屏幕上显示会是什么效果呢?

由前面的讨论我们知道,1000W像素版本的照片显示时像素会被5合1显示,4000W像素版本照片则会被20合1进行显示,合并之后屏幕上每个像素对应的相机感光元件面积是相同的。在理想状态下,两种单像素面积的相机暗光拍摄表现是一样的。事实上,在理想系统,固定曝光参数,固定放大倍率下,拍摄照片的信噪比(“纯净度”)只与整个感光元件的尺寸有关。这也是近年来手机厂商都在堆更大的底的原因之一。

那么单像素面积能影响什么呢,他能影响的是100%缩放下照片的表现。100%缩放即所谓的“双击放大看图”,此时图片会被缩放到图片中显示部分的像素数与屏幕像素数相等,所以称为100%看图。因此,不同像素的图片在100%看图时的放大倍率是不同的,以100%缩放进行不同像素间相机的比较是毫无意义的。

默认显示(上),500W像素100%放大(中),4200W像素100%放大(下)

如果上面的讨论略显复杂,记住结论就可以:一,单像素面积对于日常拍摄使用毫无参考价值;二,高像素仅就图像质量而言,没有明显的坏处。

批完了单像素面积,再来说说“四合一”、“九合一”。

根据某些厂商的宣传,他们的手机摄像头采用“quad-bayer”色彩滤镜,在光线明亮时可输出高像素图片,在光线不足时,通过“四合一”像素获得“更大的单像素面积”,以获得更纯净的暗光画质。

当然我们现在都知道了这种方法无非是把本来系统要做的合并像素的工作提前给做了,实际上并不能有效提高暗光画质。那么这种做法的意义在哪呢?

这一切,要从当今手机那有水分的“高像素”说起。

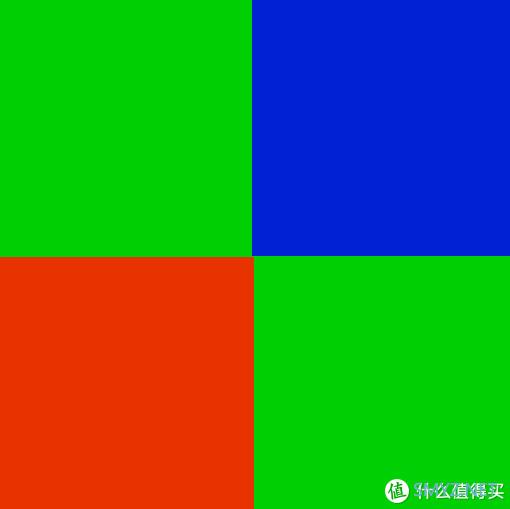

现在常用的半导体感光元件,只能感受光线的明暗,不能有效分辨的光线的波长(色盲)。为了得到彩色的图像,我们在感光元件的每个像素上都加上了色彩滤镜,让每一个像素只接收一小段波长的光线,然后将相邻像素采集到的信息进行整合,“猜”出光线本来的颜色。最常见的bayer阵列RGB传感器,便是以四个像素为一组,一蓝一红两绿,通过三种光的颜色猜回本来的颜色。

图中为4个像素

然而这样就有一个问题,单个像素收到的颜色信息是不全的,至少要4个一起的像素合在一起才能显示出比较准确的颜色。要求相机像素远高于屏幕像素,这也是一部分原因。

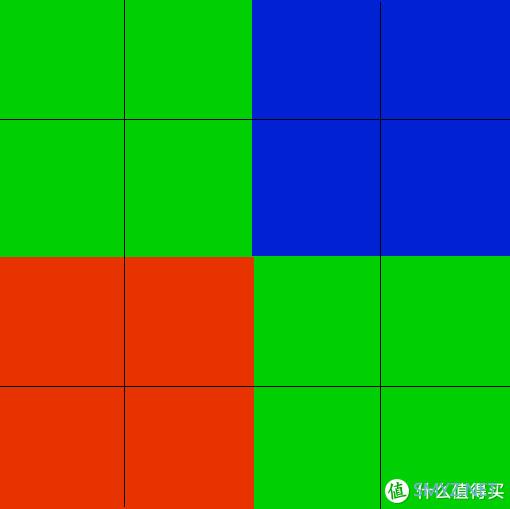

而手机绢用来“四合一”的“quad-bayer”滤镜呢,是这样的:

图中共16个像素

每四个同色滤镜像素为一组,组成一个小单元;再由四个不同颜色滤镜的小单元组成一个和普通 bayer排列相同的大单元。“四合一”时,将四个同色滤镜的像素合并为一个使用。

这个问题就更明显了,因为同色滤镜相邻,相比于普通排列对于色彩的采样率更低了,即使是同面积同像素的底,使用这种排列感光元件拍出来的照片也在精细度上明显弱于普通bayer排列。这也解释了为什么厂商们平时都要“四合一”——

因为不合并根本没法看啊!

另外,高像素也会给手机的处理器带来极大的负担,拍张照片等好几秒谁都不爽是不是。对于那些习惯双击100%看图的人,默认低像素还可以“提升”夜拍画质:反正暗光下高像素放大后也糊成一片了,不如就默认低像素让你放大不了,眼不见心不烦。

所以现在所有使用“多合一”技术的手机默认情况下都是像素合并状态……

对于消费者来说,还是把用这种感光元件的手机像素直接除以4来看比较好……(今年某些手机要除以9)。要说优点倒也是有的,虽然这个高像素模式有很大水分,但有总比没有强;另一个就是同色相邻像素可以进行包围曝光实现硬件HDR,这方面可是实实在在的强于1/4像素的bayer传感器;再一个就是便于降低生产成本和方便营销了——现在手机没个4000W像素都不好意思说自己有拍照功能不是。

最后,还是要说,像素、分辨率都是横跨多个领域的概念,对高像素、高分辨率的追求请量力而行,各个不同系统之间的相互匹配,才能获得最佳的视觉体验。

加载中,请稍侯......

加载中,请稍侯......

网友评论