近期,NVIDA一口气发布了三款Geforce新品,分别是RTX3070Ti 16GB,RTX3080 12GB,RTX3090Ti 24GB。这个行为是符合NVIDIA的风控策略的,NVIDIA的风控策略主要分为矿潮和矿崩两个层面的操作。

1、矿潮

矿潮时段,RTX 3070 HHR - RTX 3070 LHR V1 - RTX 3070 LHR V2 这种从不锁算力的HHR版本,升级到锁算力V1版本再到V2版本的路数,就是一直要让消费者意识到有新卡的存在,防范矿卡的风险,对冲掉了矿卡的风险,同时将新的消费者招揽住,因为矿工对HHR不锁算力版本的追捧,普通消费者无法接受HHR二手卡的价格,只好转投入NVIDIA的怀抱去购买LHR V1 V2版本的西新卡,从而将绝大多数的利润收入自己的囊中。

2、矿崩

矿崩时期,是二手矿卡的崩盘时期,NVIDIA使用新品加量不加价,停产部分旧型号的方式来对冲风险。

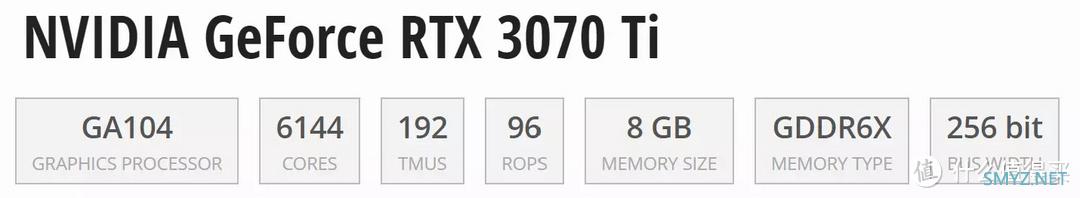

▲RTX 3070 Ti 16GB就直接将RTX 3070 Ti 8GB显存翻倍了

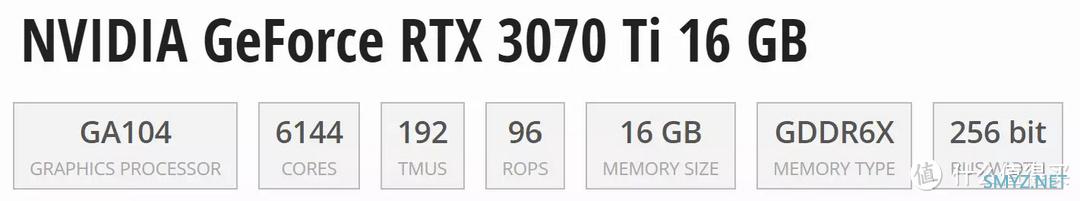

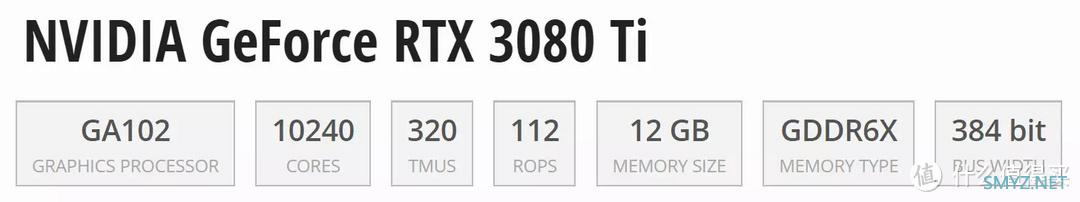

▲RTX3080 12GB在原RTX3080基础上进行了较大的升级,从规格来看,已经和RTX3080 10G没什么关系了。RTX 3080 12GB与RTX 3080 Ti和RTX 3080 10GB版一样,同属于GA102核心架构。不过全新的核心代号为GA102-220。而相比10GB版的RTX 3080,RTX 3080 12GB多了2组SM簇以及2GB的显存容量,其显存位宽达到了和RTX 3080 Ti以及RTX 3090相同的384Bit。

▲RTX 3090 Ti则直接拿出了QUADRO RTX A6000规格的完整版GA102核心取代了残血版的RTX 3090,并且RTX 3090长期被诟病的背面显存高温BUG也被改良了,另外接口换成了PCIe Gen5 x16,加量不加价。

矿崩时刻,矿工对手中的二手显卡一定是疯狂挤兑,但是,矿工手里的卡都是在高价位入的,可能很多都没有回本,所有价格都被挤在一个50-70%当初购买价的区间,这时候NVIDIA推出升级版并且停产老版本,瞬间就等于将矿工手里的卡圈住了,要不矿工不惜血本惨淡套现离场,要纠缠价格,那么升级版显卡的优势就凸显出来了,消费者关注的点还是买新不买旧以及保修政策,加上升级版本身的性能增幅,又再次将消费者套牢,大部分的利润收入囊中。

这时刻NVIDIA是需要对市场价格紧密关注精准调价的,因为唯一的风险就是矿工不惜血本的套现出逃。

黄门神刀

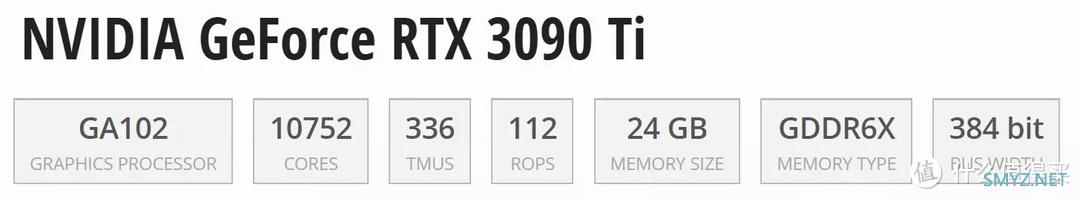

黄金刀:RTX 3090 Ti

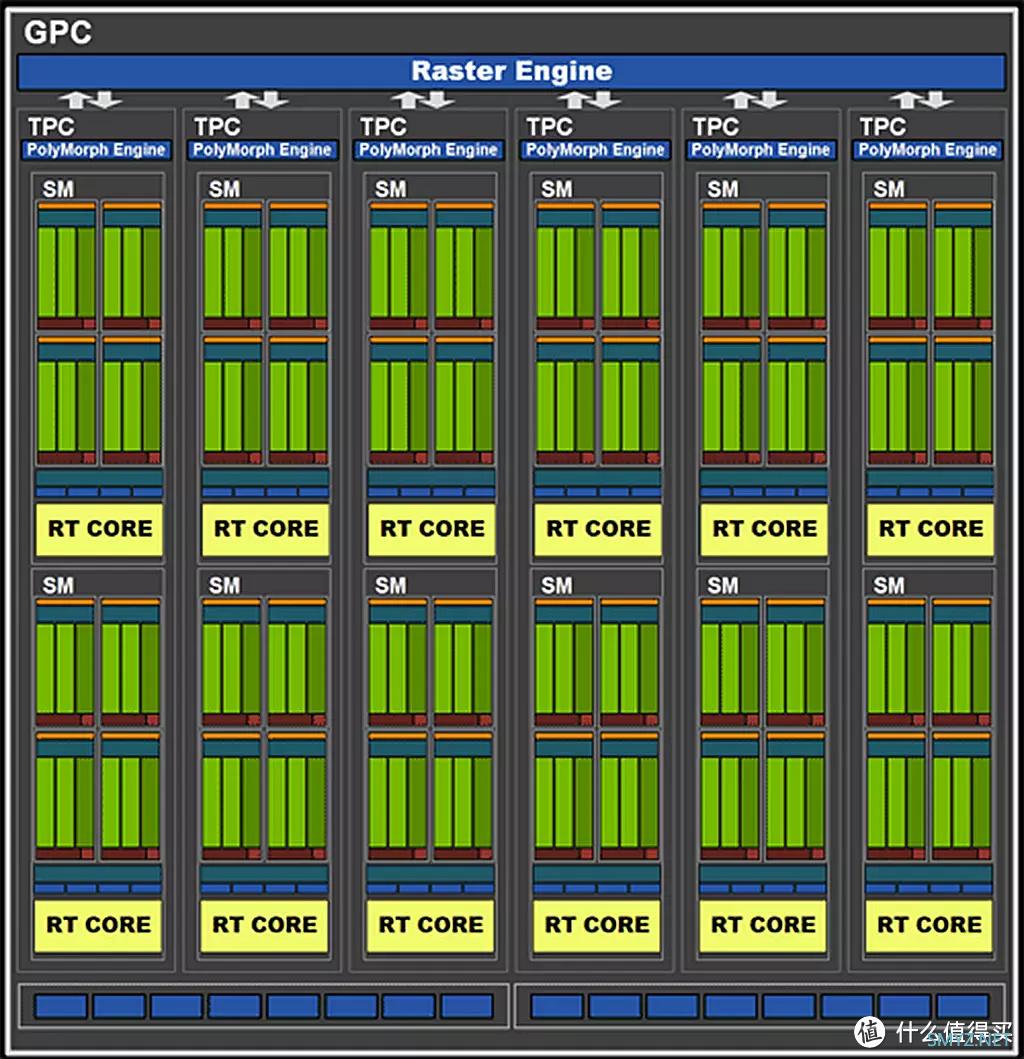

SM簇[Streaming Multiprocessor (SM)]

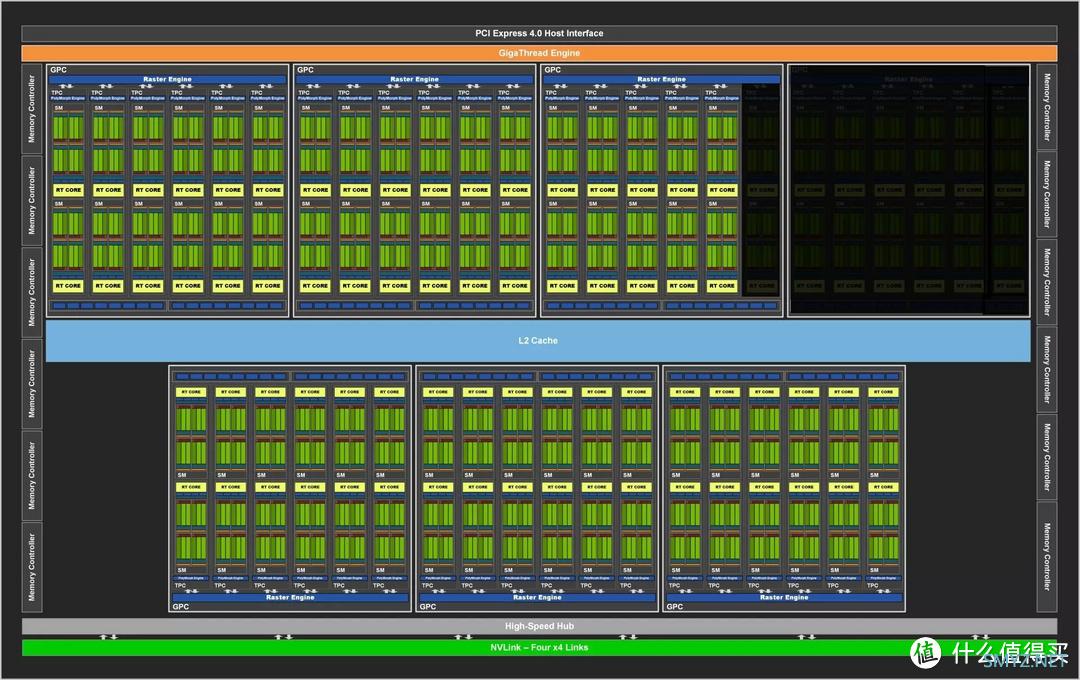

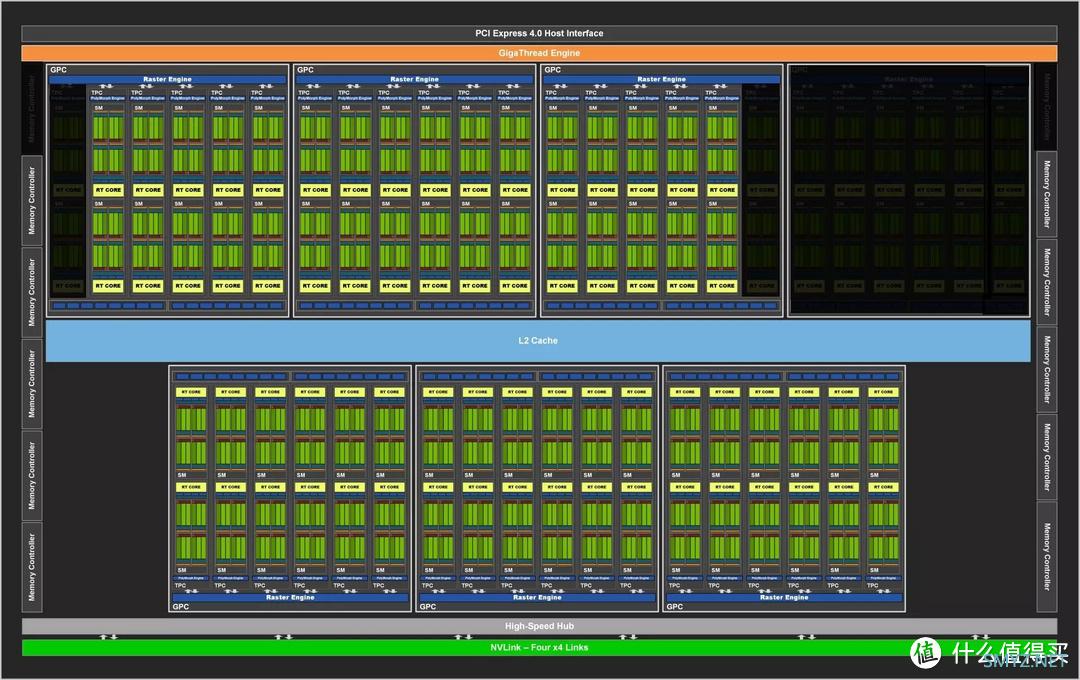

▲NVIDIA Ampere架构最大的特点是通过调整寄存器的调用,让SM中的原本负责整数运算的INT32单元同时具备了FP32的浮点计算能力,Ampere架构与上一代Turing最大的区别正在于此。

在Ampere架构的一个SM簇中,16个INT32/FP32单元+16个FP32单元为一组,共四组,内建独立的指令派送器,因而一个时钟周期内,其中16个INT/32/PF32单元作为一个整体可以在浮点和整数计算中二择一。这意味着在同一个时钟周期内可以执行16个INT32+16个FP32操作,也可以执行16个FP32+16个FP32操作,理论上一个SM簇的最大FP32算力为每个时钟128个。游戏图形渲染主要依赖FP32操作,因此可视作每个SM簇内建了128个流处理器。

每个SM簇含有128个流处理器,1个光追核心(RT Core),4个推理核心(Tensor Core)以及4个纹理单元(TMUs)组成。

Graphics Processing Cluster (GPC)

▲满血版的GPC 有 12 个 SM簇以及16个ROPs光栅单元组成

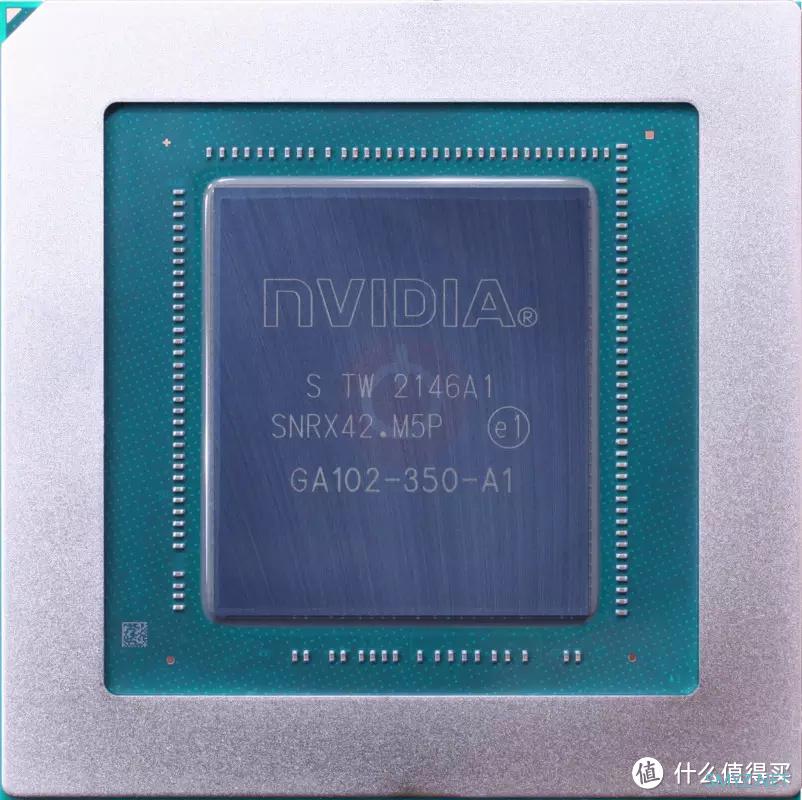

GA102-350-A1

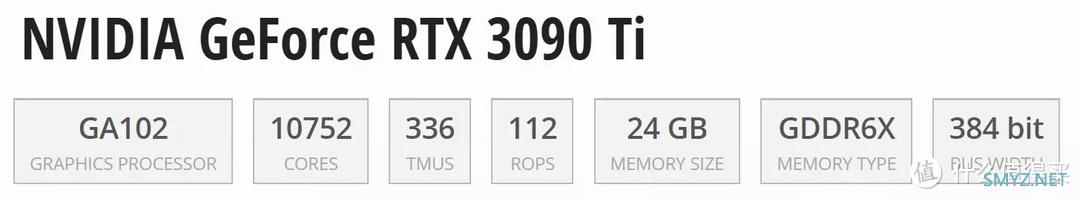

▲RTX 3090 Ti使用的是完整的GA102-350-A1核心构架

▲RTX 3090 Ti的GA102-350-A1核心。

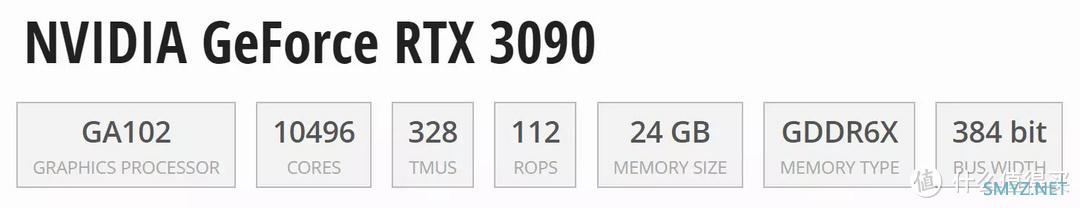

▲RTX 3090 Ti使用了7个完整GPC单元构成,每个GPC的SM簇为12个,共84个SM簇。所以可以计算出:

84(SM簇)*128(流处理器)=10752(流处理器)

84(SM簇)*1(RT光追核心)=84(RT光追核心)

84(SM簇)*4(Tensor推理核心)=336(Tensor推理核心)

84(SM簇)*4(TMUs纹理单元)=336(TMUs纹理单元)

7(GPC)*16(ROPs光栅单元)=112(ROPs光栅单元)

12(显存控制器)*32bit(位宽)=384bit(显存位宽)

有个GA102-350这个顶级巅峰核心,黄门刀法才能施展下去。

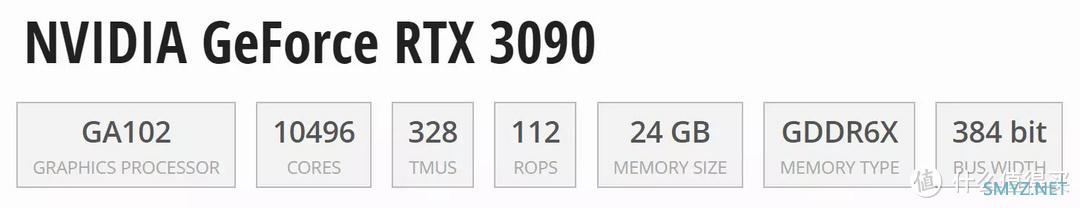

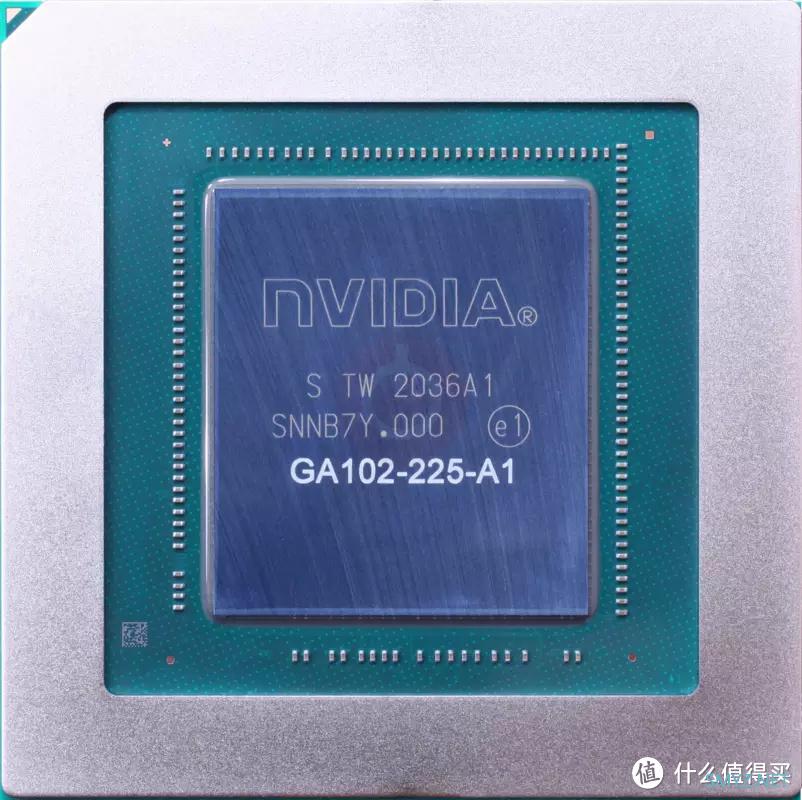

第一刀:RTX 3090

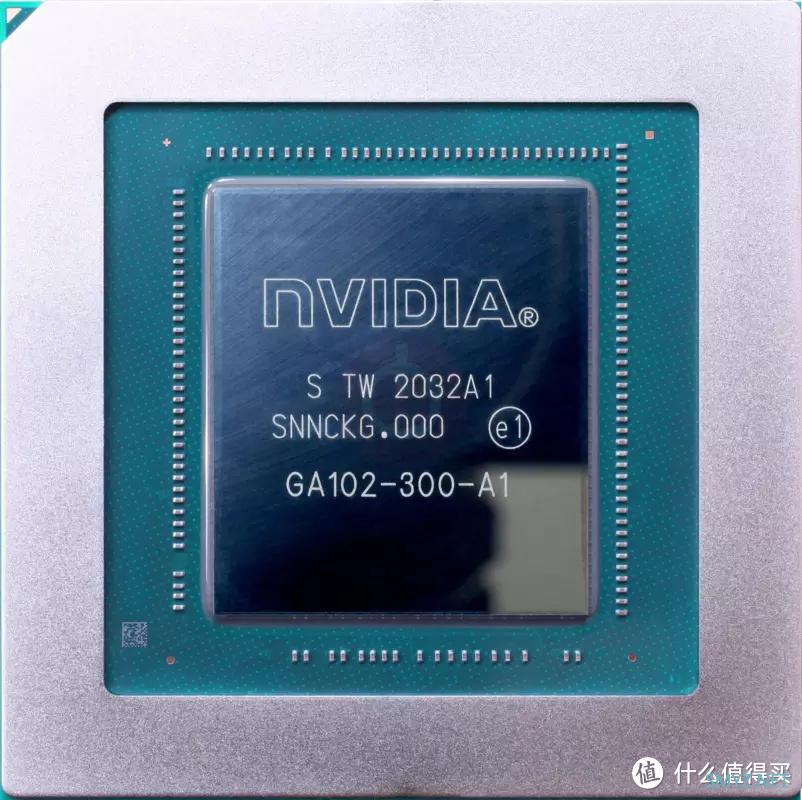

通过对GA102-350-A1一刀砍掉2组SM簇,得到了GA102-300-A1核心,也就有了RTX 3090

▲RTX 3090所使用的GA102-300-A1核心架构图

▲RTX 3090所使用的GA102-300-A1核心

▲RTX 3090 使用了7个GPC单元构成,6个GPC的SM簇为12个,1个GPC的SM簇为10个,共82个SM簇。所以可以计算出:

82(SM簇)*128(流处理器)=10496(流处理器)

82(SM簇)*1(RT光追核心)=82(RT光追核心)

82(SM簇)*4(Tensor推理核心)=328(Tensor推理核心)

82(SM簇)*4(TMUs纹理单元)=328(TMUs纹理单元)

7(GPC)*16(ROPs光栅单元)=112(ROPs光栅单元)

12(显存控制器)*32bit(位宽)=384bit(显存位宽)

第二刀:RTX 3080 Ti

通过对GA102-300-A1砍掉2组SM簇,得到了GA102-225-A1核心,也就有了RTX 3080 Ti。

▲RTX 3080 Ti所使用的GA102-225-A1核心构架图

▲RTX 3080 Ti使用的GA102-225-A1核心

▲RTX 3080 Ti使用了7个GPC单元构成,5个GPC的SM簇为12个,2个GPC的SM簇为10个,共80个SM簇。所以可以计算出:

80(SM簇)*128(流处理器)=10240(流处理器)

80(SM簇)*1(RT光追核心)=80(RT光追核心)

82(SM簇)*4(Tensor推理核心)=320(Tensor推理核心)

80(SM簇)*4(TMUs纹理单元)=320(TMUs纹理单元)

7(GPC)*16(ROPs光栅单元)=112(ROPs光栅单元)

12(显存控制器)*32bit(位宽)=384bit(显存位宽)

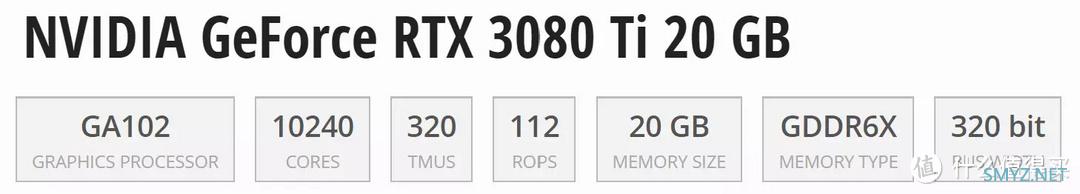

第三刀:RTX 3080 Ti 20GB

其实NVIDIA早前曾考虑过发布一款RTX 3080 Ti 20GB的卡,也就是在GA102-225-A1核心基础上屏蔽掉12组显存控制器其中的两组,得到GA102-250-KD-A1核心,这样显存位宽就从384bit降到了320bit,再配上20GB的显存就变成了RTX 3080 Ti 20GB,可惜这款产品过于暴力,性能极度接近RTX 3090,因为怕影响到RTX 3090的销售,NVIDIA最后放弃了这款产品。

▲RTX 3080 Ti 20GB的A102-250-KD-A1核心构架

▲RTX 3080 Ti 20GB使用的GA102-250-KD-A1核心,GA102-250-KD-A1核心本应出现的场景是NVIDIA内部评估使用的RTX 3080 Ti 20GB样卡,但是更多见于市面上的RTX 3090的显卡上,大量的RTX 3090的核心上丝印杠掉了GA102-250-KD-A1字样而加上了GA102-300-A1字样,这说明GA102-250-KD-A1是可以解锁成GA102-300-A1的。

▲RTX 3080 Ti使用了7个GPC单元构成,5个GPC的SM簇为12个,2个GPC的SM簇为10个,共80个SM簇,显存控制器由12组缩减到10组,所以可以计算出:

80(SM簇)*128(流处理器)=10240(流处理器)

80(SM簇)*1(RT光追核心)=80(RT光追核心)

82(SM簇)*4(Tensor推理核心)=320(Tensor推理核心)

80(SM簇)*4(TMUs纹理单元)=320(TMUs纹理单元)

7(GPC)*16(ROPs光栅单元)=112(ROPs光栅单元)

10(显存控制器)*32bit(位宽)=320bit(显存位宽)

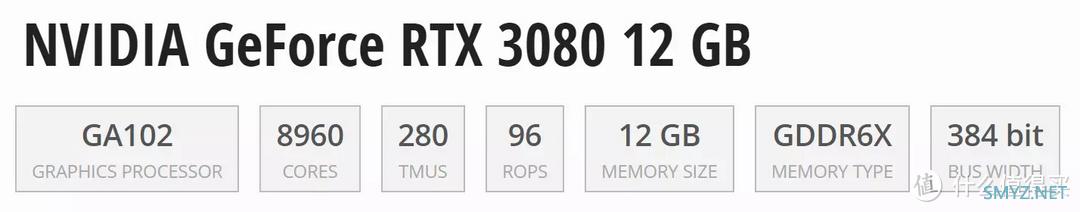

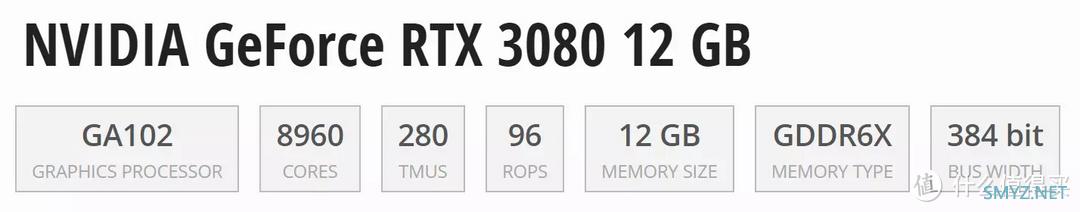

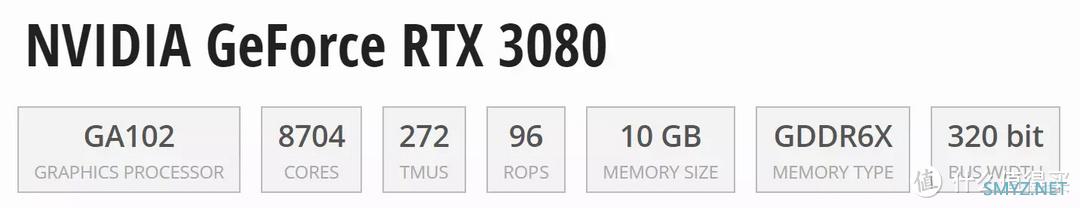

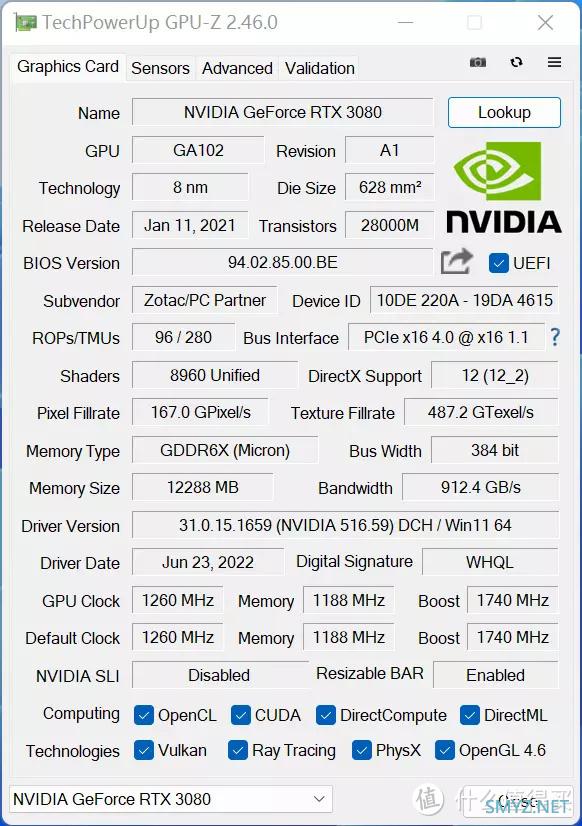

第四刀:RTX 3080 12GB

通过对GA102-225-A1砍掉10组SM簇,得到了GA102-220-A1核心,也就有了RTX 3080 12GB,值得注意的是相对于满血版的GA102-350-A1而言,是直接砍掉了1个GPC单元+2组SM簇。

▲RTX 3080 12GB所使用的GA102-220-A1核心构架图

▲RTX 3080 12GB所使用的GA102-220-A1核心

▲RTX 3080 12GB使用了6个GPC单元构成,5个GPC的SM簇为12个,1个GPC的SM簇为10个,共70个SM簇,所以可以计算出:

70(SM簇)*128(流处理器)=8960(流处理器)

70(SM簇)*1(RT光追核心)=80(RT光追核心)

70(SM簇)*4(Tensor推理核心)=320(Tensor推理核心)

70(SM簇)*4(TMUs纹理单元)=320(TMUs纹理单元)

6(GPC)*16(ROPs光栅单元)=96(ROPs光栅单元)

12(显存控制器)*32bit(位宽)=384bit(显存位宽)

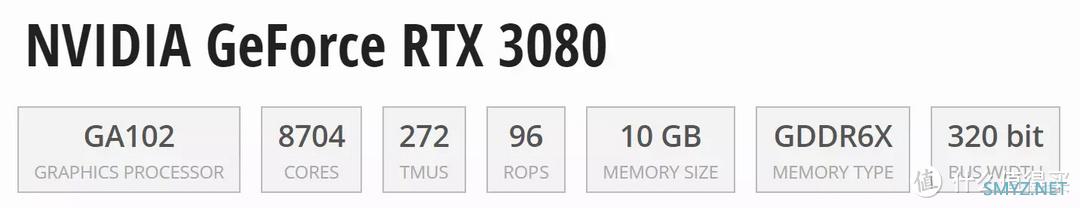

第五刀:RTX 3080

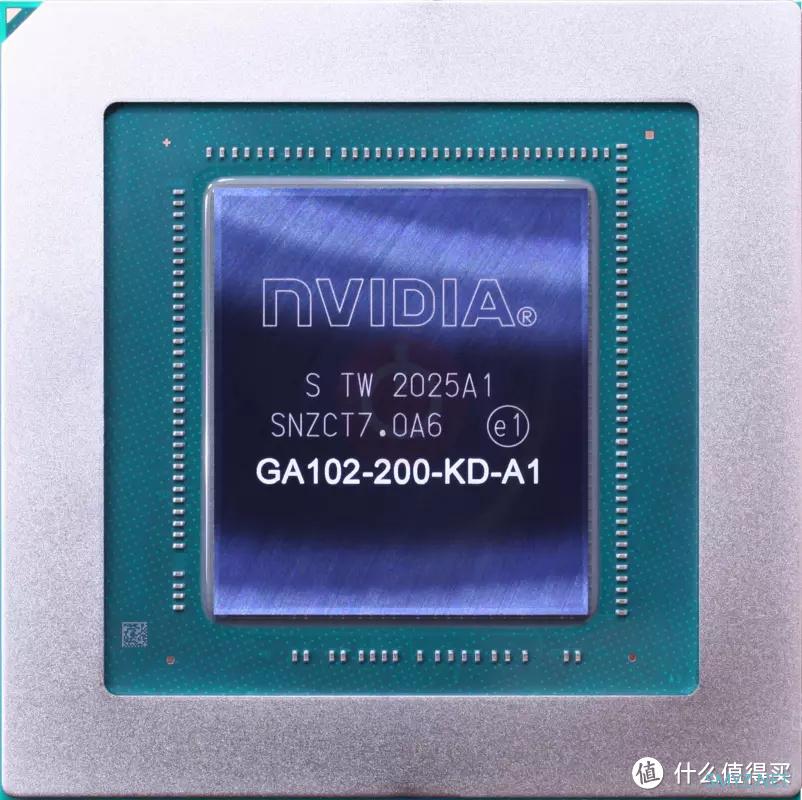

通过对GA102-220-A1砍掉2组SM簇,然后屏蔽12组显存控制器重的两组,得到了GA102-200-KD-A1核心,也就有了RTX 3080。

▲RTX 3080 10GB所使用的GA102-200-KD-A1核心构架图

▲RTX 3080 10GB所使用的GA102-200-KD-A1核心

▲RTX 3080 使用了76个GPC单元构成,4个GPC的SM簇为12个,2个GPC的SM簇为10个,共68个SM簇,显存控制器由12组缩减到10组,所以可以计算出:

68(SM簇)*128(流处理器)=8704(流处理器)

68(SM簇)*1(RT光追核心)=80(RT光追核心)

68(SM簇)*4(Tensor推理核心)=320(Tensor推理核心)

68(SM簇)*4(TMUs纹理单元)=320(TMUs纹理单元)

6(GPC)*16(ROPs光栅单元)=96(ROPs光栅单元)

10(显存控制器)*32bit(位宽)=320bit(显存位宽)

从这五招刀法可以看出,按照刀法的狠辣角度去研究,其实RTX 3080 12GB性能应该更接近于RTX 3080而不是RTX 3080 Ti。另外由于新立的GA102-220-A1核心,也直接的和以往的矿卡核心做了足够明显的隔离,所以今天也带来了今天的评测对象,索泰ZOTAC RTX 3080 12GB 天启OC。

开箱

▲包装正面

▲包装背面

▲侧面

▲内盒

▲全家福

▲正面

显卡采用暗影疾风扇叶,三个扇叶大小不一,两侧90mm直径11叶无光风扇,中间的80mm直径9叶RGB风扇。

▲背面

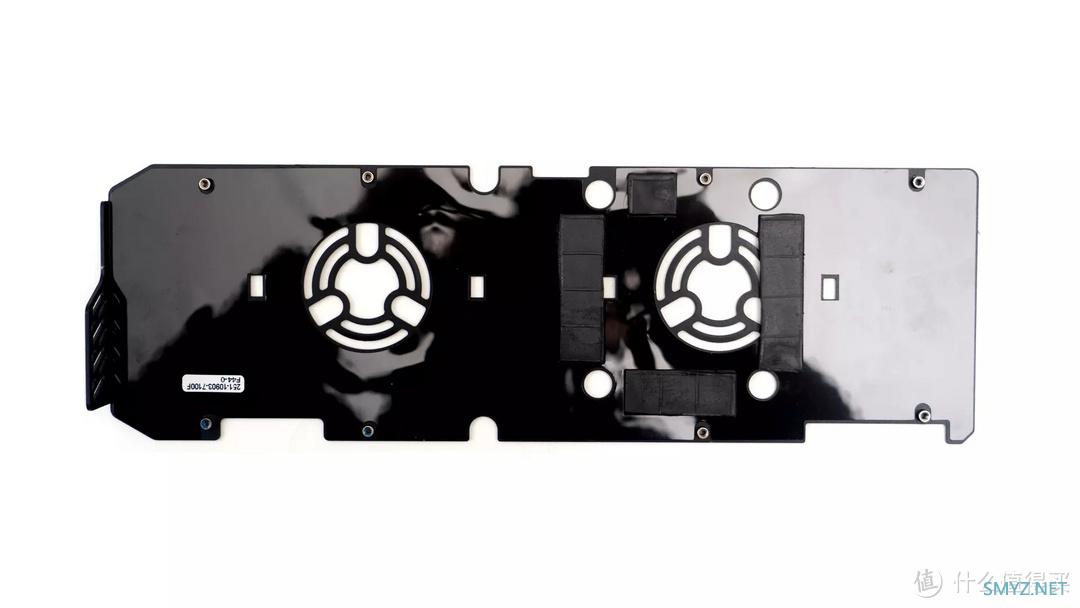

背板采用铝锌合金材质,带有PCB背板风扇卡槽,可自由安装背部风扇进行主动散热。

▲顶部的AGRB光效仅限于ZOTAC字样的LED灯板,供电为双8PIN设计。

▲底部

▲IO挡板部分为3DP+1HDMI的设计,卡的厚度是标准的三槽设计,但是不越肩。

▲侧面

索泰这张卡的尺寸为309mm*136mm*61mm,厚度为3槽。

▲PCB背板风扇,自带ARGB同步效果

▲显卡的顶部有2个3D storm接口用于接驳两颗背板风扇,可提供电以及RGB的协同效果控制。

▲可以用这两个接口接驳RGB背板风扇组成这样的合体形式是为了在高热情况下增强显卡的散热能力。但是也会增加显卡的厚度到3.5槽,同时噪音也会增大一点。

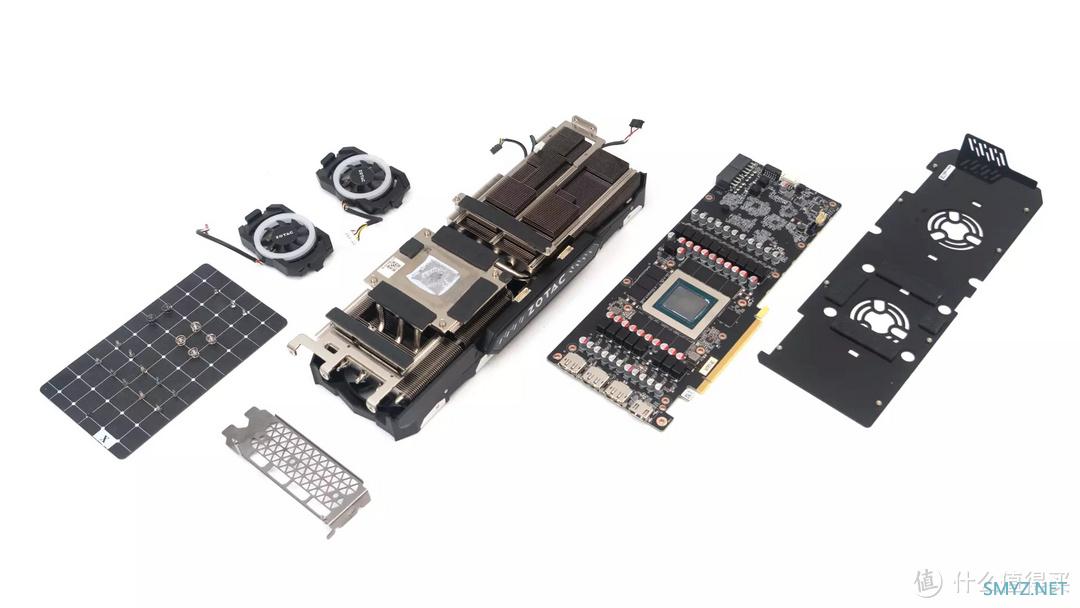

拆解

▲因为这张卡背面没有螺丝标签,所以随便拆。

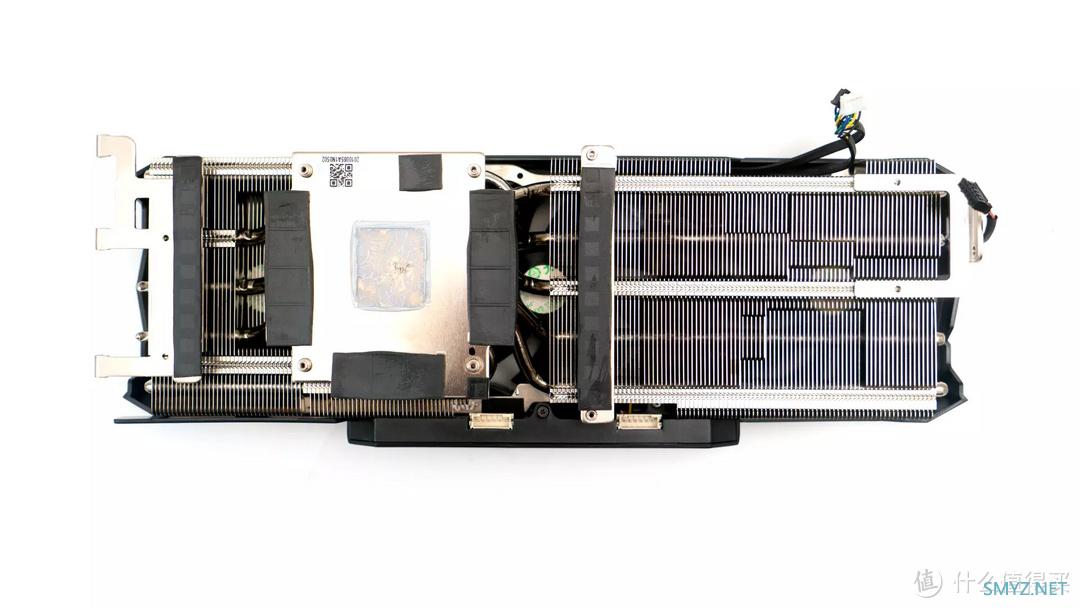

▲散热器正面

▲散热器侧面

▲散热器前面

在散热方面,显卡拥有5根直径为6mm的镀镍热管,配合镜面抛光散热铜底,使散热模组与GPU以及显存紧密接触。

▲RTX3080 12GB VS RTX3060 12GB天启版本的散热器对比,在热管数量上明显RTX 3080 12GB多出一根。

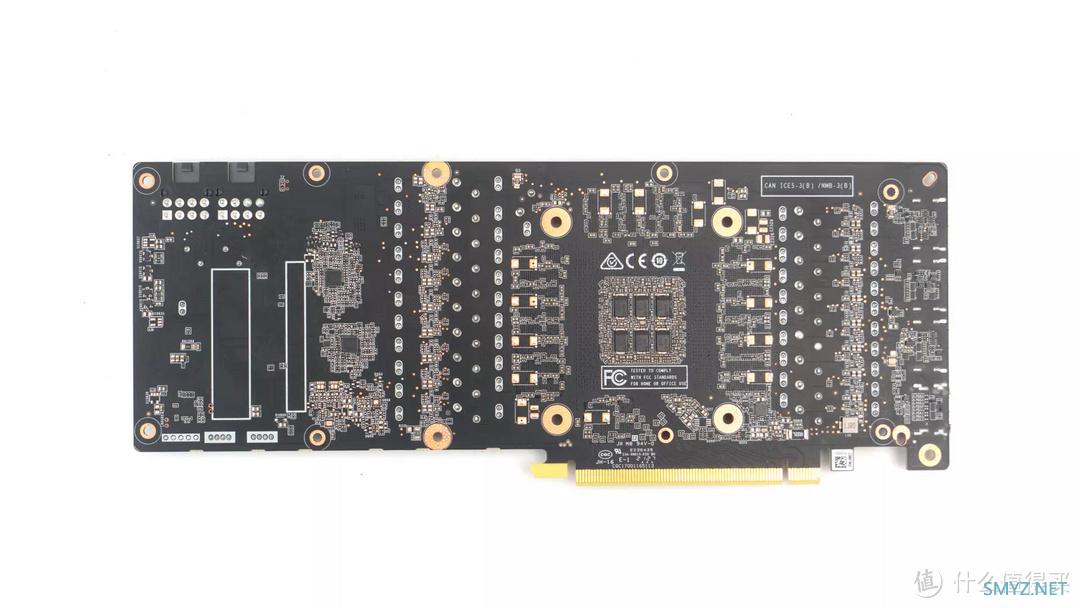

▲背板

显卡背板采用铝锌合金材料,在显存颗粒的背面拥有导热硅胶垫,其作用是更加快速的将PCB背面的热量传递到金属背板上,起到辅助散热的作用。

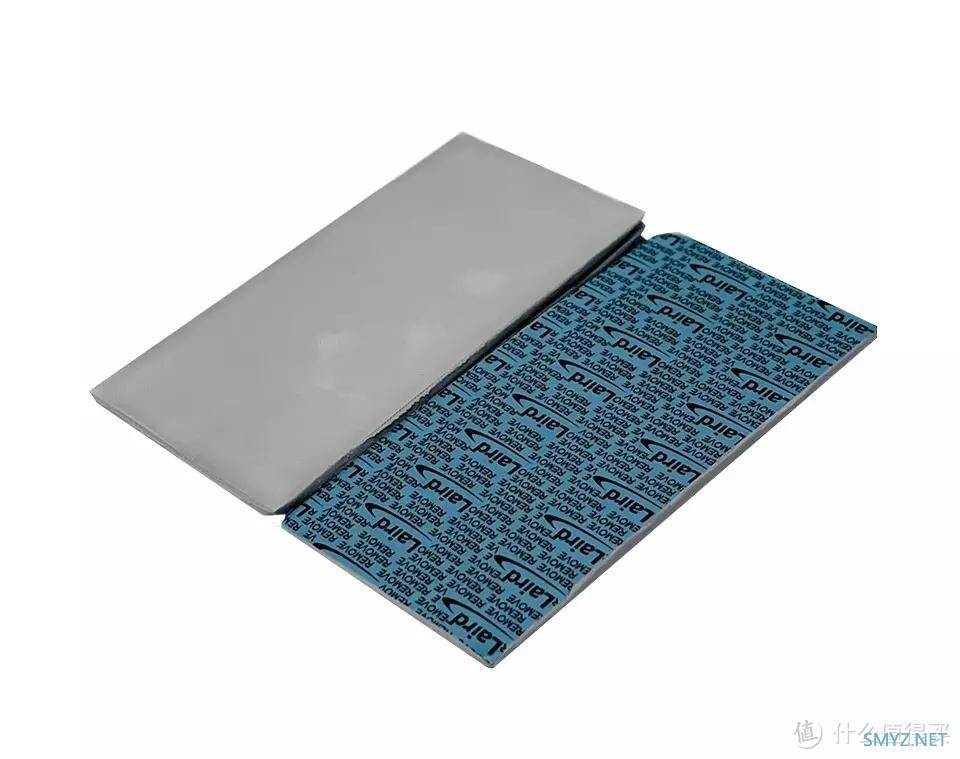

▲建议在拆卡这时候使用莱尔德Tflex HD90000相变硅脂垫把卡上所有的硅脂垫都换掉,尤其是背板上的硅脂。

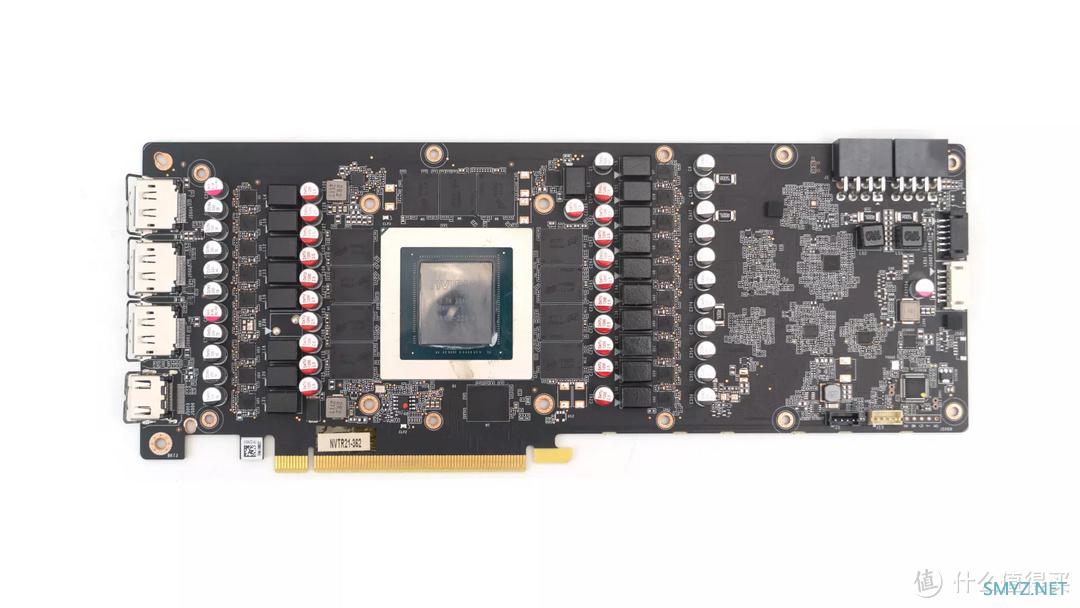

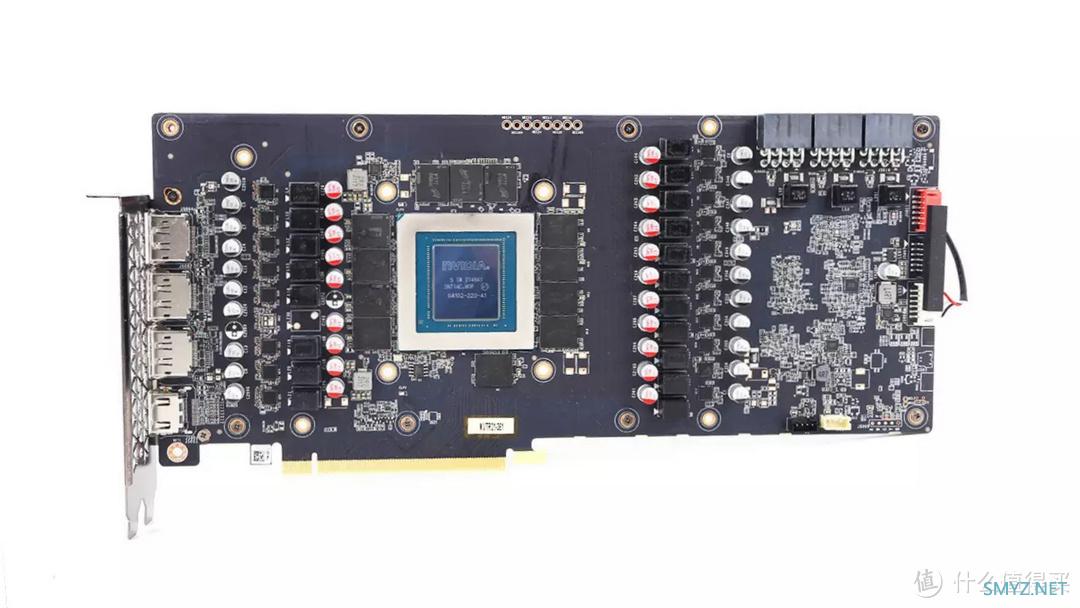

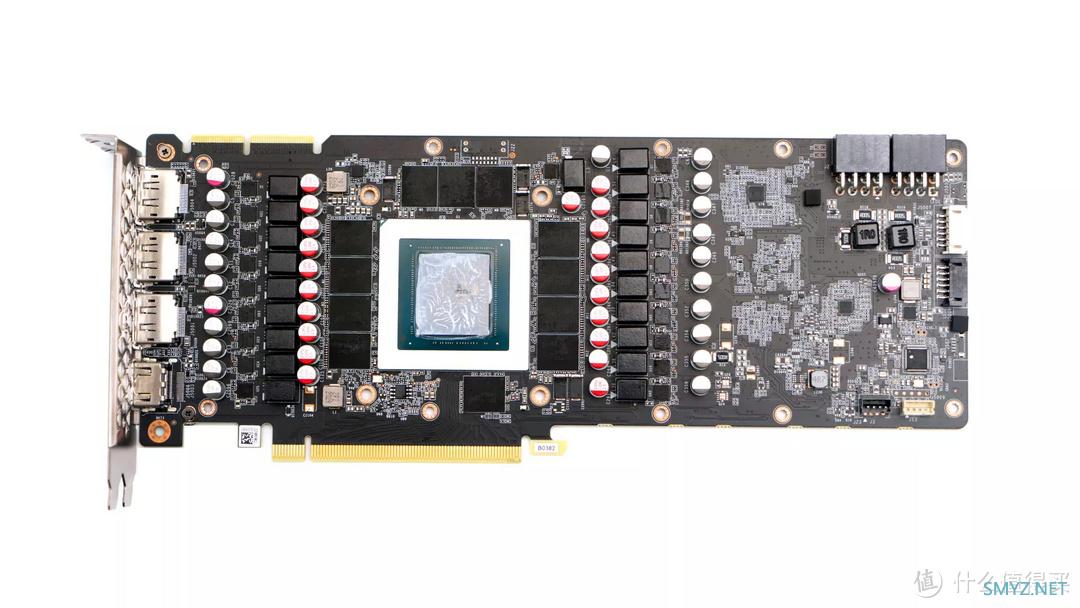

▲天启RTX3080 12G的PCB基于nvidia PG132 SKU 30参考设计。

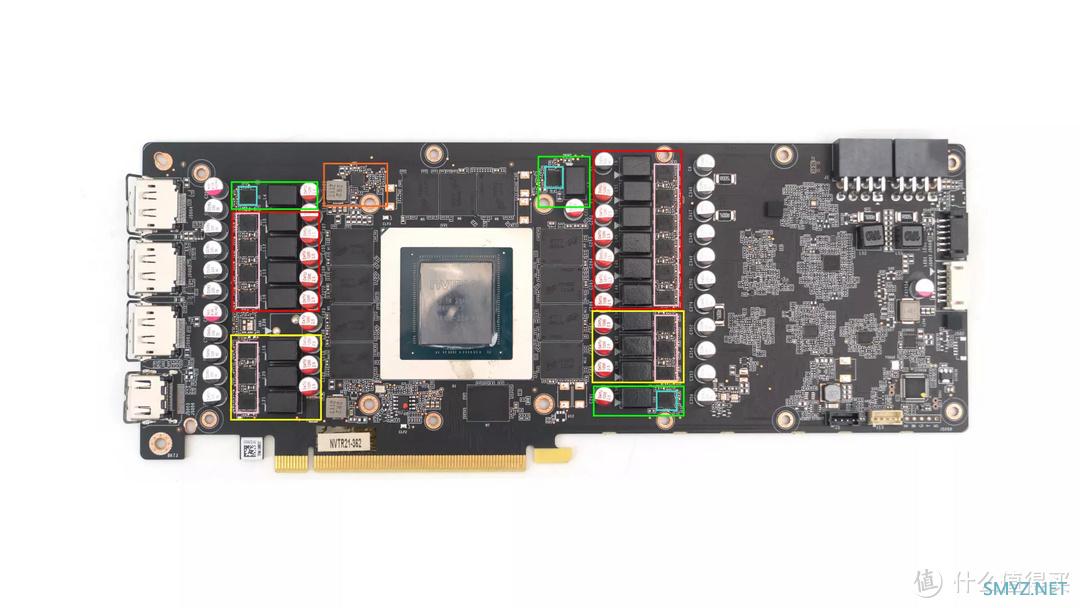

▲显卡供电在GPU和VRAM部分采用16+3+1的设计,

GPU核心供电:分为NVVDD(红)与MSVDD(黄)两个部分,其中NVVDD(红)10相,MSVDD(黄)6相。

VRAM显存供电:分为VRAM VDD(绿)和VRAM VPP(橙)两个部分,其中VRAM VDD(绿)供电部分3相,VRAM VPP(橙)1相。

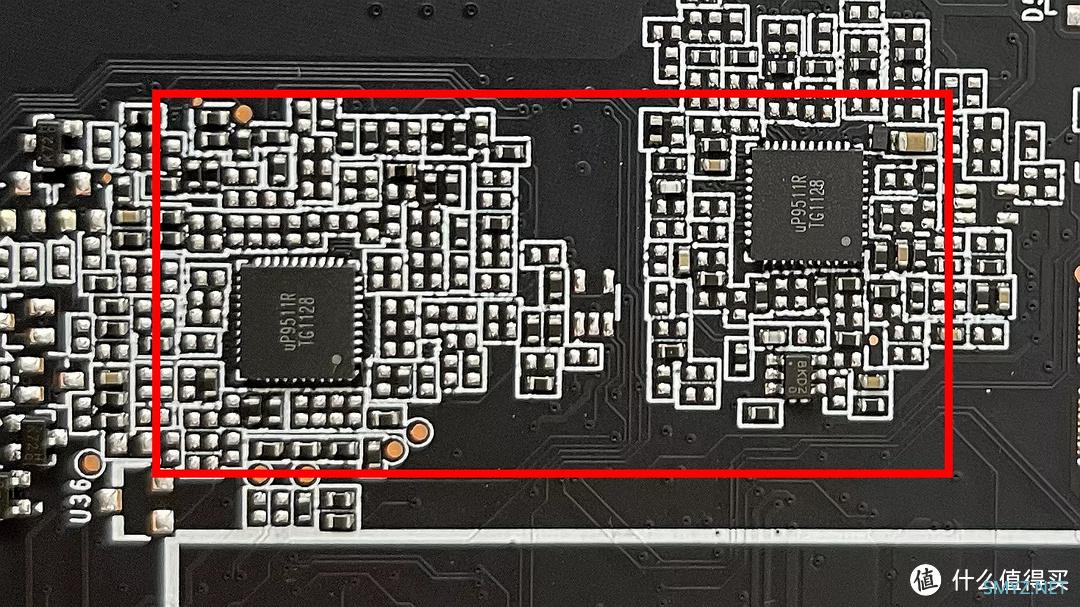

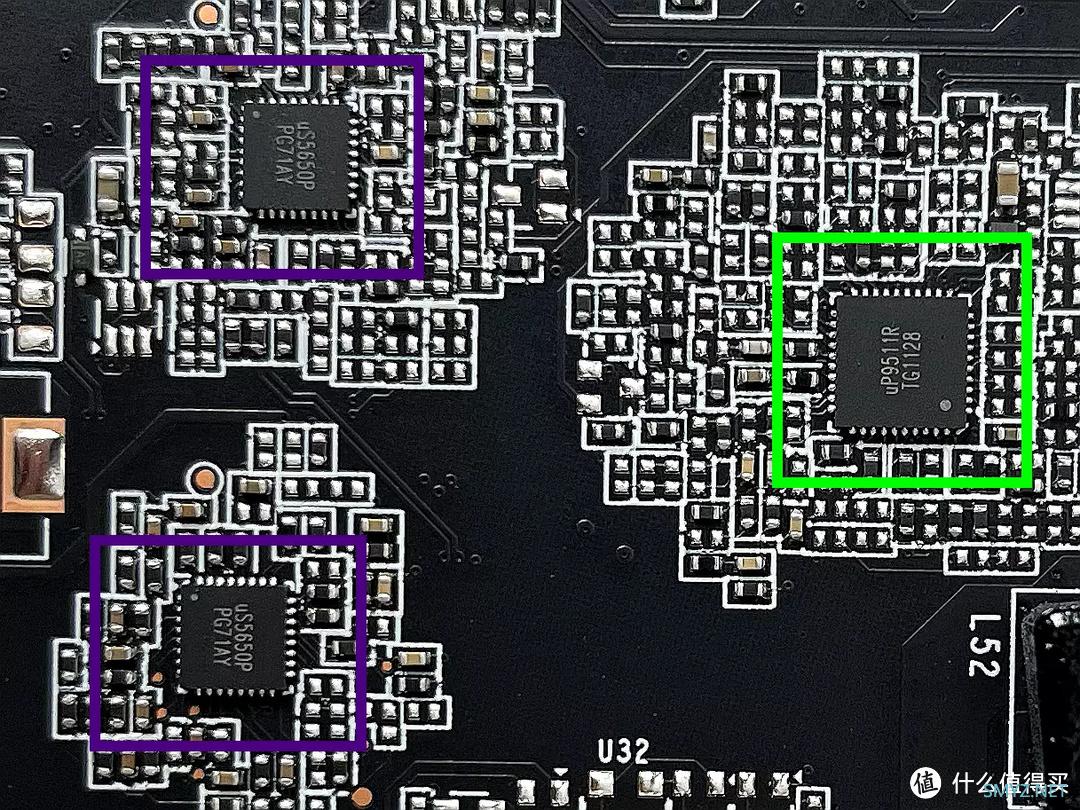

▲PCB背面GPU核心供电部分的PMW主控芯片使用了两颗UPI Semiconductor的uP9511R(黑)用于管理NVVDD和MSVDD,该芯片支持NVIDIA Open VReg Type 4i/Type 8 PWMVID标准,单颗最高可支持8相。

▲PCB正面显存VRAM供电中的VRAM VDD(绿)供电部分的PMW主控芯片同样使用了一颗8相的UPI Semiconductor的uP9511R,不过这里仅仅用了3相。

左边的两颗芯片是UPI Semiconductor的uS5650P,用于监控VRM电压和电流,以及功率统计监测。

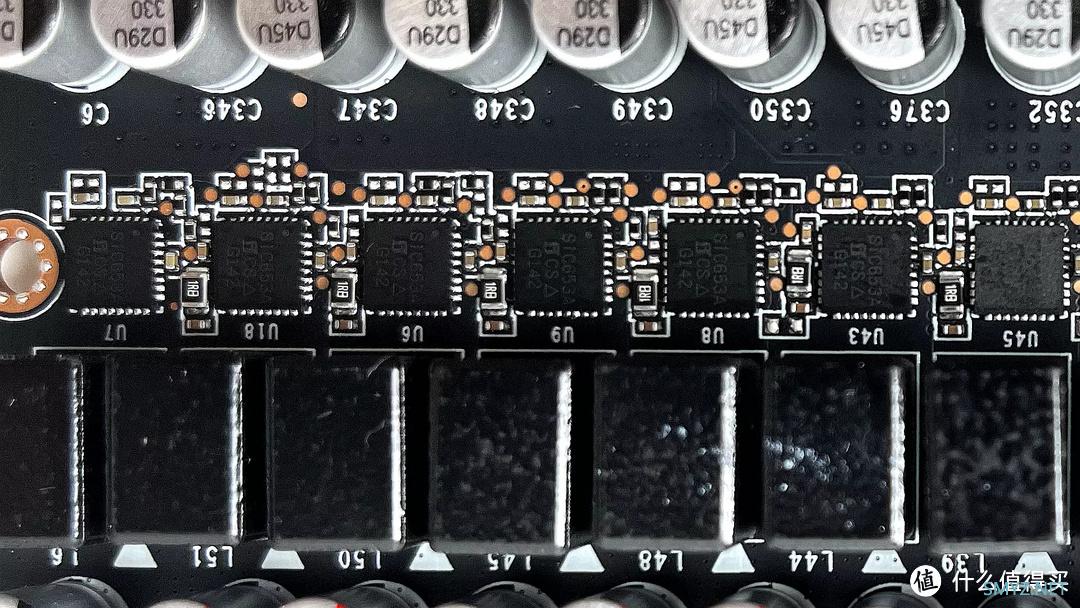

▲GPU核心部分(NVVDD+MSVDD)和VRAM VDD供电部分的Mosfet用的是Vishay SiC653A,额定50A。

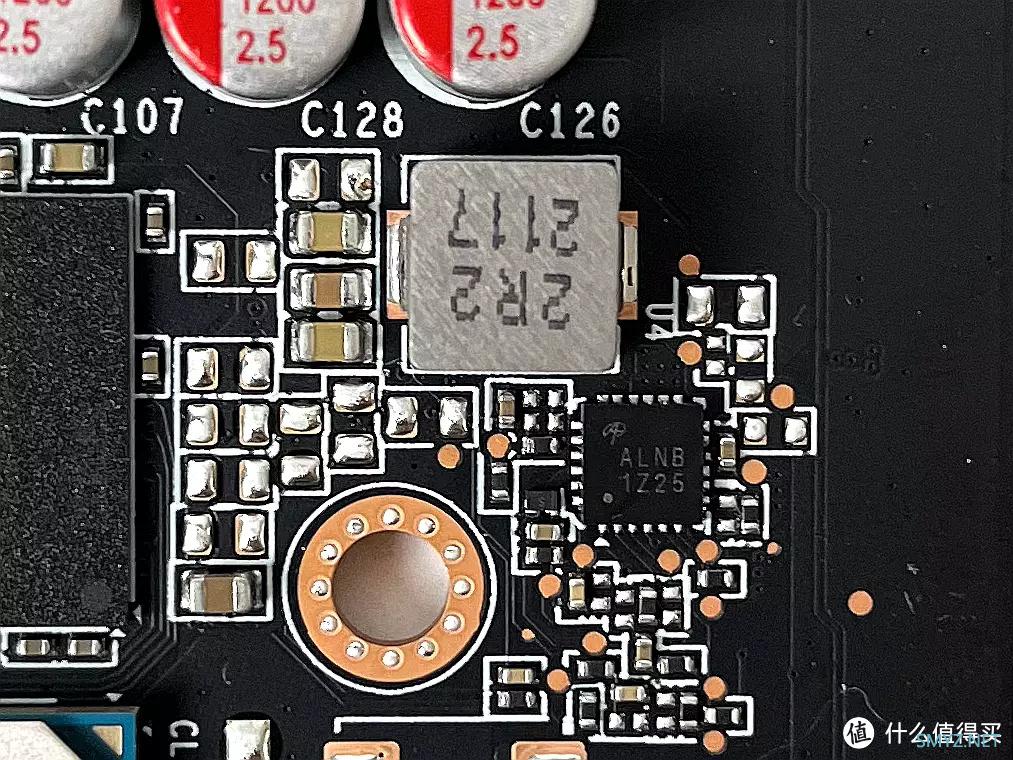

▲PCB正面顶部有一颗AOZ2261NQI-11(ALNB),这是来自Alpha & Omega Semiconductor的降压开关稳压器,用于支持VRAM VPP的1相,额定电流50A

GPU核心部分(NVVDD+MSVDD)

PMW芯片:UPI Semiconductor uP9511R x2

Mosfet:Vishay SIC653A x16

相数:16

显存VRAM部分(VRAM VDD)

PMW芯片:UPI Semiconductor uP9511R x1

Mosfet:Vishay SIC653A x3

相数:3

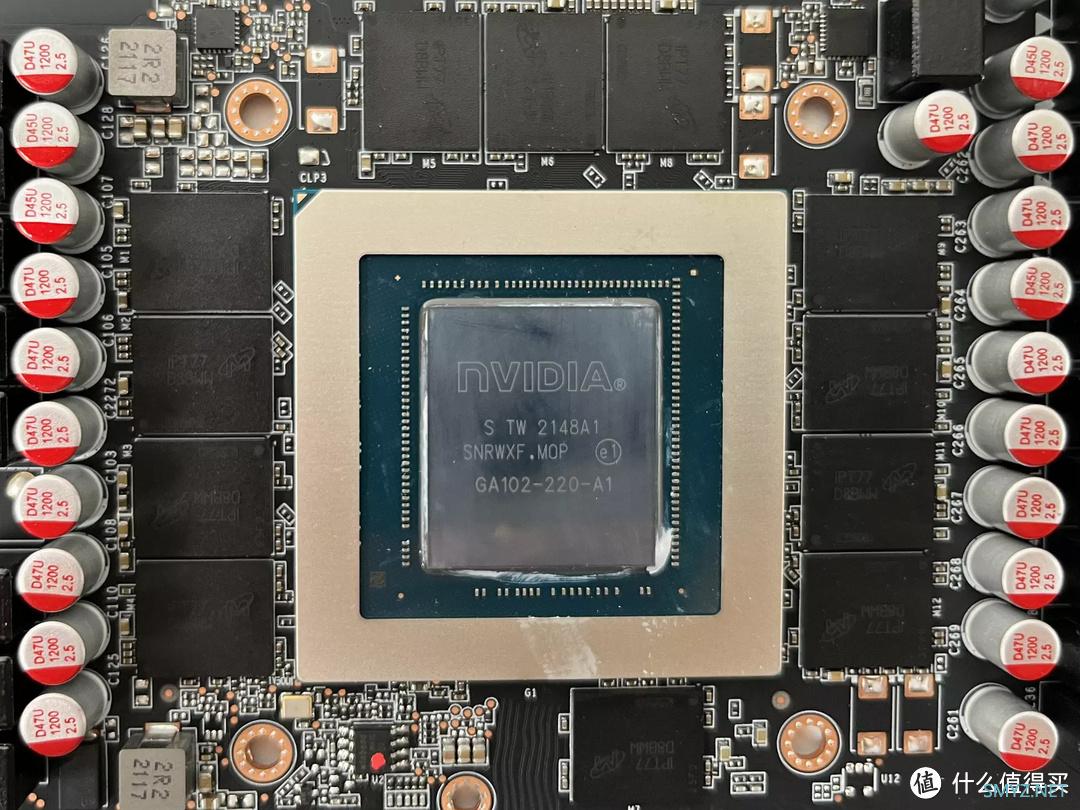

▲RTX3080 12G的GPU为NVIDIA的GA102-220-A1 Ampere架构芯片,三星8纳米工艺生产,晶体管数量为280亿个,管芯尺寸为628mm²。拥有8960个流处理器,基础频率为1440MHz,加速频率1755MHz。

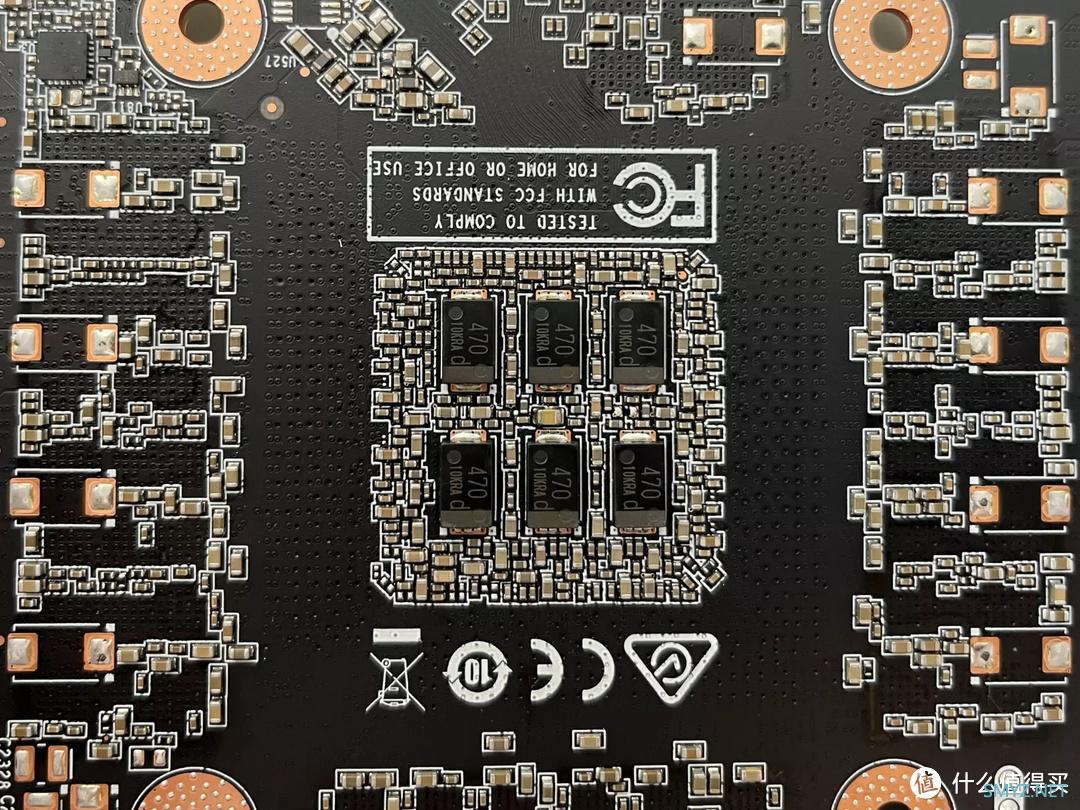

▲GPU背面使用了6颗Panasonic 470µF SP-Cap电容

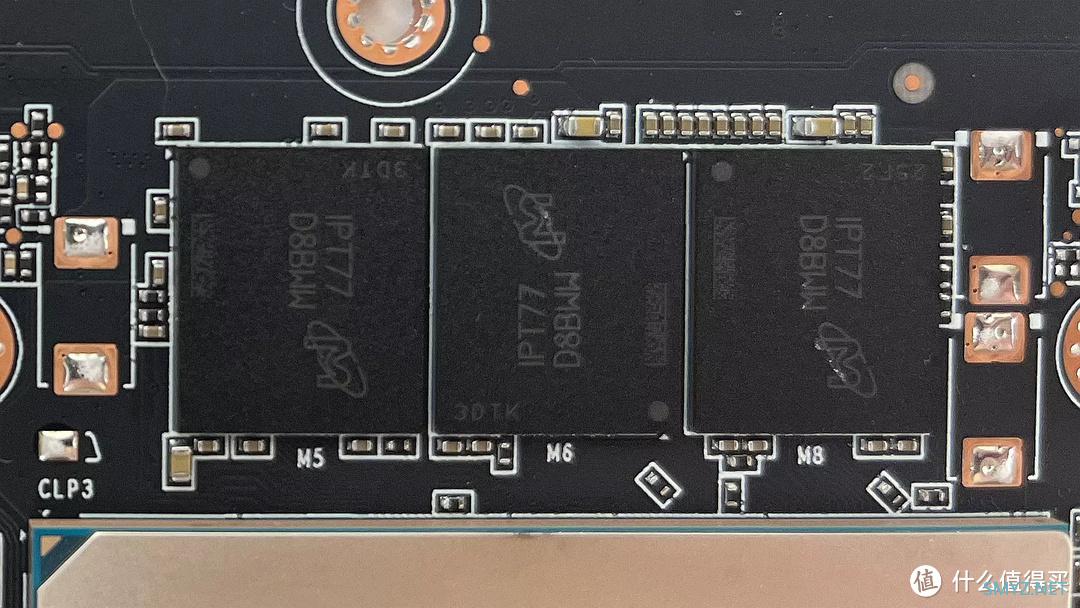

▲显存方面使用了12颗Micron MT61K256M32JE-19G D8BWW GDDR6X组成,每颗容量1GB,总共12GB提供384bit显存位宽,与普遍RTX 3090 会采用的MT61K256M32JE-21 相比主要差在Data Rate 的部分,-19G 的为19 Gb/s、-21 的则是21 Gb/s。

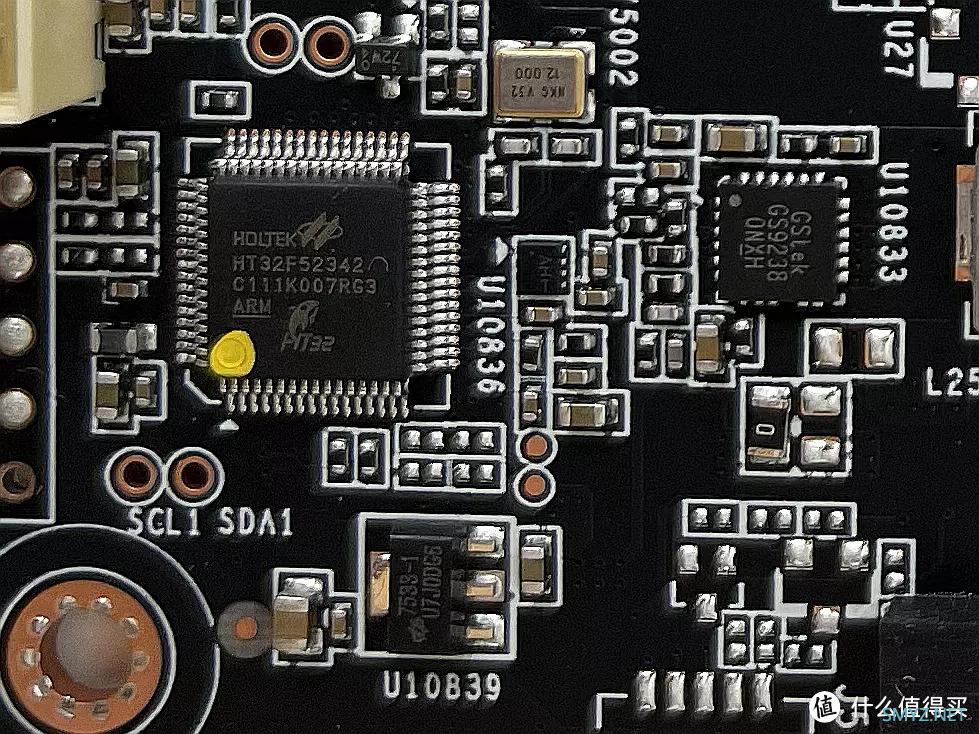

▲Holtek HT32F52342 ARM 32-bit 微控制器负责ARGB LED 发光效果。

总体的解构完毕,至于说这张卡的供电质量如何,我们可以用两张卡的PCB来比较一下:

▲ZOTAC RTX 3080 12GB PGF OC的PCB正面

GPU核心部分(NVVDD+MSVDD)

PMW芯片:UPI Semiconductor uP9511R x2

Mosfet:Vishay SIC653A x16

相数:16

显存VRAM部分(VRAM VDD)

PMW芯片:UPI Semiconductor uP9511R x1

Mosfet:Vishay SIC653A x3

相数:3

可以发现RTX 3080 12GB天启OC的供电方案与索泰旗舰级别的PGF OC完全一致。

▲ZOTAC RTX3090 24GB 天启 OC的PCB正面

GPU核心部分(NVVDD+MSVDD)

PMW芯片:UPI Semiconductor uP9511R x2

Mosfet:Alpha & Omega Semiconductor AOZ5239(AL00) x16

相数:16

显存VRAM部分(VRAM VDD)

PMW芯片:UPI Semiconductor uP9511R x1

Mosfet:Alpha & Omega Semiconductor AOZ5311(BLN0) x4

相数:4

总的来说两片卡的供电方案保持一致,不过因为减少了一半的显存,所以3080 12G将VRAM VDD供电从4相缩减成3相,其他保持不变。综合对比可以感觉出来,天启OC这张卡的供电是没有缩水情况发生。

硬件测试平台

【平台】【处理器】: Intel Core i9 12900K

【主板】: ASRock Z690 TaiChi (Bios Rev:8.02 BETA)

【内存】: Corsair DOMINATOR PLATINUM RGB 32GB DDR5-5600 KIT(2x16GB)

【硬盘】: Lexar NM800 1TB M.2 PCIe Gen 4X4 SSD

【硬盘】: Lexar NM760 1TB M.2 PCIe Gen 4X4 SSD

【显卡】: Zotac Geforce RTX 3080 12GB Apocalypse OC

【散热】: Corsair iCUE H150i ELITE LCD Display

【机箱】: Corsair iCUE 5000T RGB-Black

【风扇】: Corsair LL120

【电源】: Corsair RM1000x

▲装机全家福展示

▲成品展示角度1

▲成品展示角度2

▲成品展示角度3

▲暗景1

▲暗景2

▲暗景3

▲暗景4

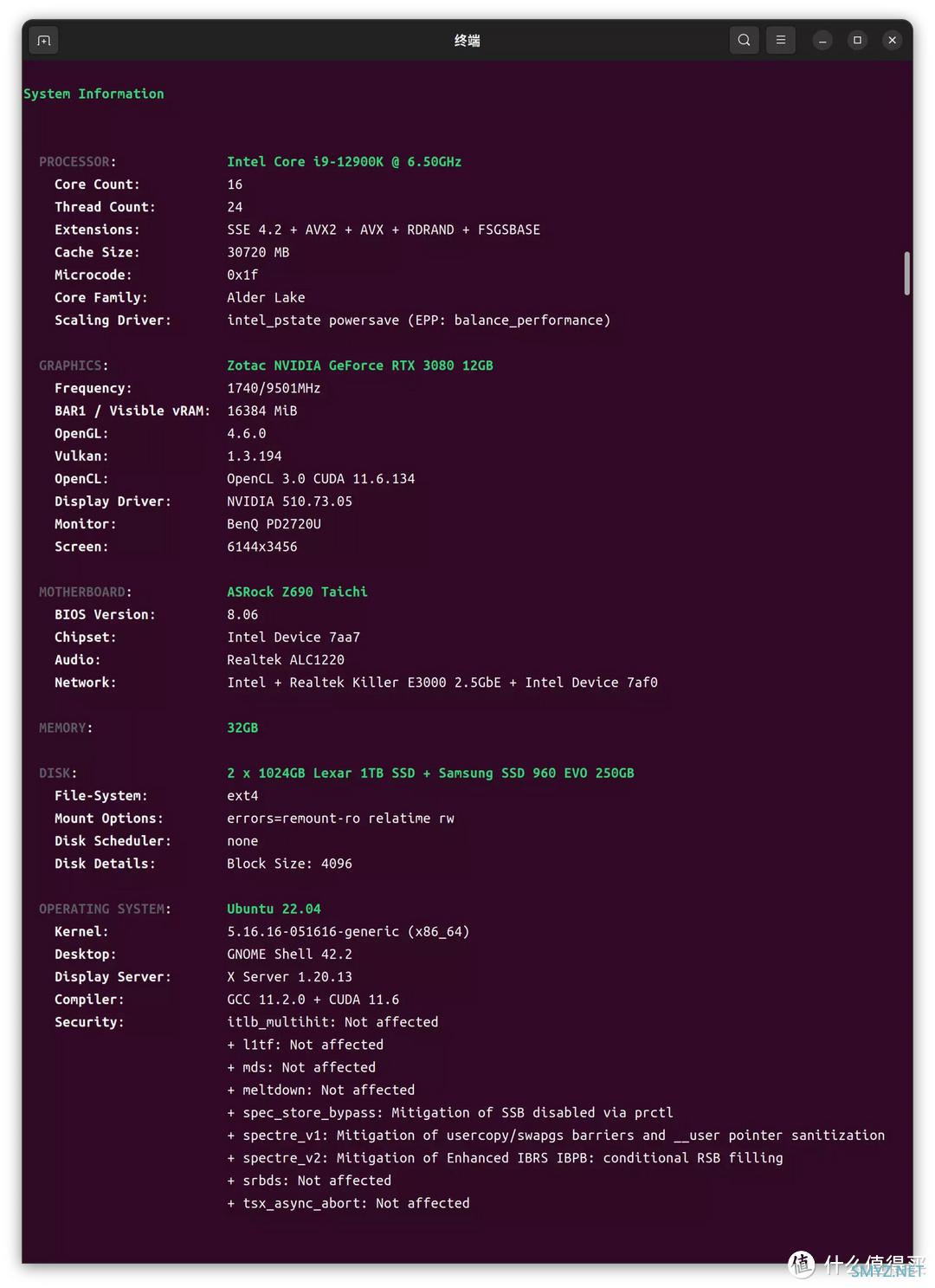

这次的测试分为LINUX和WINDOWS双平台进行,鉴于UBUNTU 22.04发布不久,所以就从UBUNTU 22.04的软件配置说起。

Ubuntu 22.04测试部分

【系统】: Ubuntu x64 22.04【内核】: 5.15.16

【驱动】: NVIDIA 510.74

▲配置检测

一、独立显卡驱动安装

1-1 先更新所有的软件包sudo add-apt-repository ppa:graphics-drivers/ppa # 加入官方ppa源

sudo apt update # 检查软件包更新列表

apt list --upgradable # 查看可更新的软件包列表

sudo apt upgrade # 更新所有可更新的软件包

1-2 安装510驱动

▲安装NVIDIA显卡驱动,默认Ubuntu 22.04安装的是NVIDIA驱510.73.05版本,我们可以在软件与更新中选择安装。

如果想选择手动安装510驱动也是可以的:输入以下指令

ubuntu-drivers devices # ubuntu检测n卡的可选驱动

sudo apt install nvidia-driver-510 # 根据自己的n卡可选驱动下载显卡驱动

1-3 验证

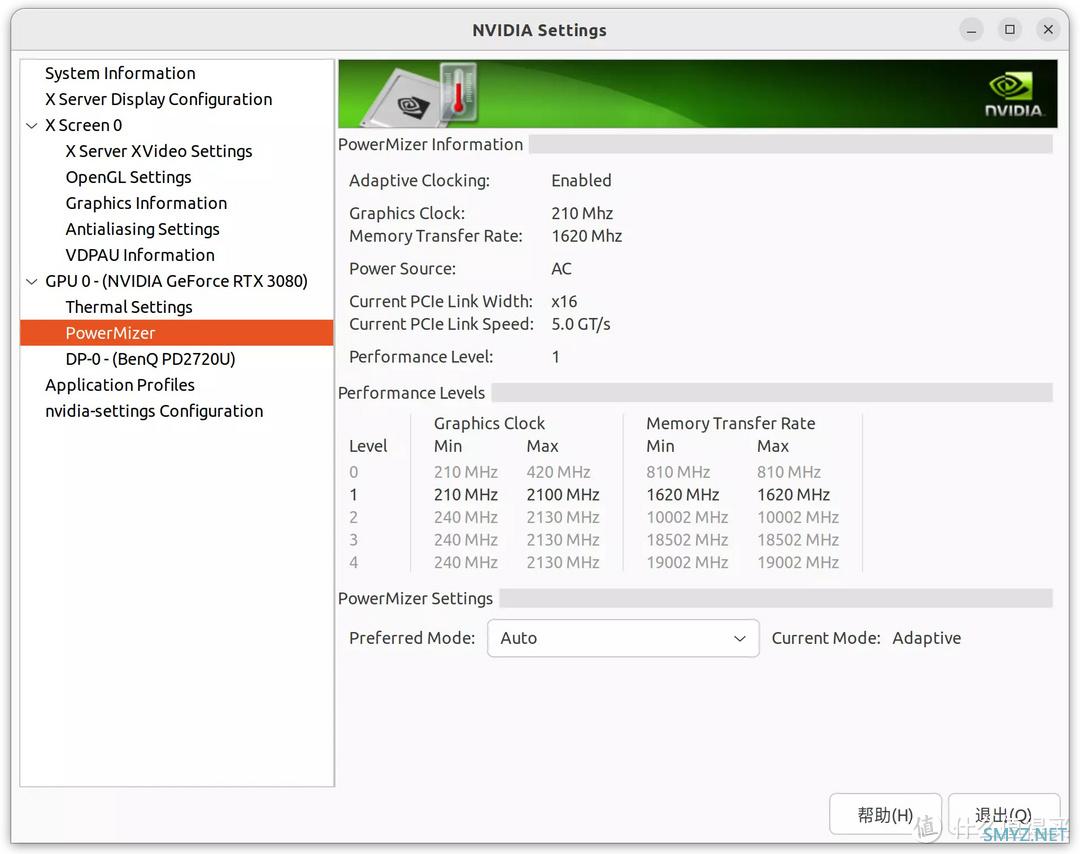

sudo nvidia-settings # 更改Nvidia驱动设置

▲使用以上命令打开NVIDIA控制面板,关于5级功耗可以看到Performance Level分为0,1,2,3,4五级,每一级对应不同的核心显存频率以及不同的功率。

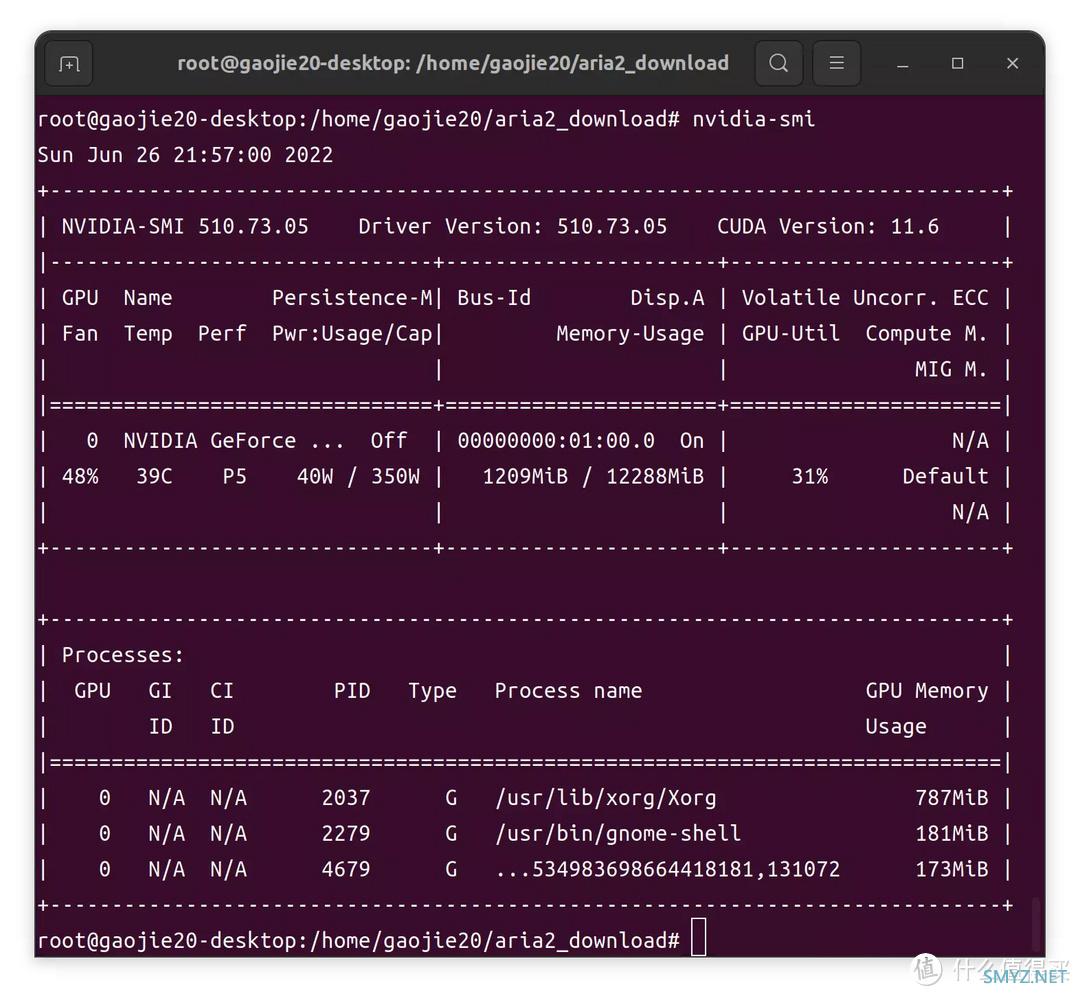

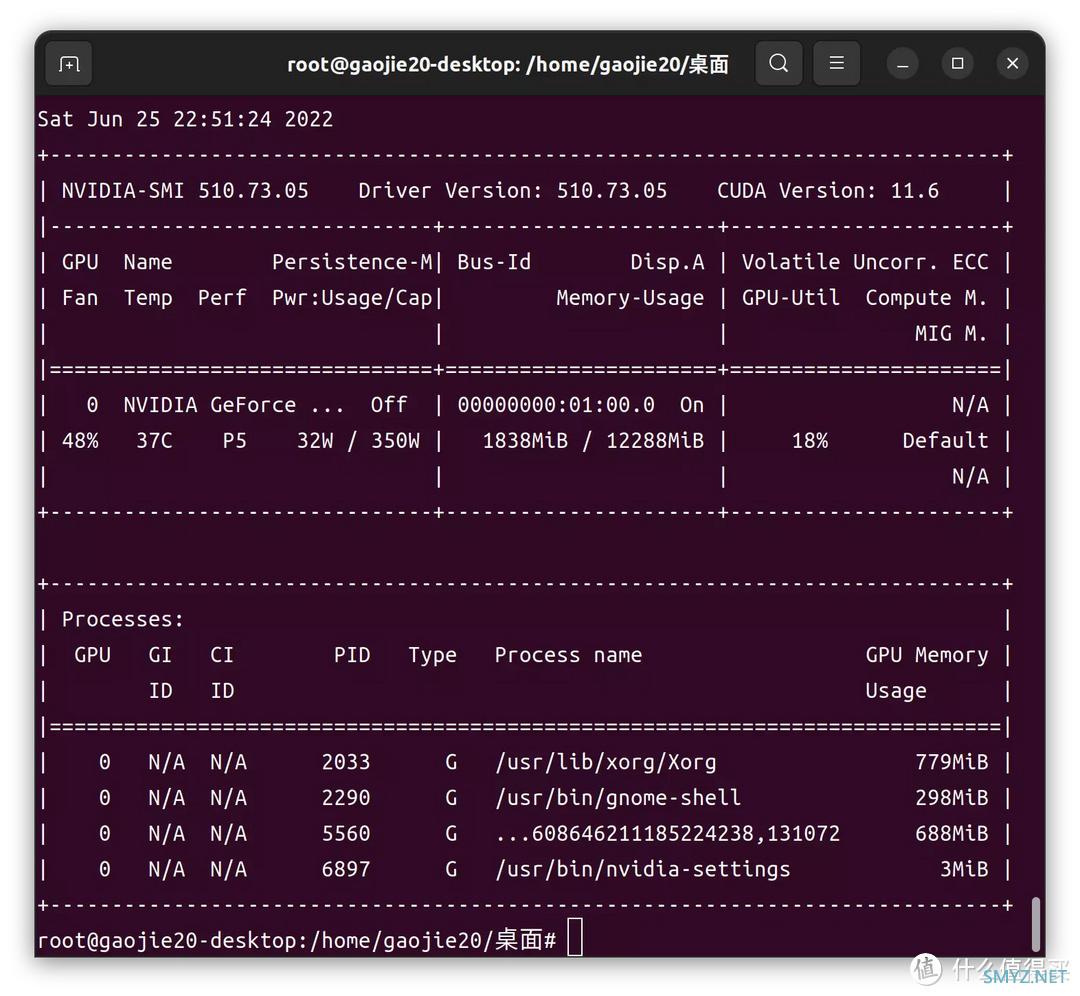

nvidia-smi # 查看显卡基本信息

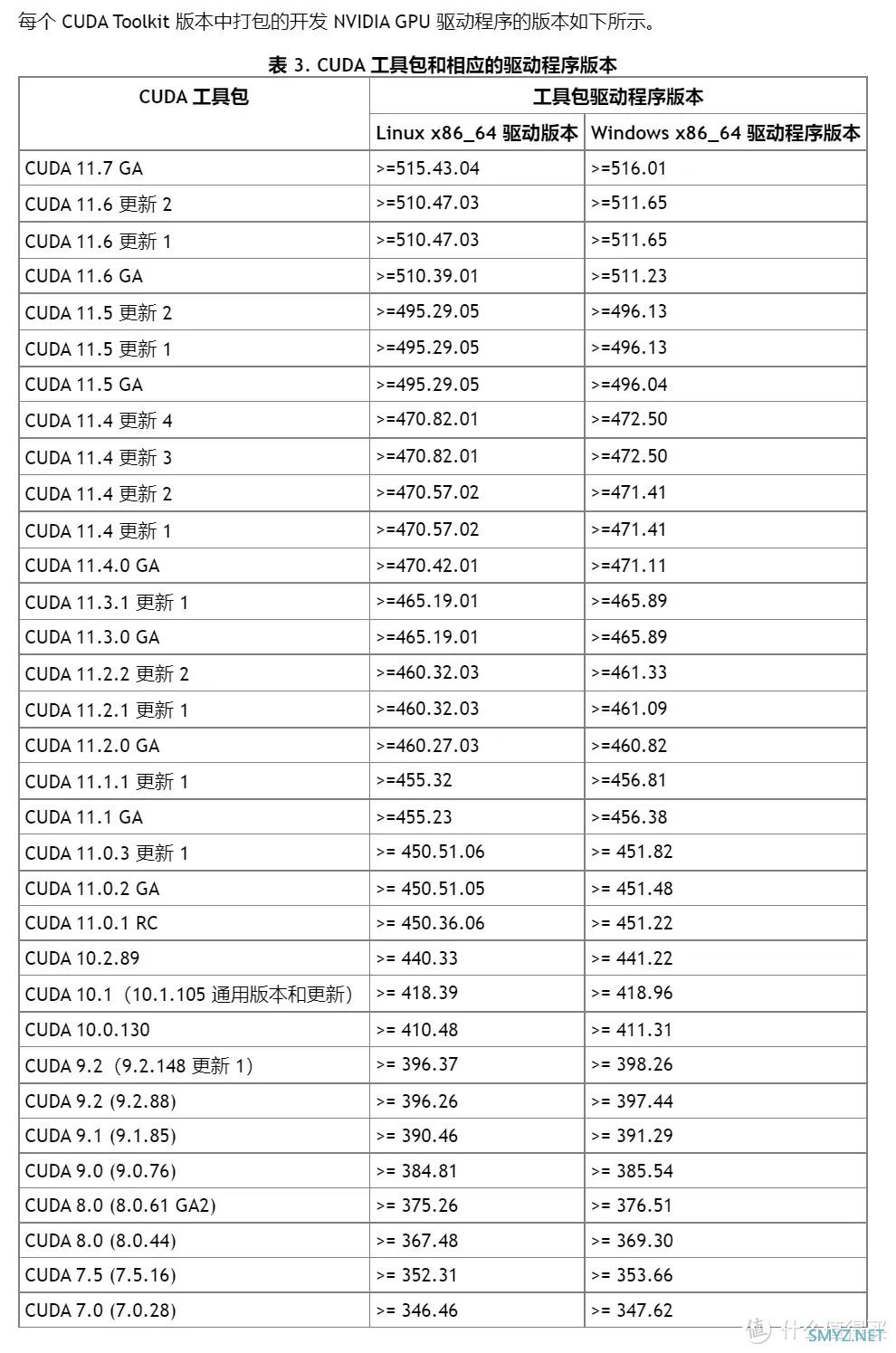

▲nvidia Driver版本是510.73.05,CUDA版本是11.6,其实这个命令可以体现出显卡的功率调节状态是有5级,所以显示P5,当前功耗为32W,最高功耗为350W,这些都是BIOS里面设置好的参数。

下面就需要安装CUDA,在安装CUDA之前,为了确保兼容性问题,我们需要安装GCC组件。

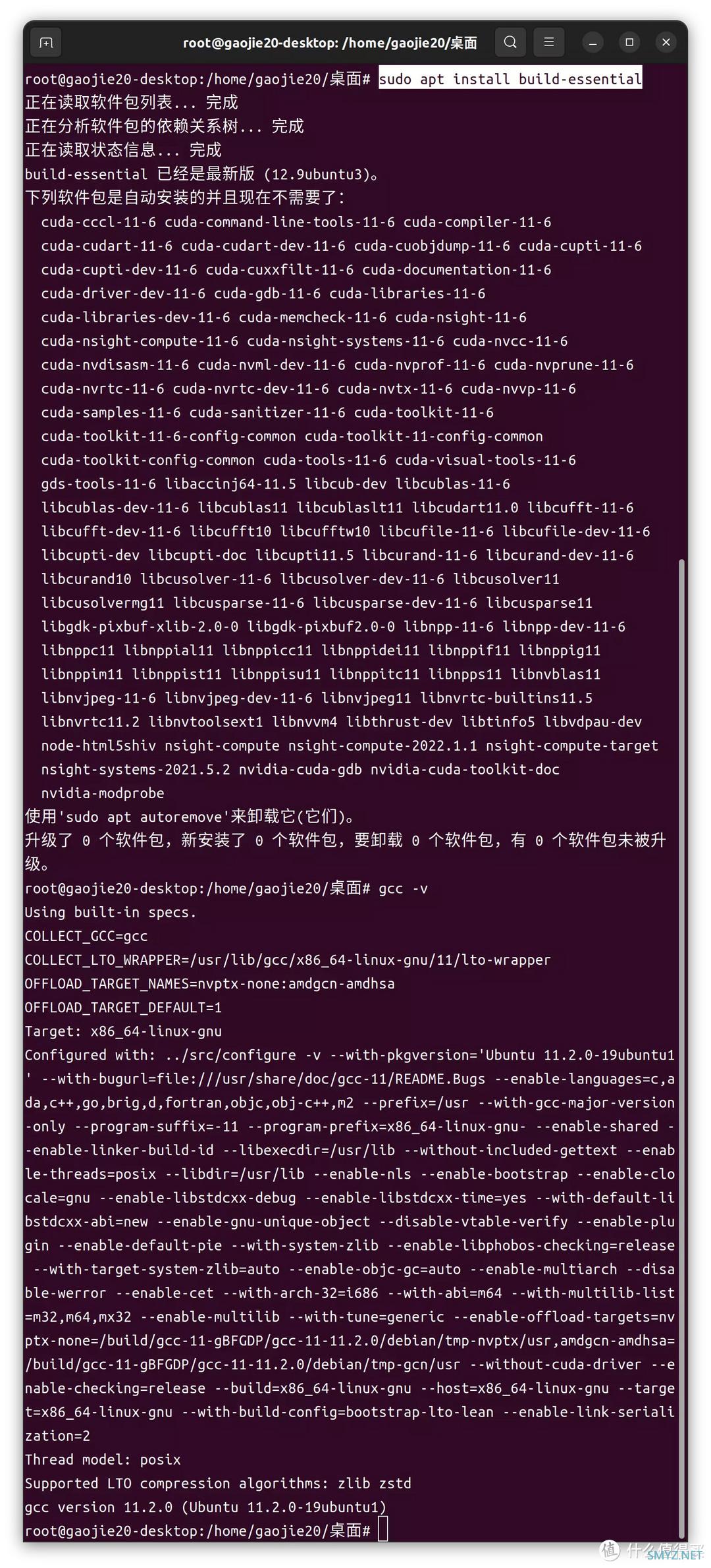

1-4 安装GCC组件和liburcu6

▲安装gcc

sudo apt install build-essential

gcc -v #查看gcc版本

用以上命令安装GCC,默认安装完毕版本是11.2.0。

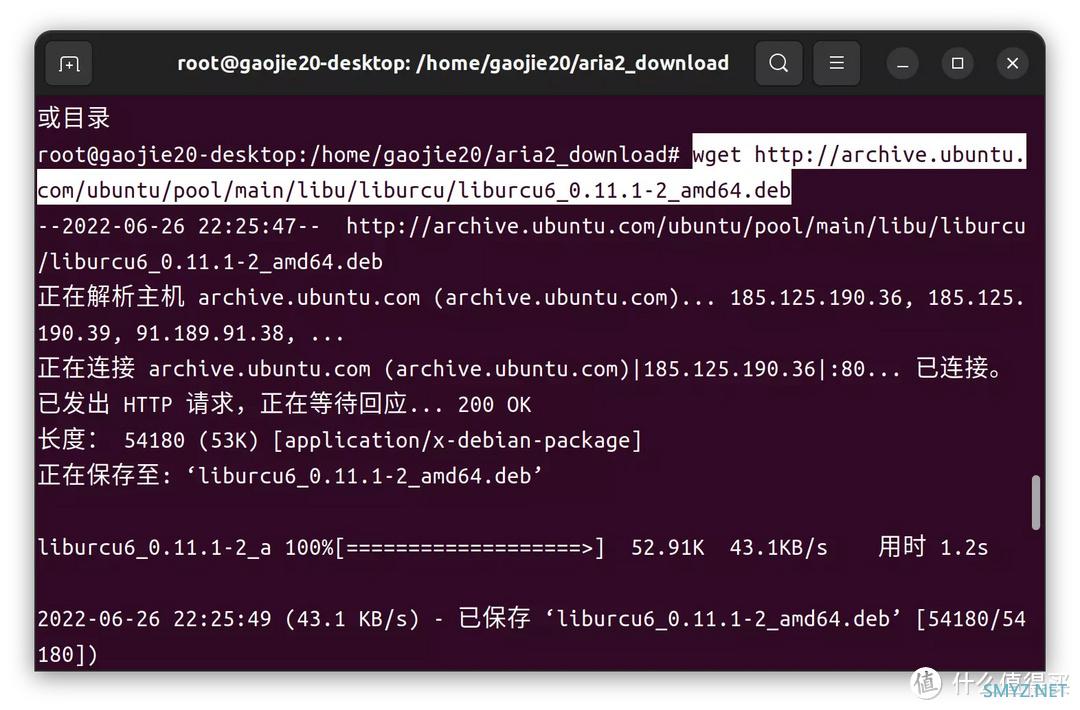

由于ubuntu22.04需要安装liburcu6软件包,不然cuda安装会少依赖。所以这里需要自己下载并安装

wget http://archive.ubuntu.com/ubuntu/pool/main/libu/liburcu/liburcu6_0.11.1-2_amd64.deb

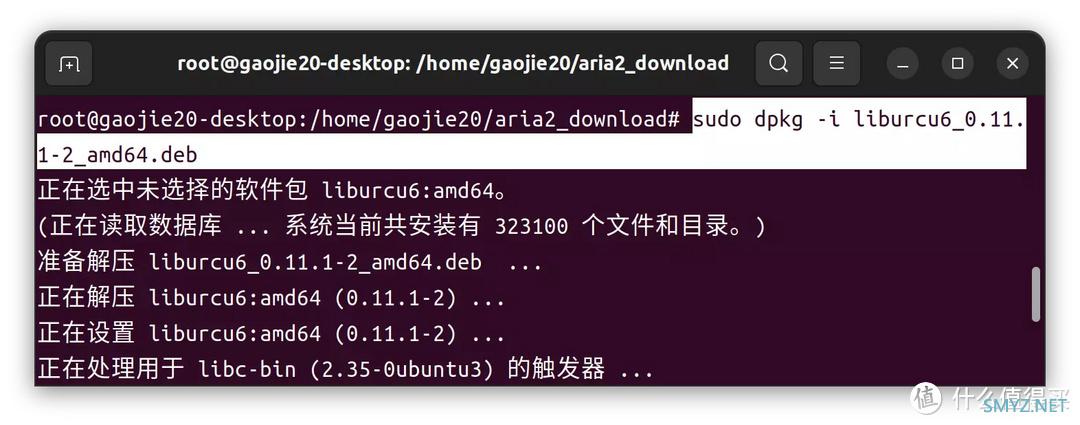

sudo dpkg -i liburcu6_0.11.1-2_amd64.deb

二、CUDA安装

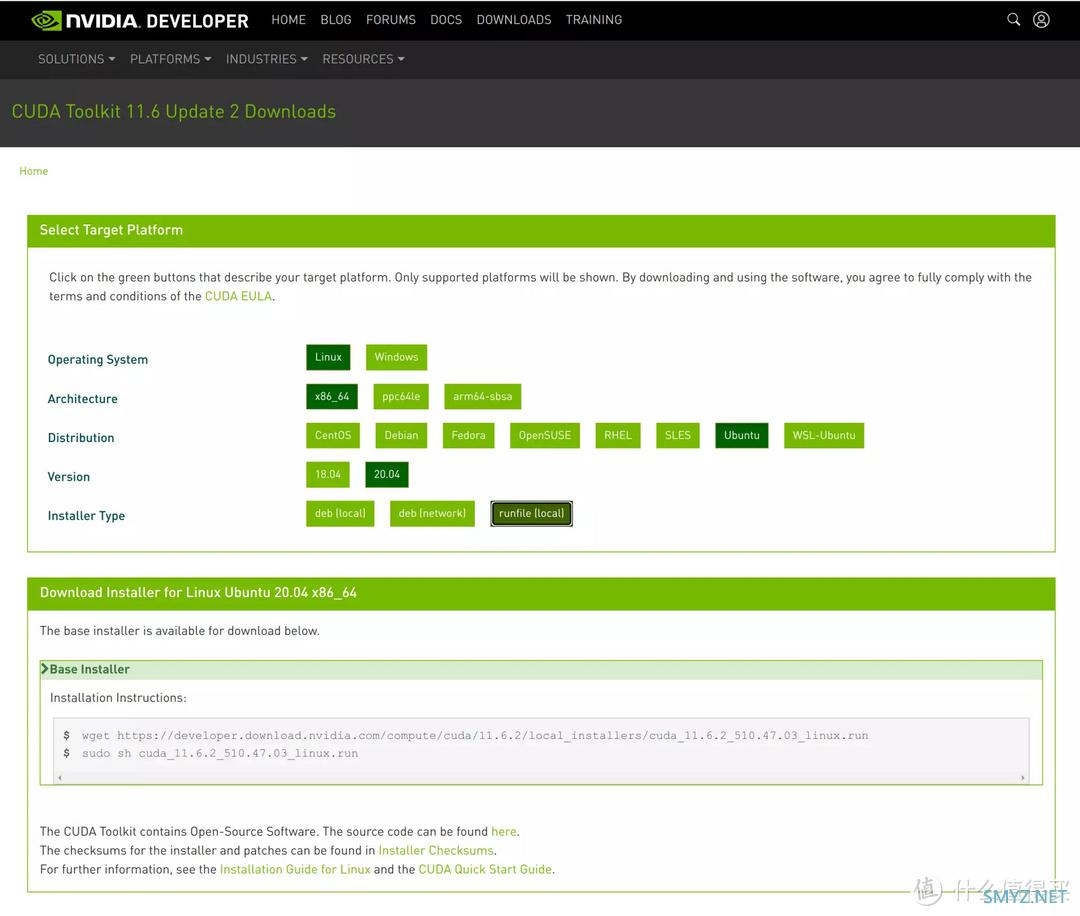

▲这个版本对应的CUDA Toolkit 11.6 update2 版

然后下载安装cuda

▲下载设置如上,或者直接用以下命令下载安装

wget https://developer.download.nvidia.com/compute/cuda/11.6.2/local_installers/cuda_11.6.2_510.47.03_linux.run

sudo sh cuda_11.6.2_510.47.03_linux.run

▲另外也可以使用命令行下载,下载后执行.run

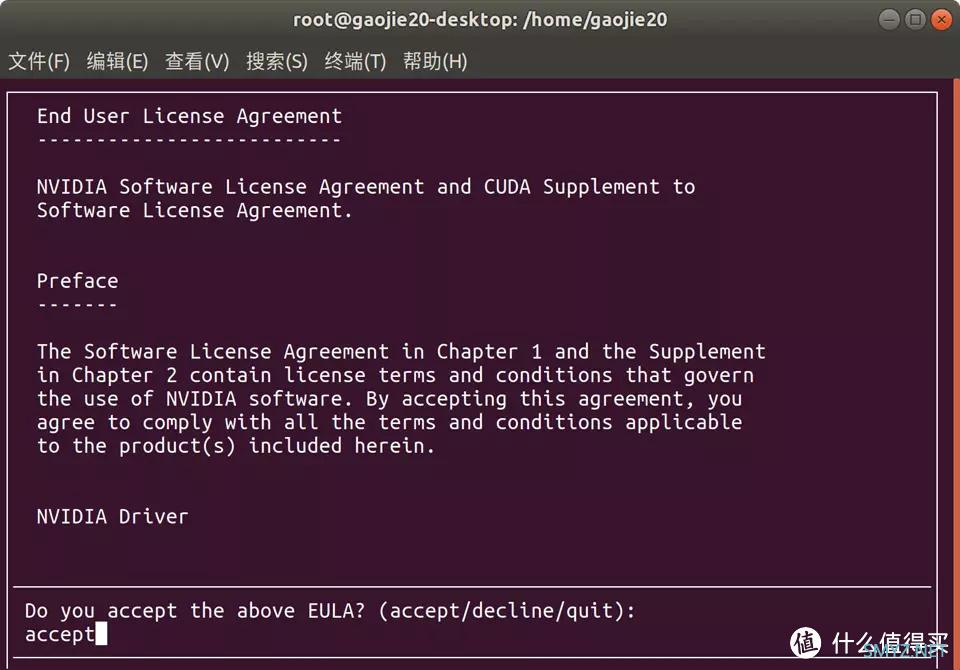

▲输入accept

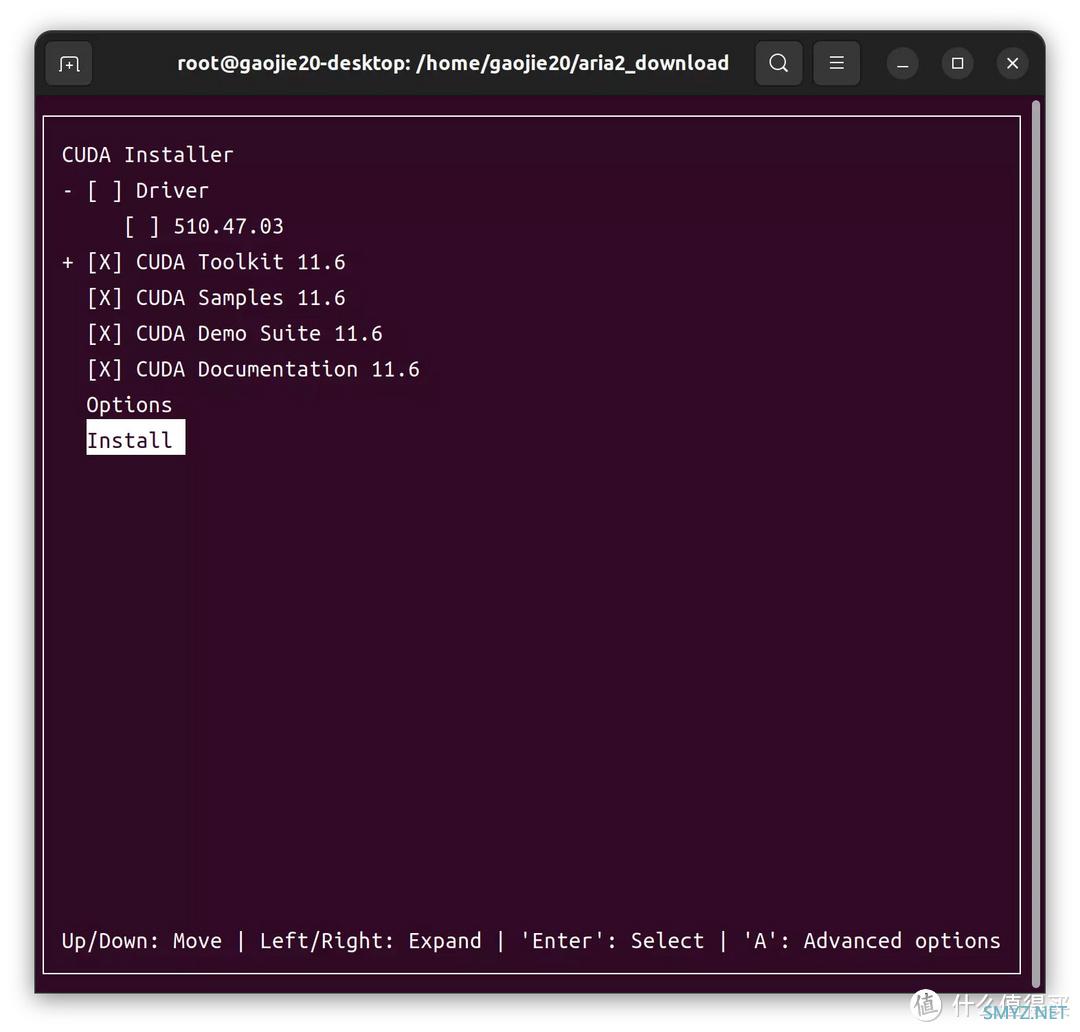

▲除了驱动,全部安装

nvidia-smi

▲这里的CUDA版本是最高支持到,而不代表当前安装的CUDA版本,要知道当前安装的CUDA版本是否正确,请使用以下命令:

nvcc -V

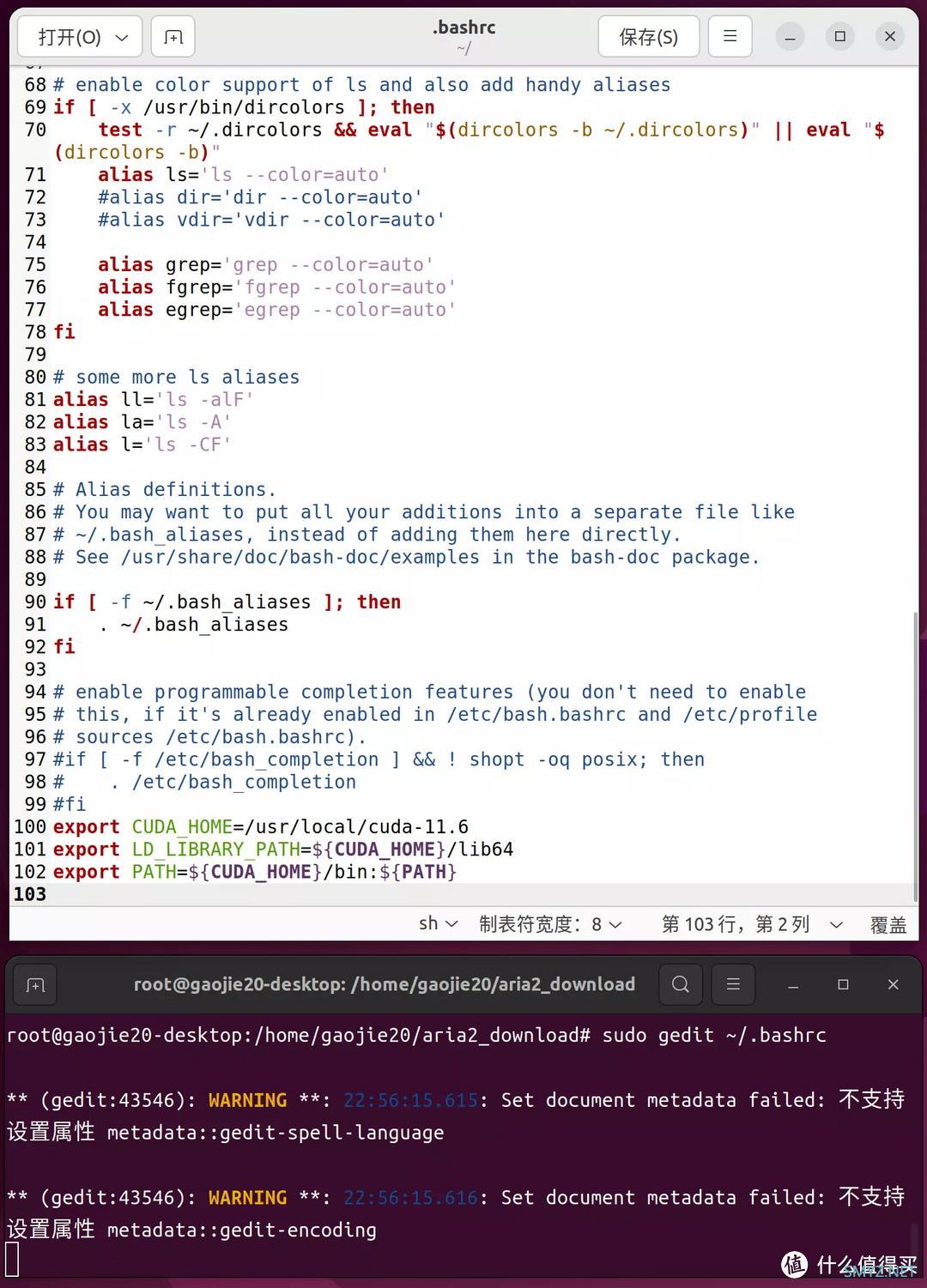

▲可以发现当前系统安装的CUDA版本是11.6。最后我们还要对环境进行编译:

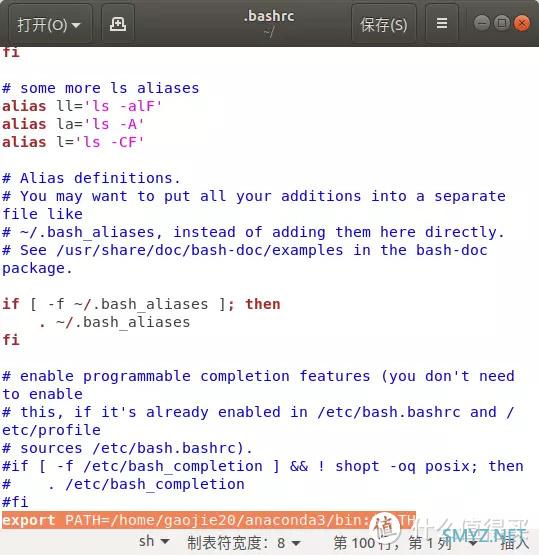

sudo gedit ~/.bashrc

#最后添上:

export CUDA_HOME=/usr/local/cuda-11.6

export LD_LIBRARY_PATH=${CUDA_HOME}/lib64

export PATH=${CUDA_HOME}/bin:${PATH}

source ~/.bashrc #路径生效

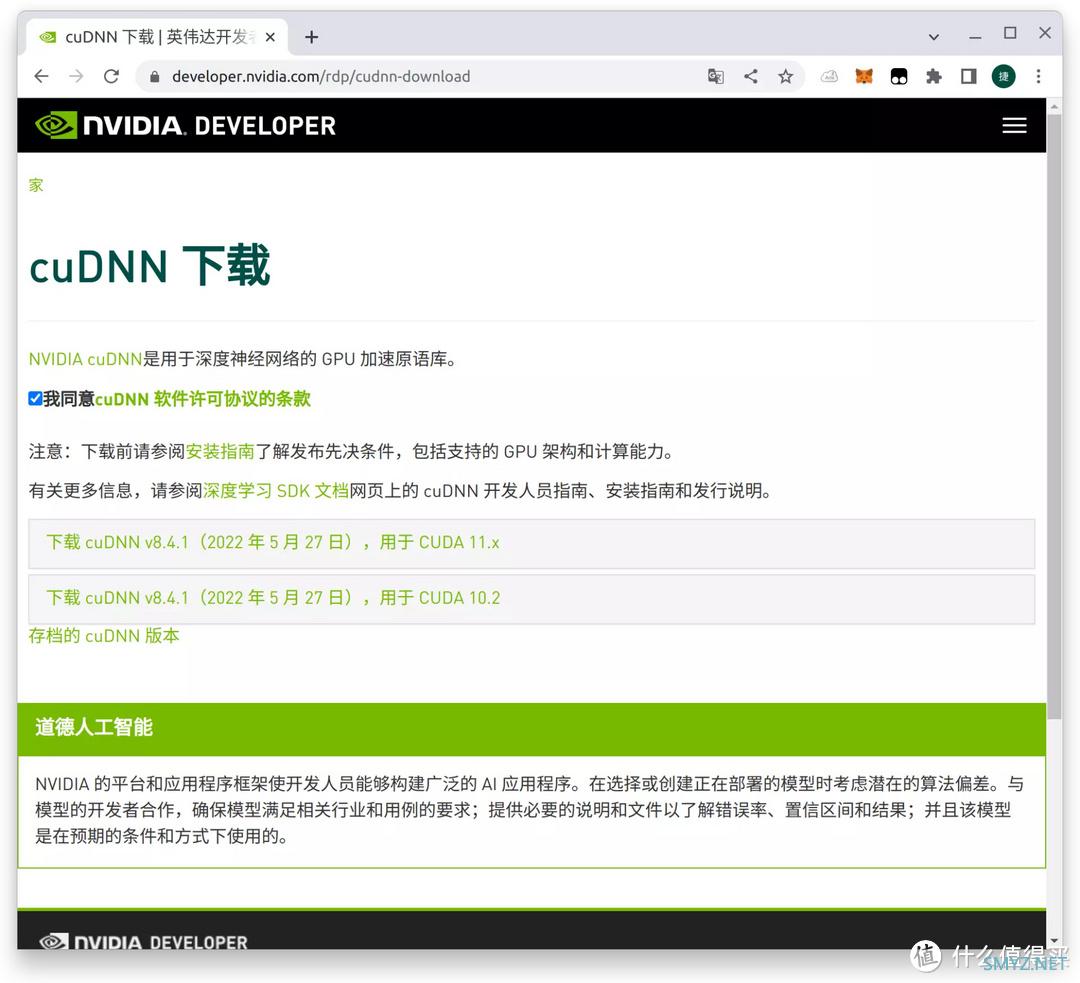

三、cuDNN安装

登录网页需要注册才可以下载

▲由于没有对应的CUDA11.6对应的cuDNN版本,暂时使用cuDNN v8.4.1对应CUDA11.x版本的。

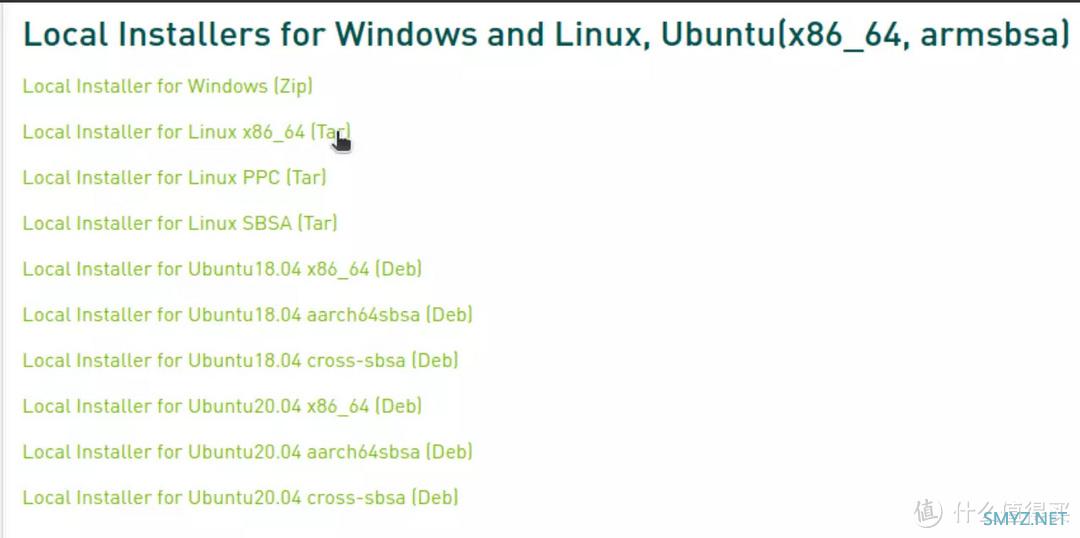

▲下载并解压,

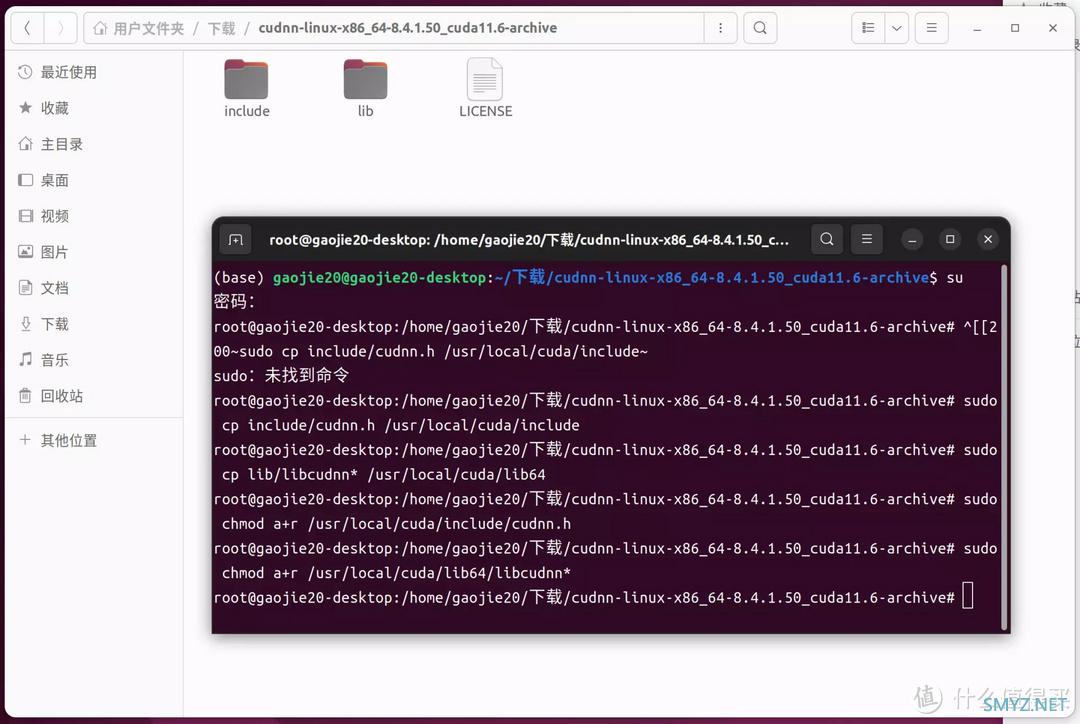

▲进入解压后的文件夹打开终端

sudo cp include/cudnn.h /usr/local/cuda/include

sudo cp lib/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h

sudo chmod a+r /usr/local/cuda/lib64/libcudnn*

cuDNN安装完成,通过如下命令查看cudnn下版本信息

cat /usr/local/cuda/include/cudnn.h | grep CUDNN_MAJOR -A 2

四、Anaconda安装

wget https://repo.anaconda.com/archive/Anaconda3-2021.11-Linux-x86_64.sh

bash Anaconda3-2021.11-Linux-x86_64.sh

执行以下命令

sudo gedit ~/.bashrc

▲打开.bashrc文件后在最后一行加入

export PATH="/home/gaojie20/anaconda3/bin:$PATH"

保存关闭bashrc文件,在命令行输入

source ~/.bashrc

随后检测

conda --version

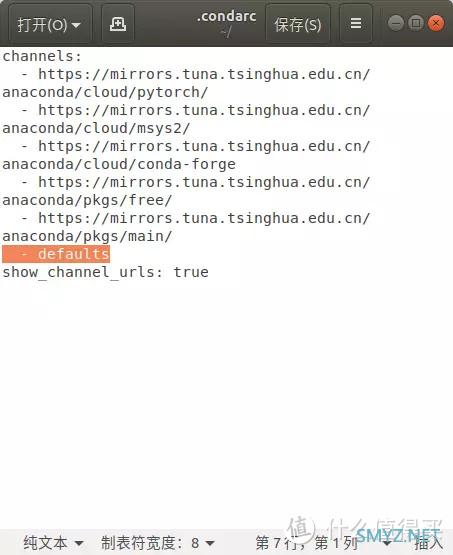

安装好之后,配置conda以及pip清华源,参考以下文字即可:

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/msys2/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/

conda config --set show_channel_urls yes

然后

sudo gedit ~/.condarc

打开.condarc文件

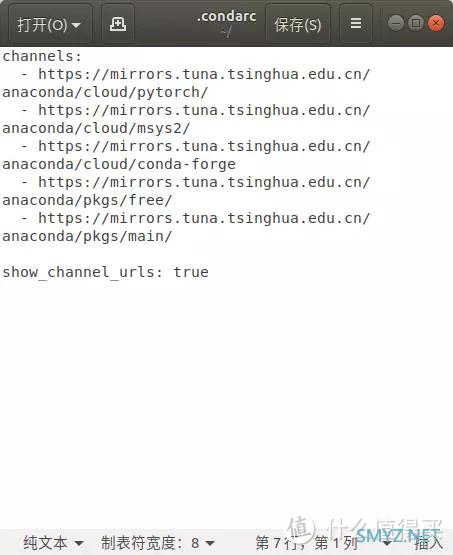

▲然后将倒数第二行的- defaults 删除即可

▲至此配置基本完成。配置这些是为了更好的执行Phoronix test suite测试套件重的GPU权重测试。

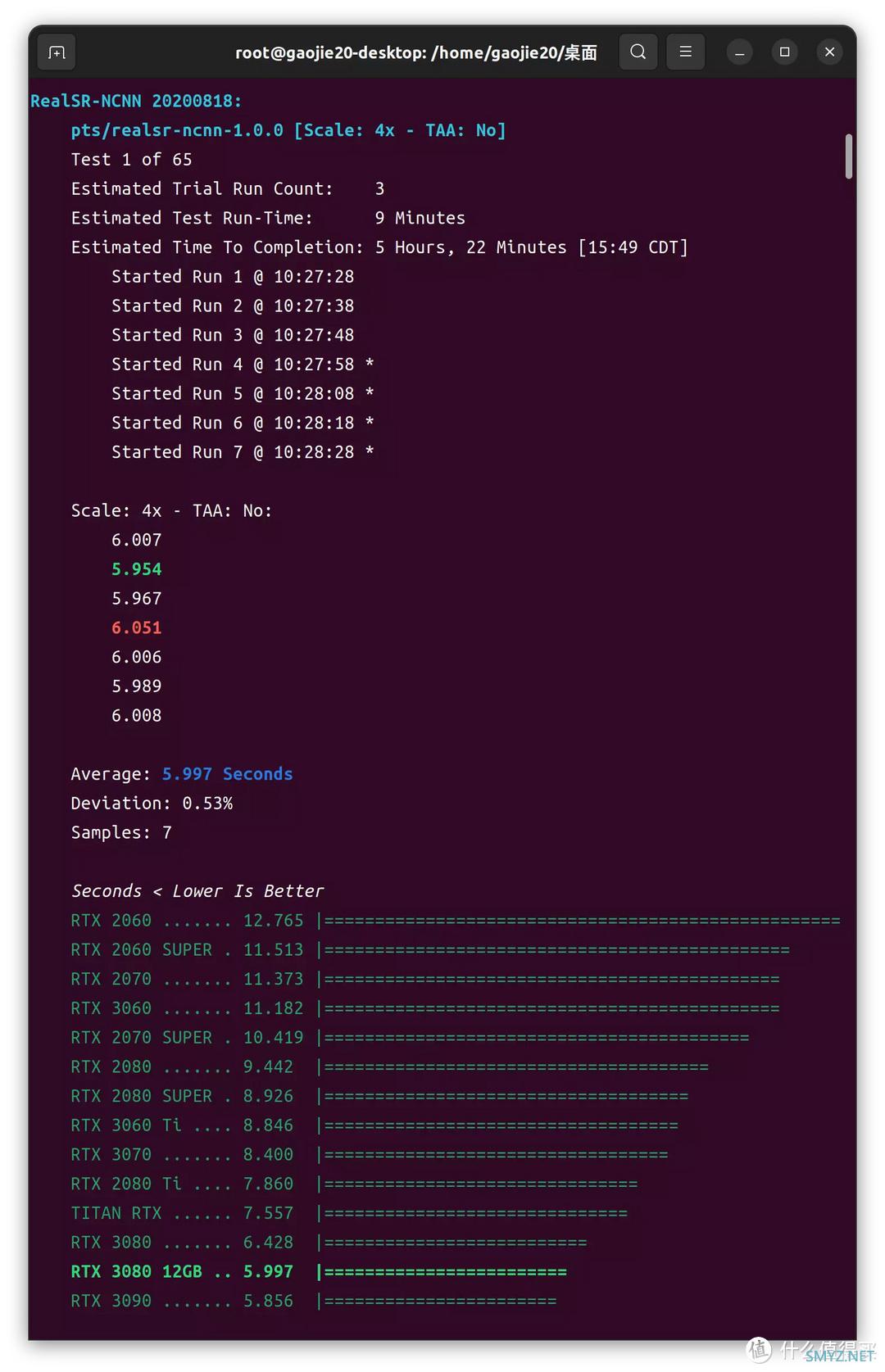

Phoronix test suite测试套件是目前LINUX下可用的最全面的测试和基准测试平台,它提供了可扩展的框架,可以轻松地添加新的测试。该软件旨在以干净,可复制且易于使用的方式有效地执行定性和定量基准。Phoronix test suite测试套件可用于比较计算机的性能,硬件验证以及持续集成/性能管理。所以以下测试集成在Phoronix test suite框架下进行。

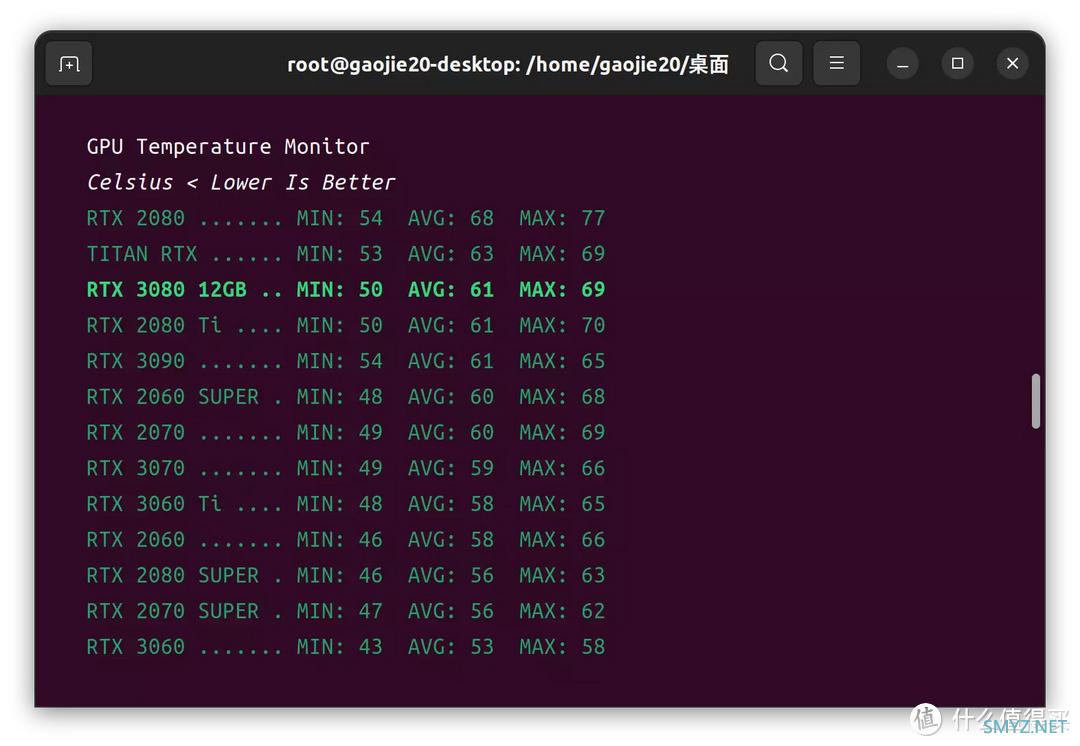

用于对比的GPU为:

GPU1:NVIDIA Geforce RTX 2060 SUPER FE

GPU2:ASUS ROG STRIX Geforce RTX 2070 OC

GPU3:NVIDIA Geforce RTX 2070 SUPER FE

GPU4:ZOTAC Geforce RTX 2080 PGF OC

GPU5:NVIDIA Geforce RTX 2080 SUPER FE

GPU6:NVIDIA Geforce RTX 2080 Ti FE

GPU7:NVIDIA Geforce RTX TITAN

GPU8:ZOTAC Geforce RTX 3060 Apocalypse OC

GPU9:PALIT Geforce RTX 3060 Ti

GPU10:MSI Geforce RTX 3070 Ventus 2X

GPU11:NVIDIA Geforce RTX 3070 Ti FE

GPU12:MSI Geforce RTX 3080 Ventus 3X

GPU13:ZOTAC Geforce RTX 3080 12GB Apocalypse OC

GPU14:,MSI Geforce RTX 3080 Ti Ventus 3X

GPU15:ZOTAC Geforce RTX 3090 Apocalypse OC

其中因为部分显卡的的监控芯片方案无法被Ubuntu正常识别的问题,无法获取到具体的温度以及功耗数据。

渲染测试

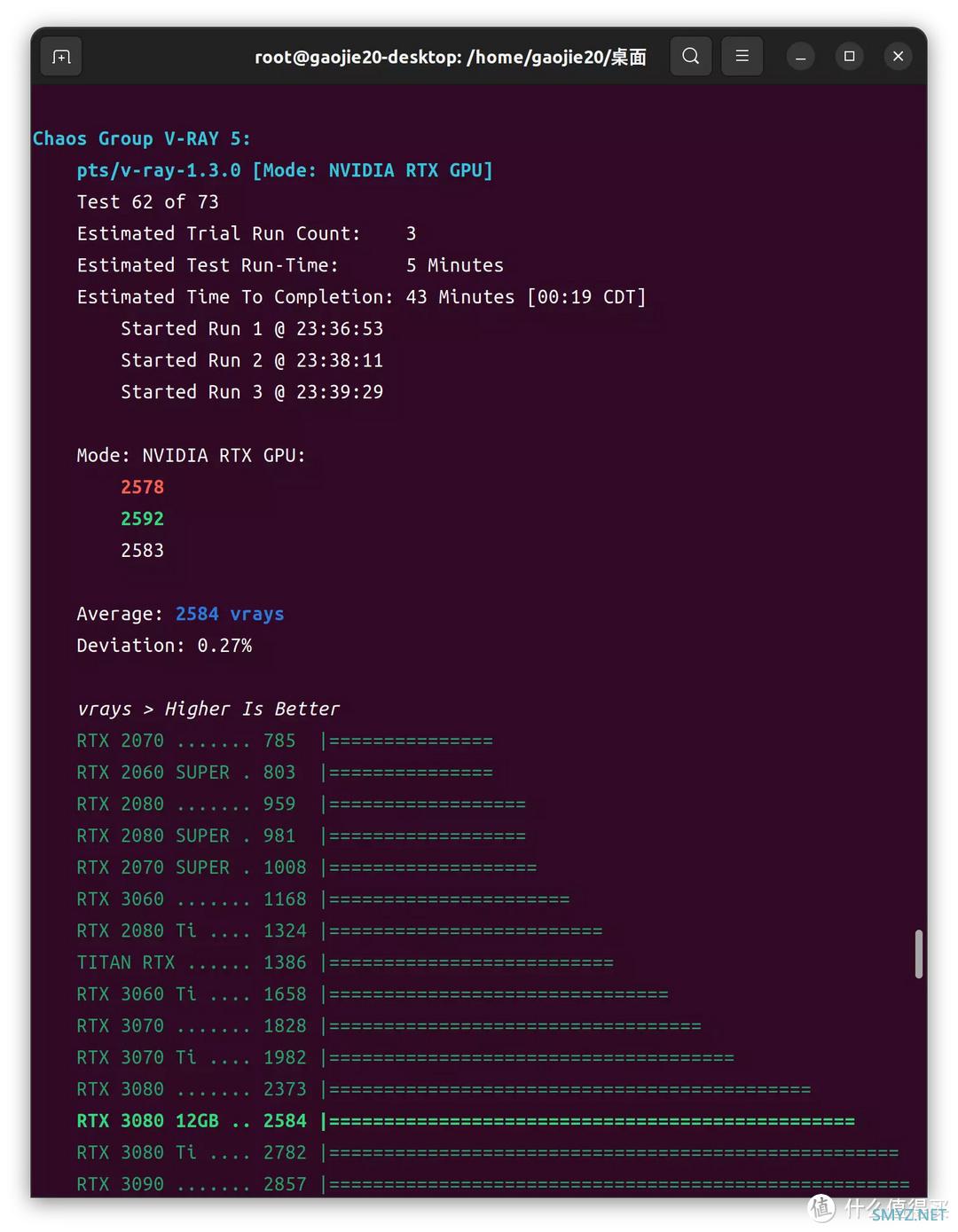

Chaos Group V-RAY 5

这是对Chaos Group的V-RAY基准测试。V-RAY是一种商业渲染器,可以与各种创建者软件产品(例如SketchUp和3ds Max)集成。V-RAY基准测试是独立的,并支持基于CPU和NVIDIA CUDA / RTX的渲染。这里只测试CUDA和RTX的渲染性能。测试溯源:链接

RTX渲染模式

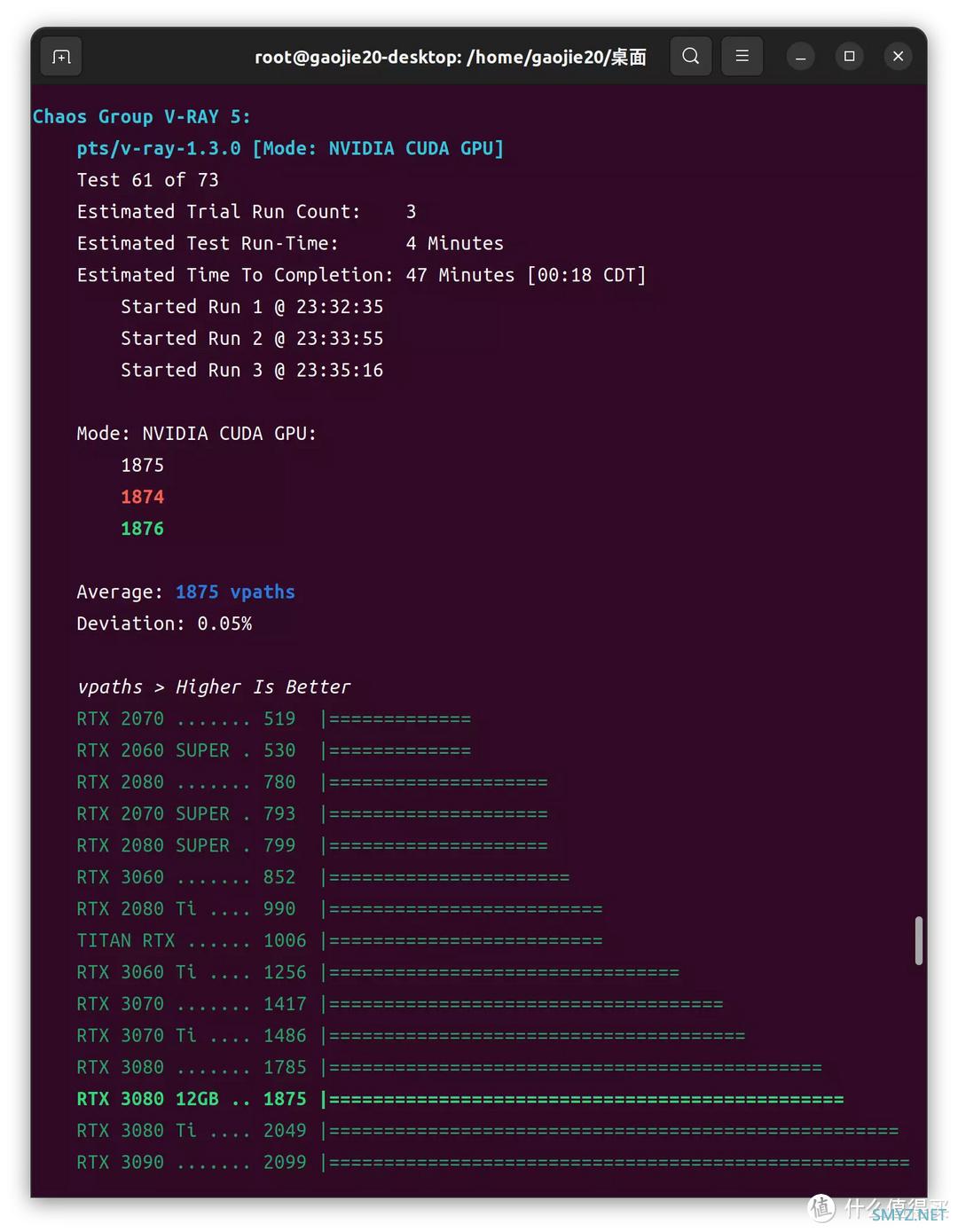

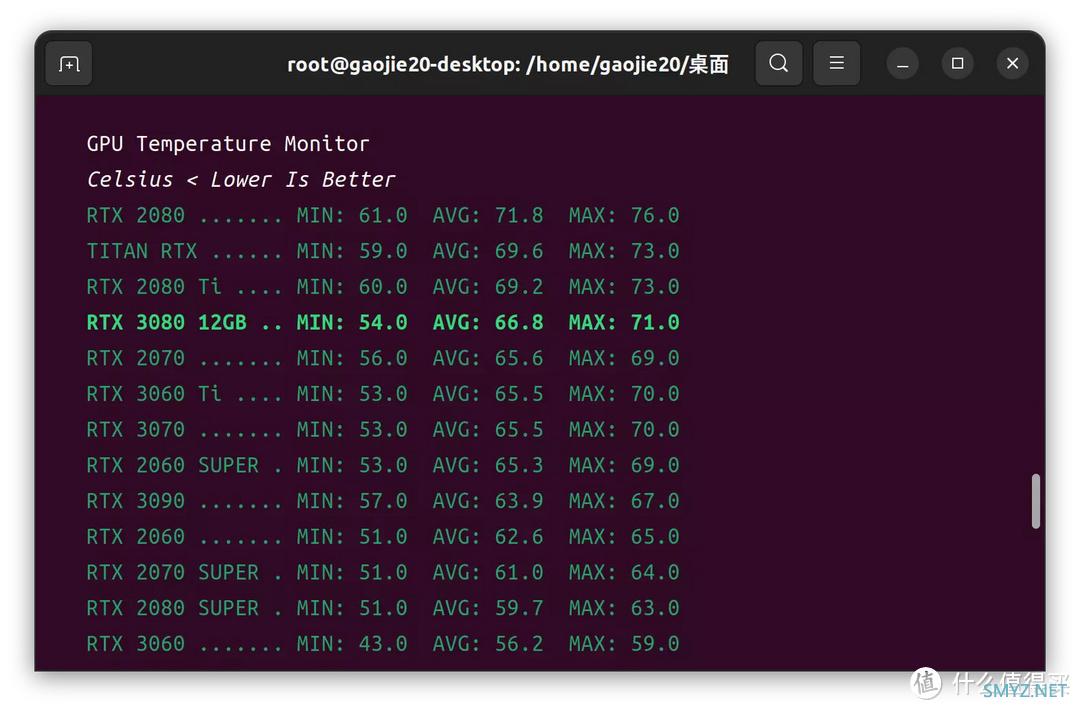

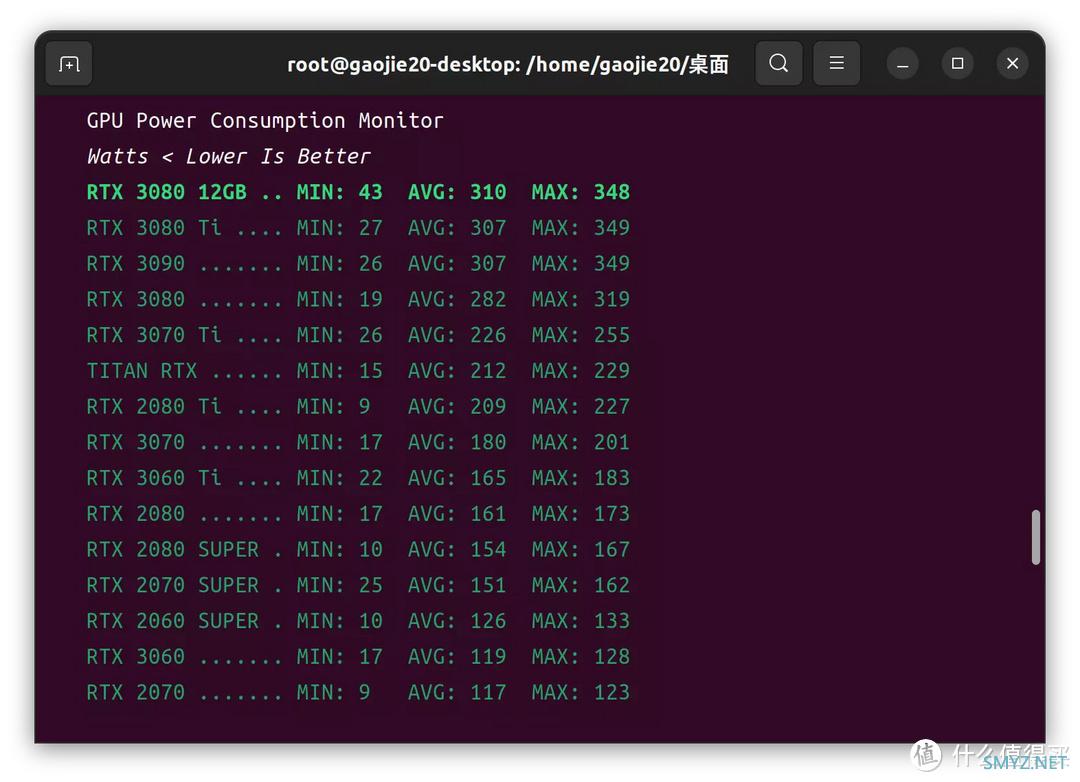

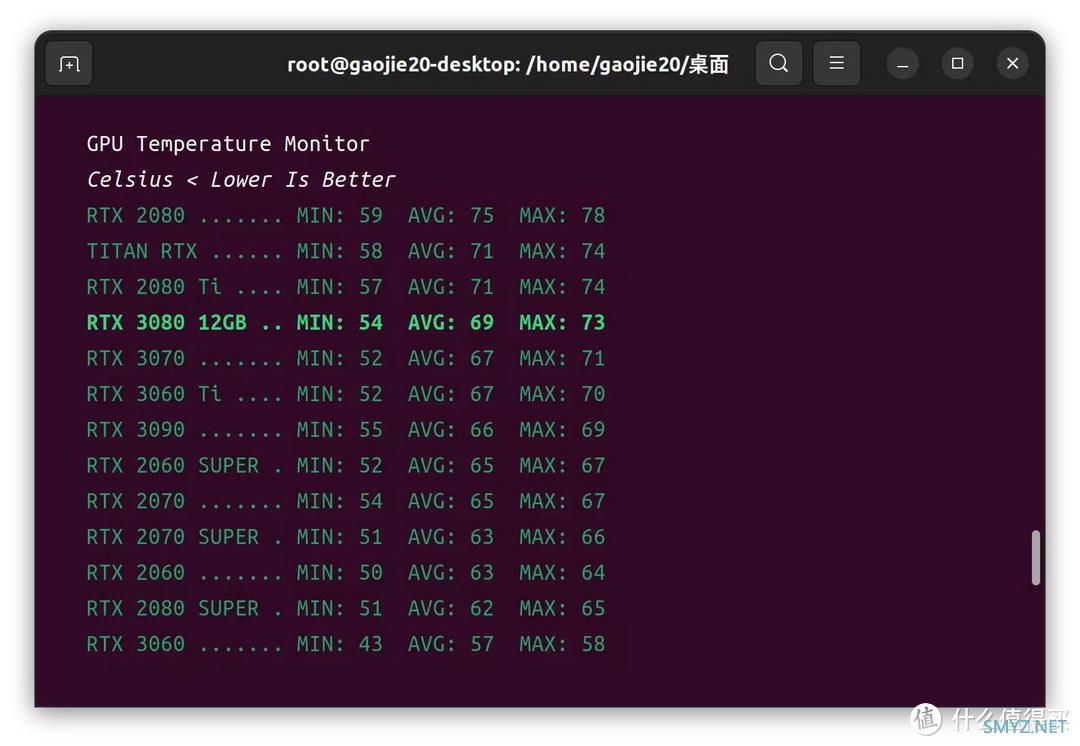

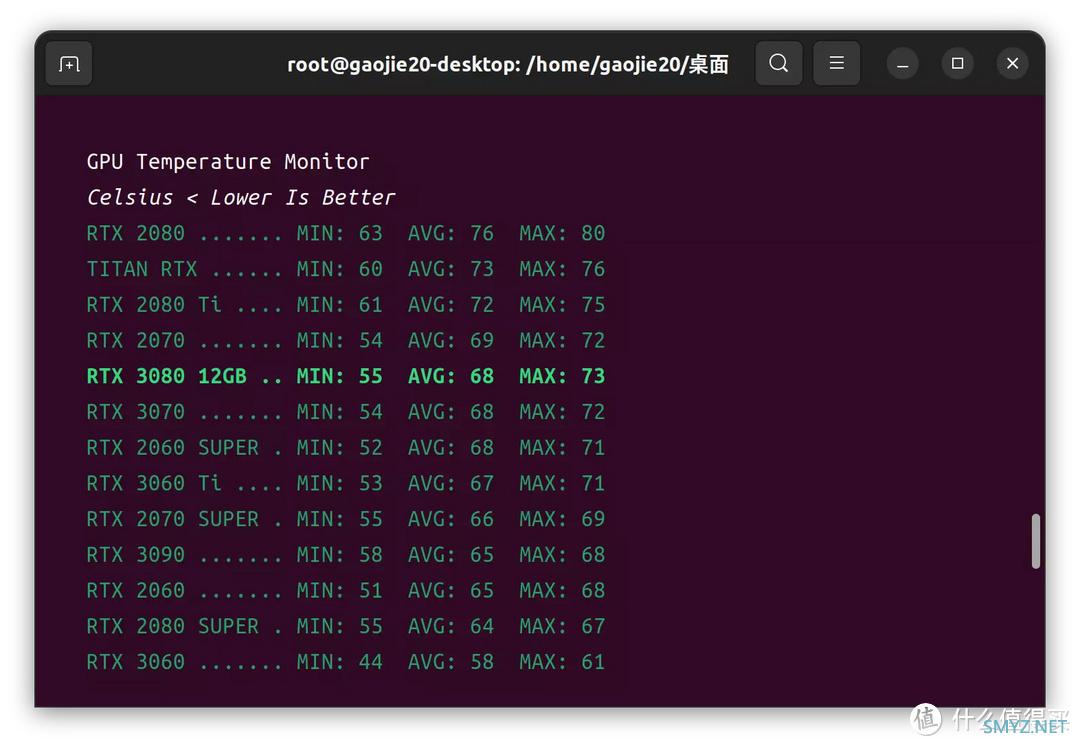

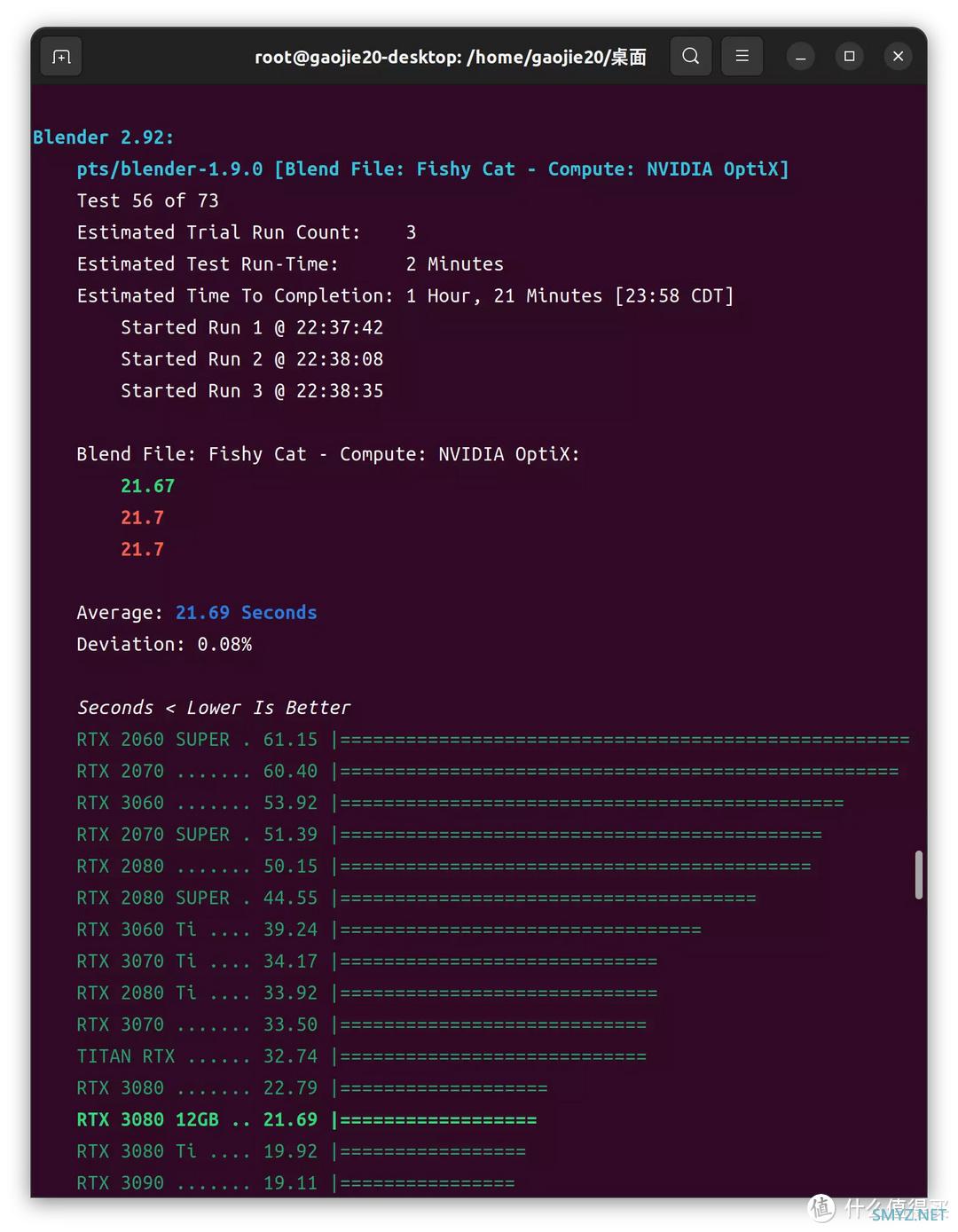

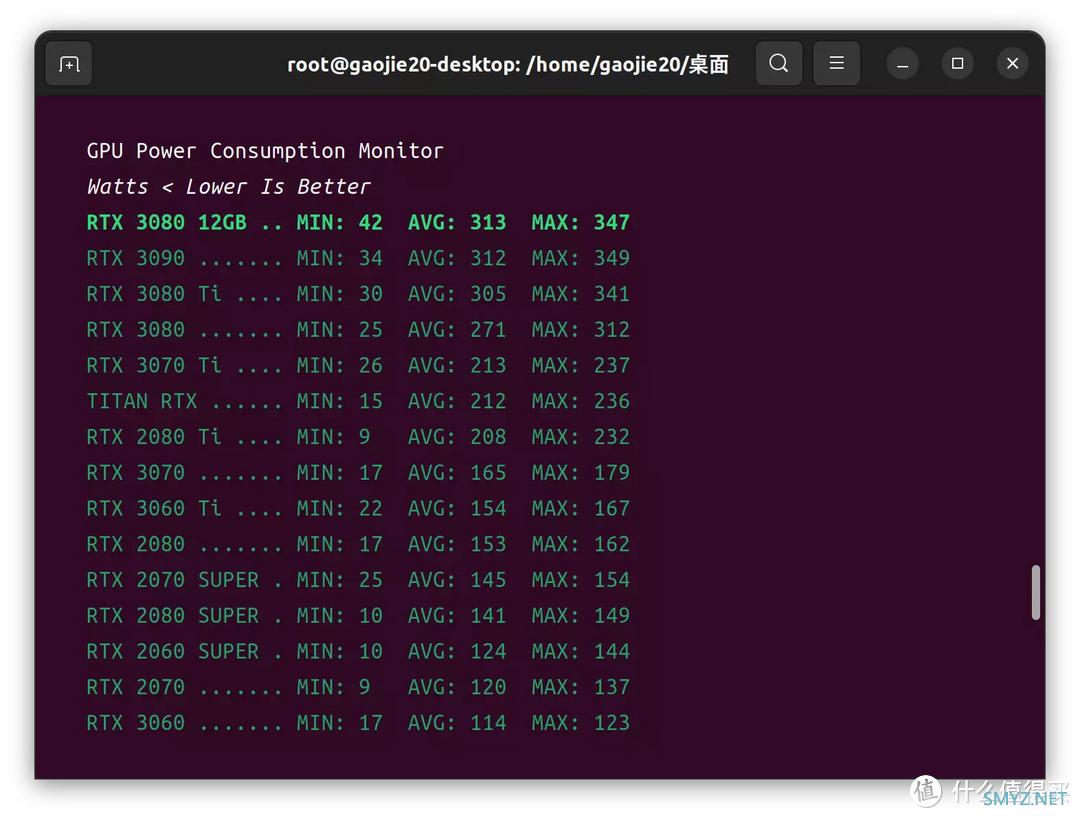

▲RTX模式下,可以看到RTX3080 12GB对比RTX3080有8%的优势,相比RTX3080TI有7.6%的劣势。

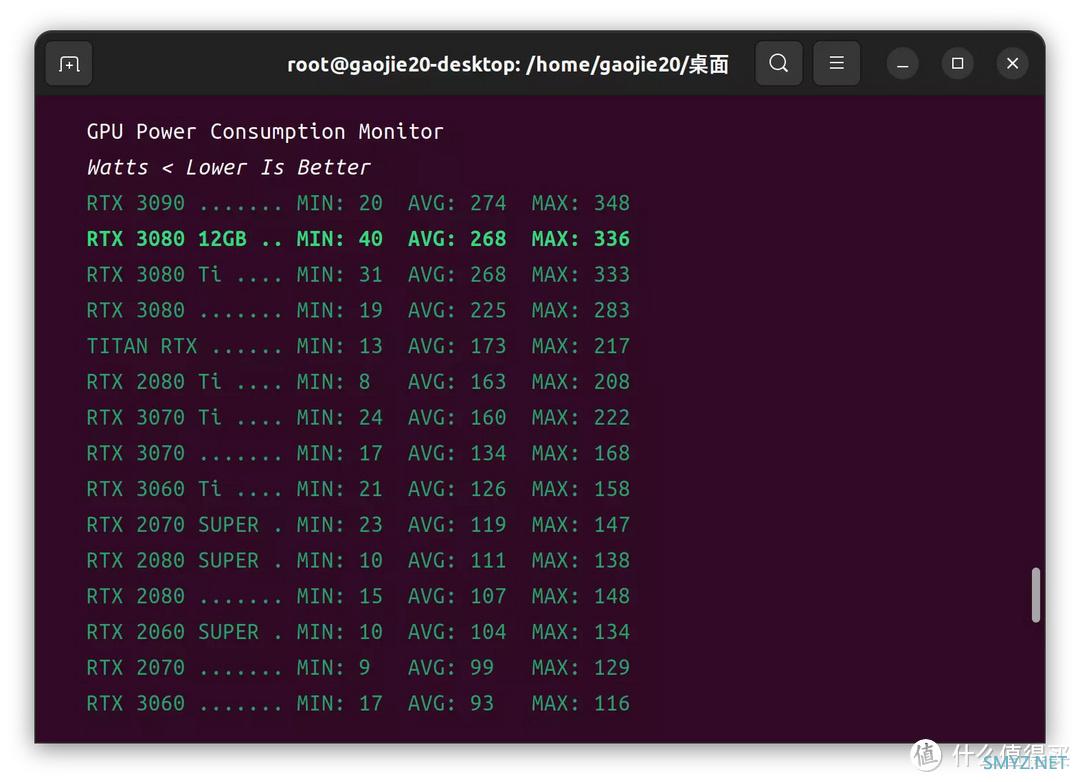

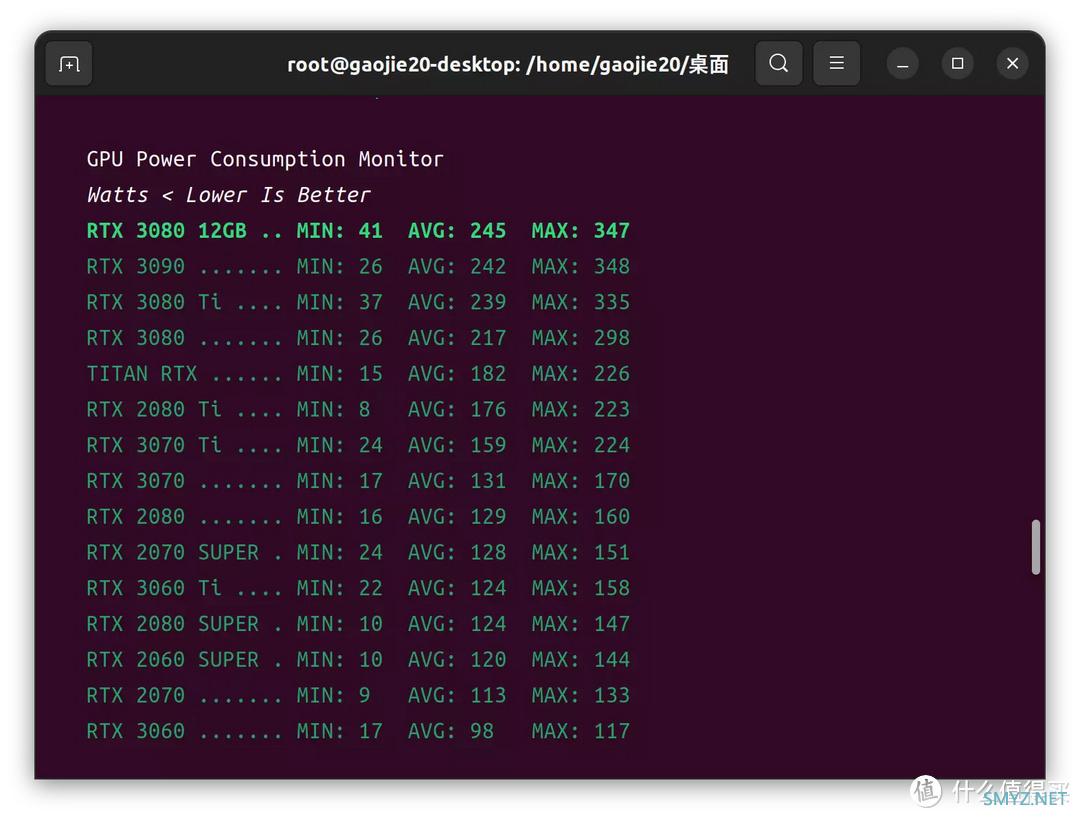

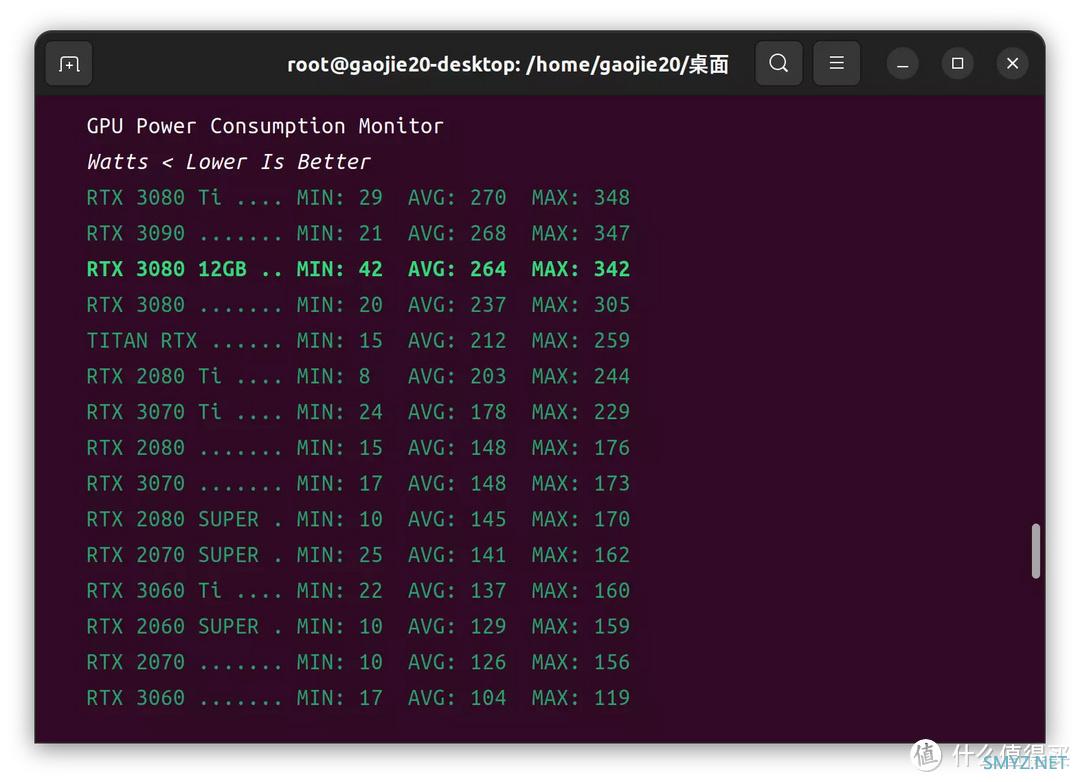

▲测试全程,RTX3080 12GB最小功耗40W,最大功耗336W,平均268W

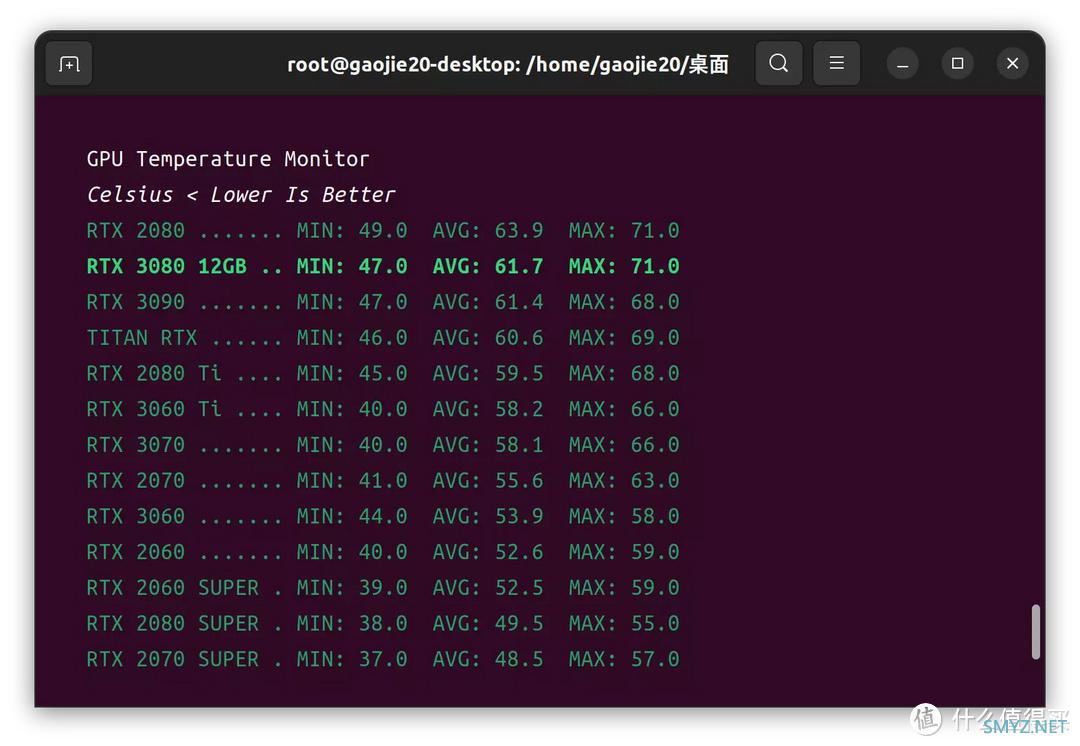

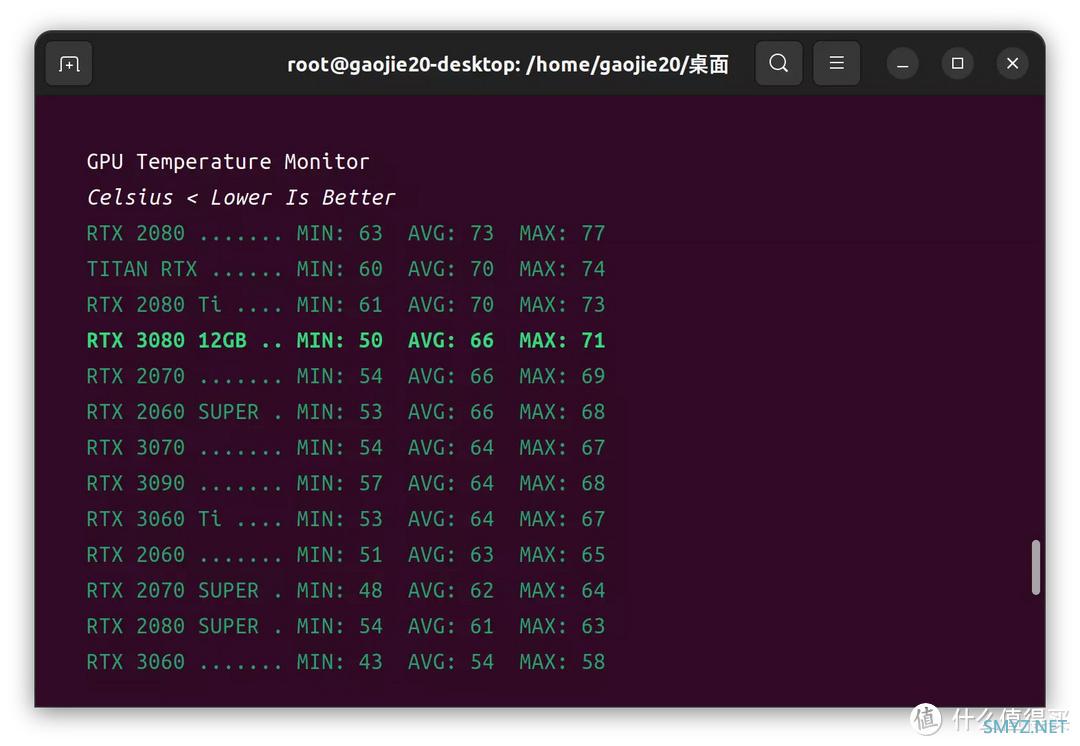

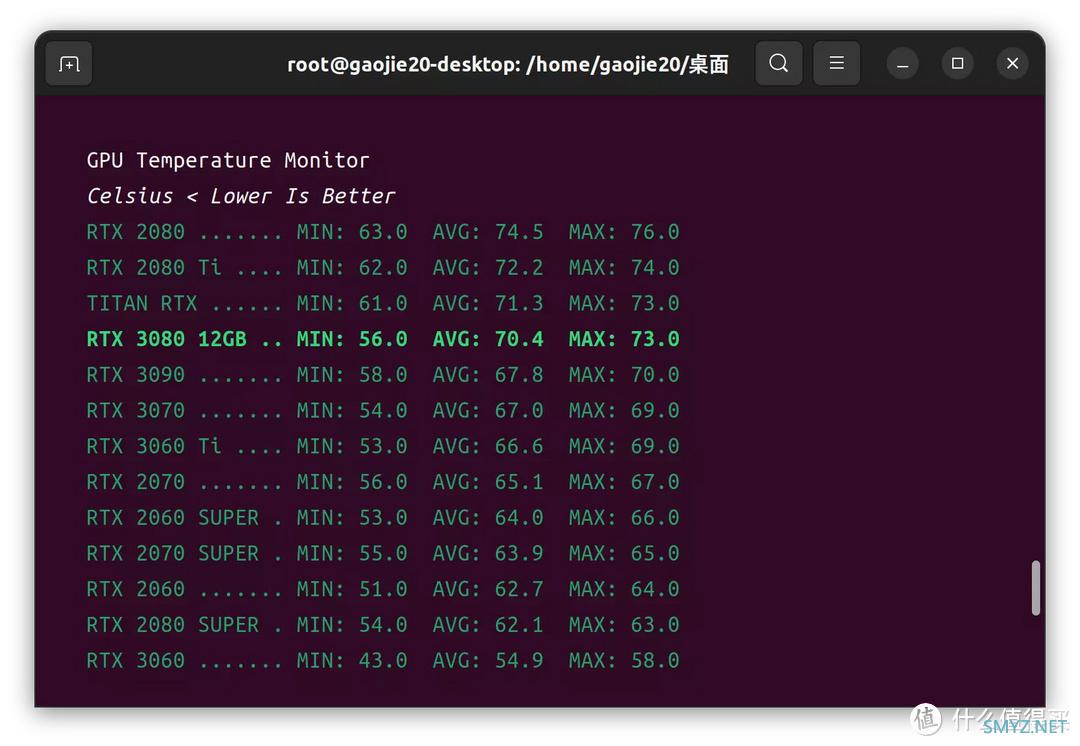

▲测试全程,RTX3080 12GB最低温度47度,最高温度71度,平均61.7度。

CUDA模式

▲CUDA模式下,可以看到,RTX3080 12GB对比RTX3080有5%的优势,相比RTX3080TI有9%的劣势。但是CUDA模式下的渲染效率明显不如RTX模式。

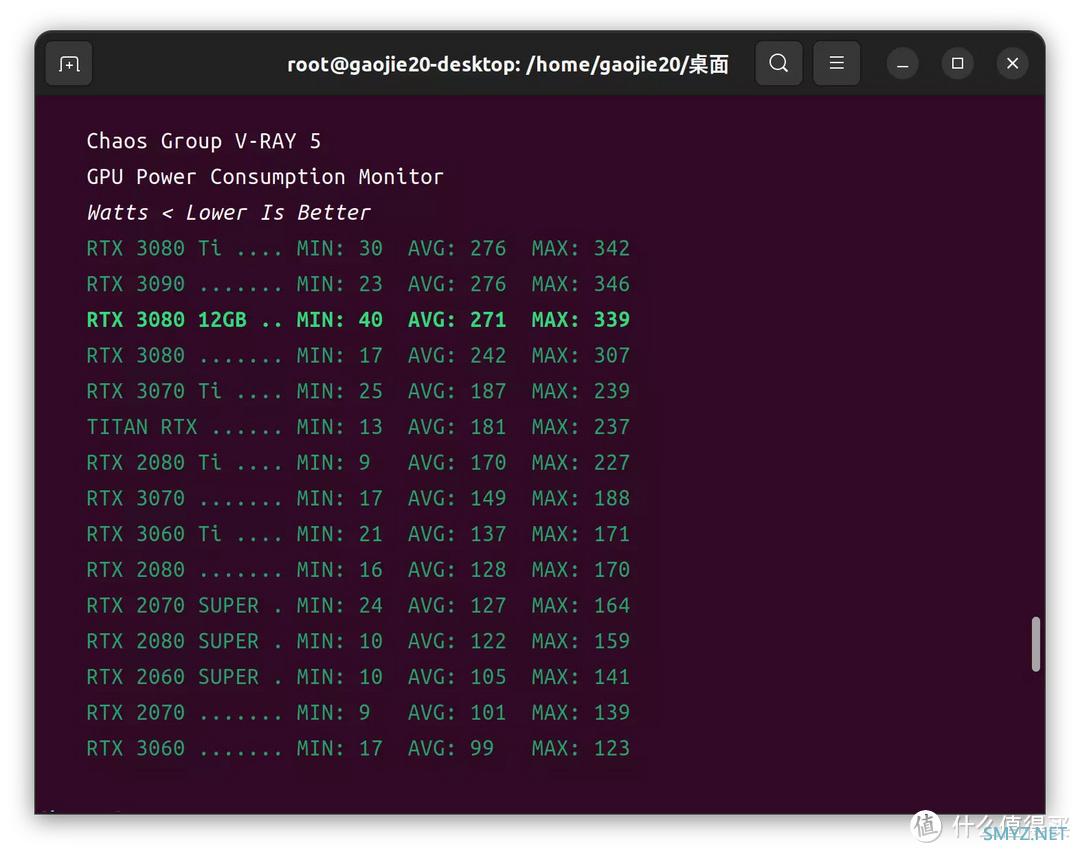

▲测试全程,RTX3080 12GB最小功耗40W,最大功耗339W,平均271W

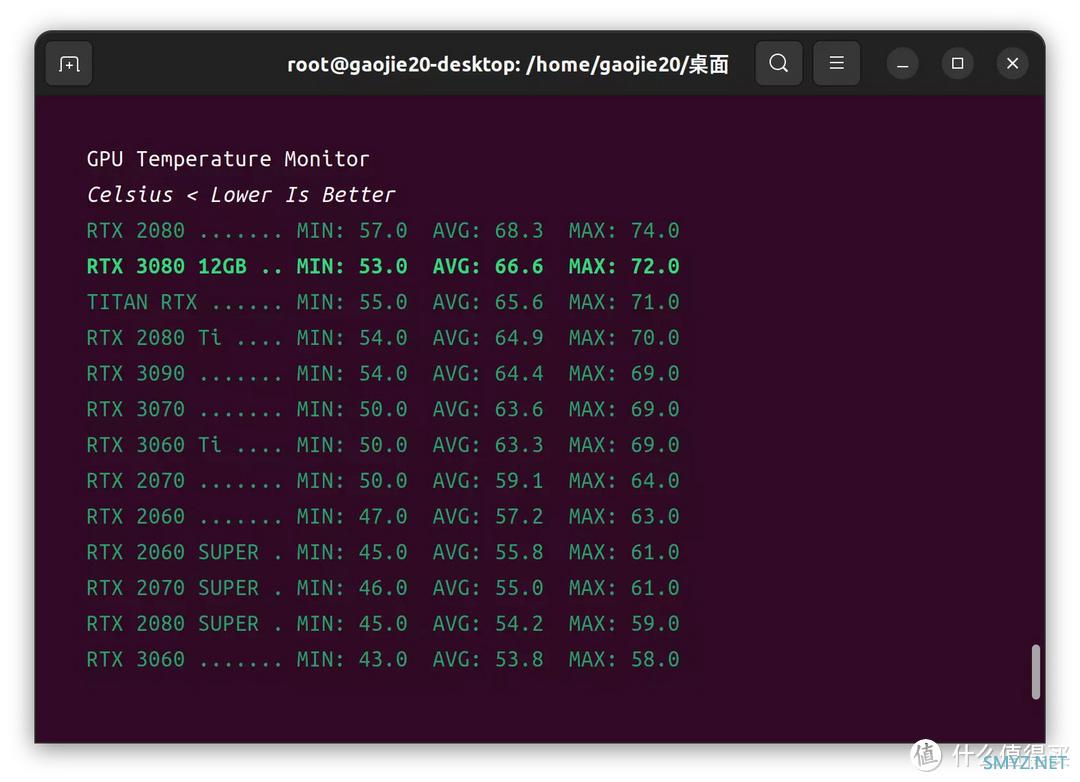

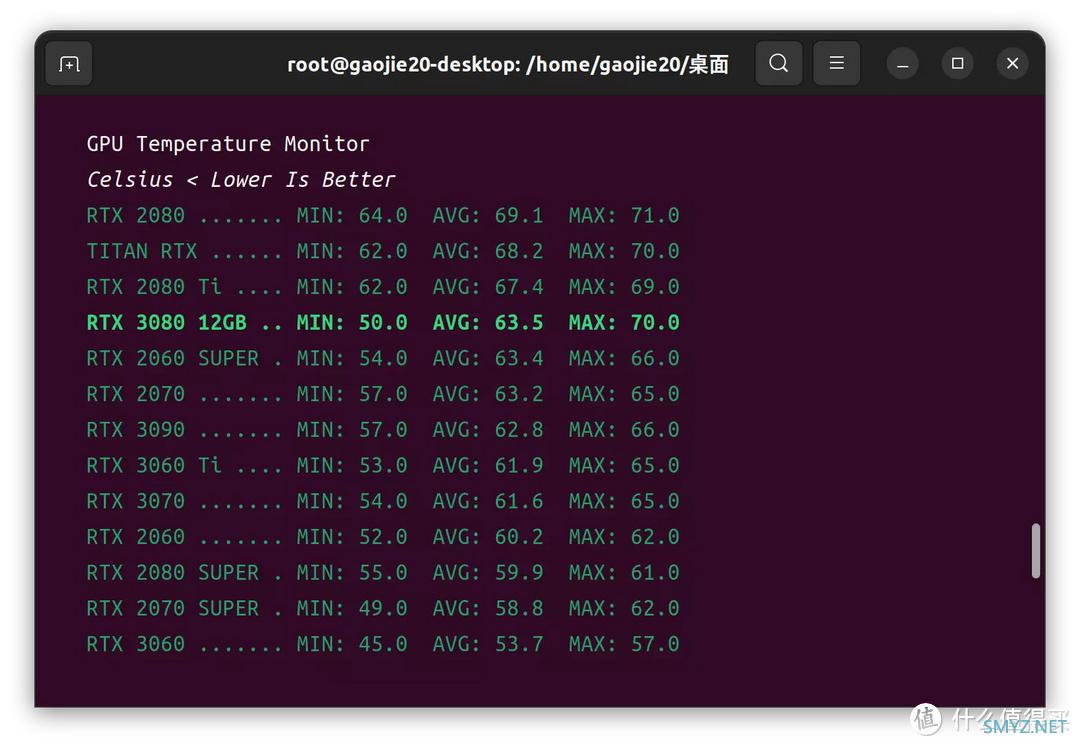

▲测试全程,RTX3080 12GB最低温度53度,最高温度72度,平均66.6度。

V-RAY5对于RTX 3080 12GB这块显卡而言,RTX模式对比CUDA模式效能要提高32%。

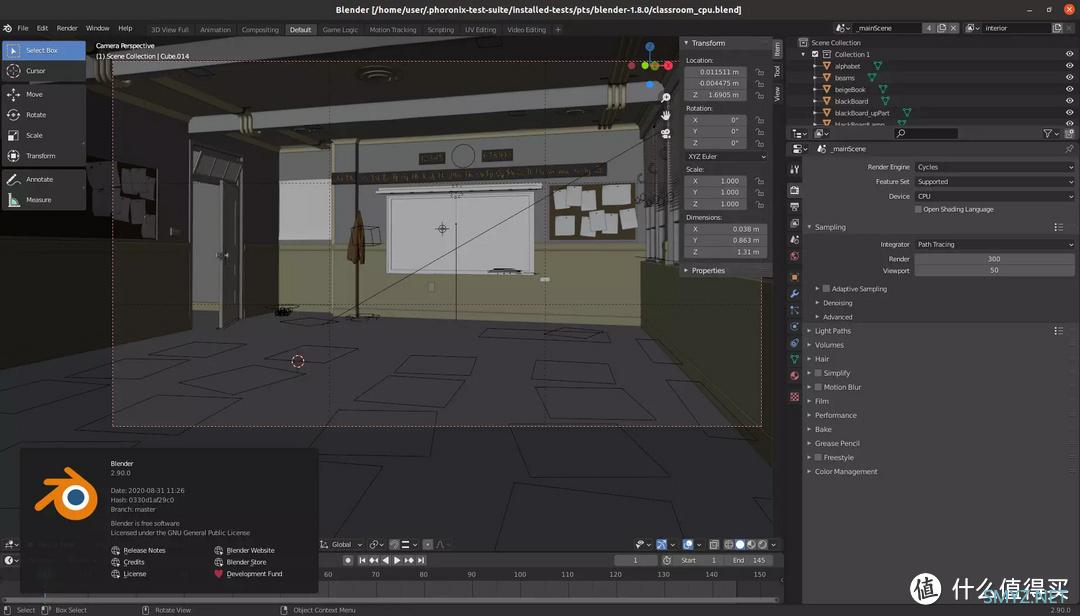

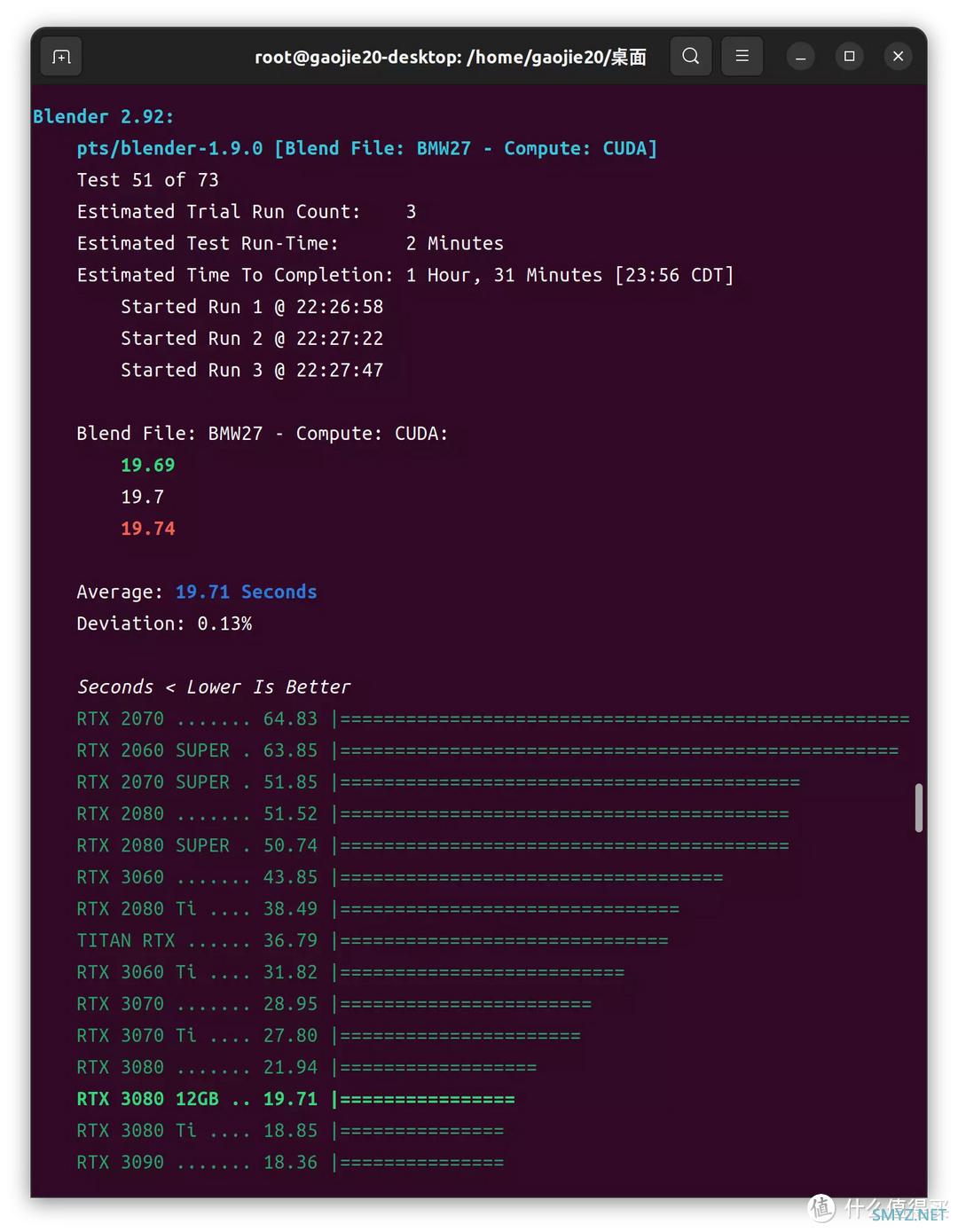

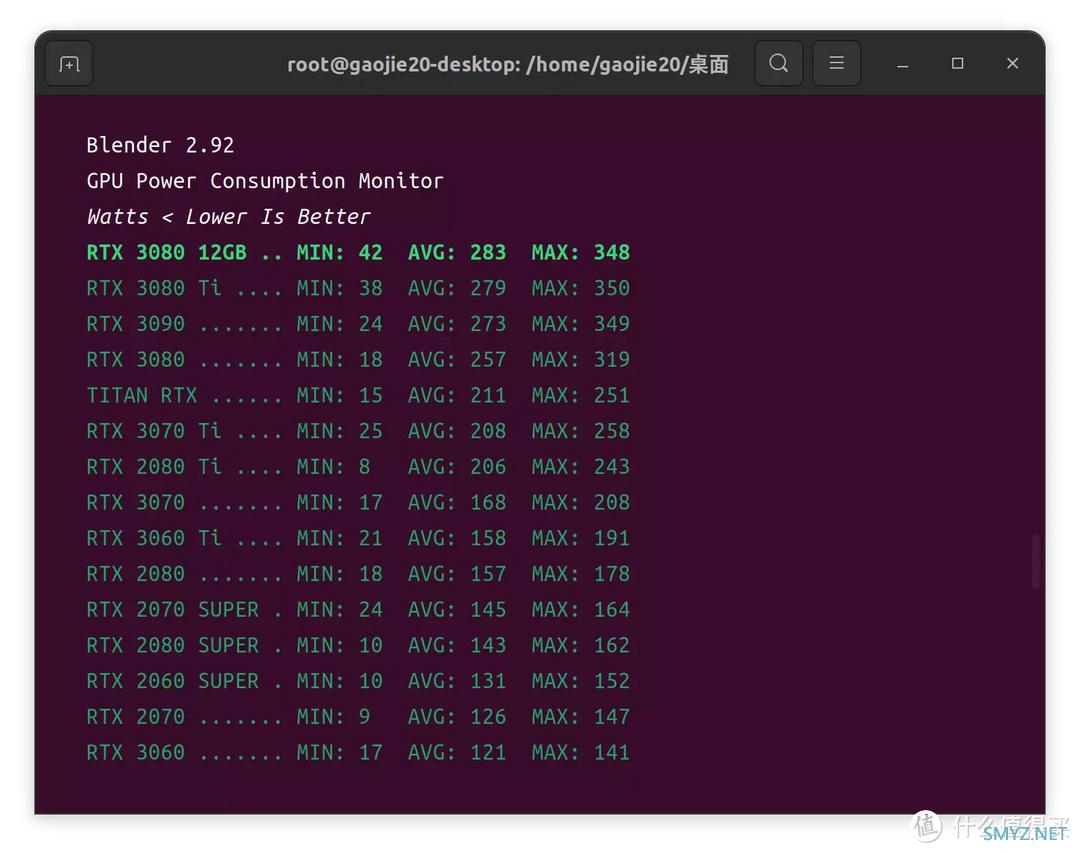

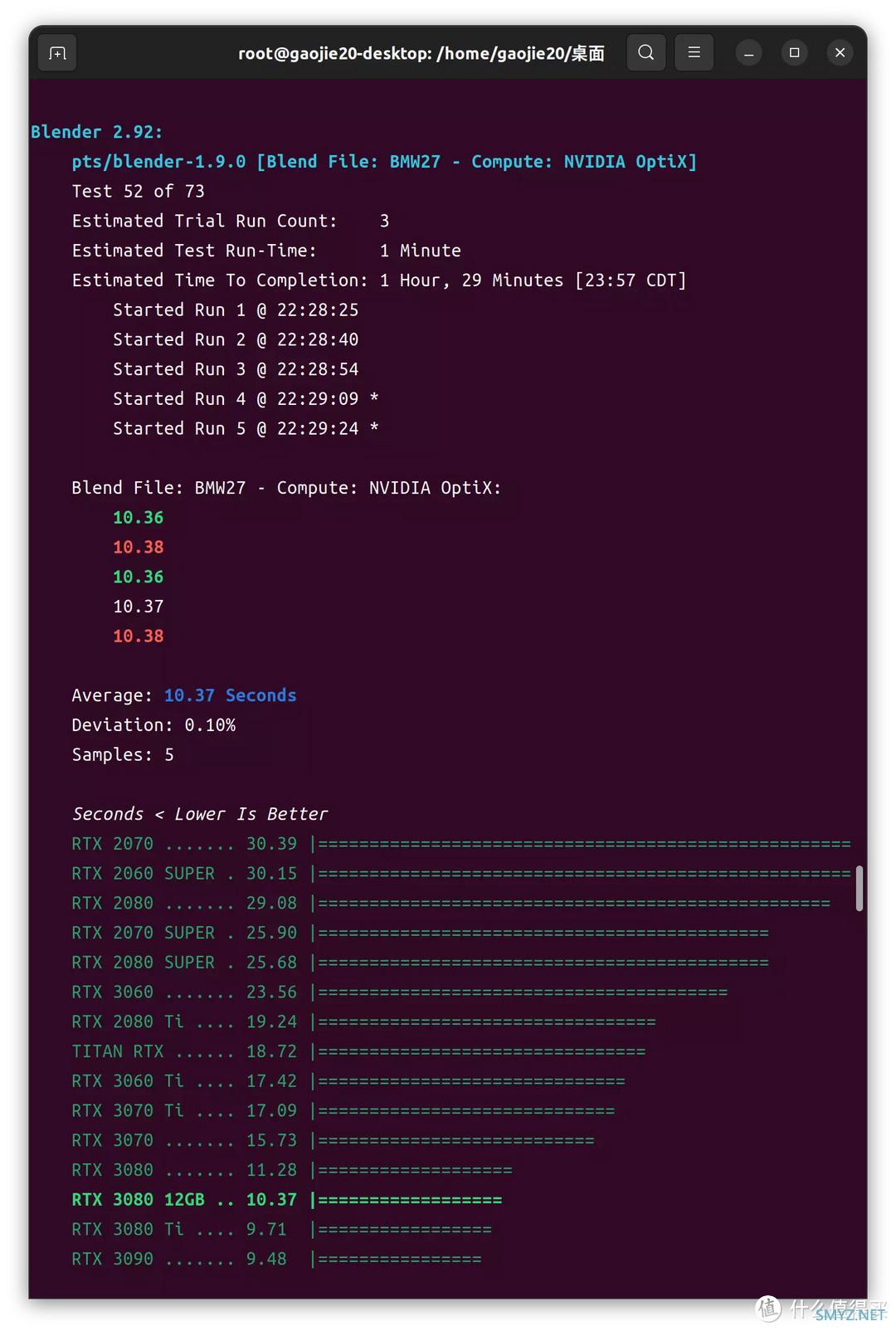

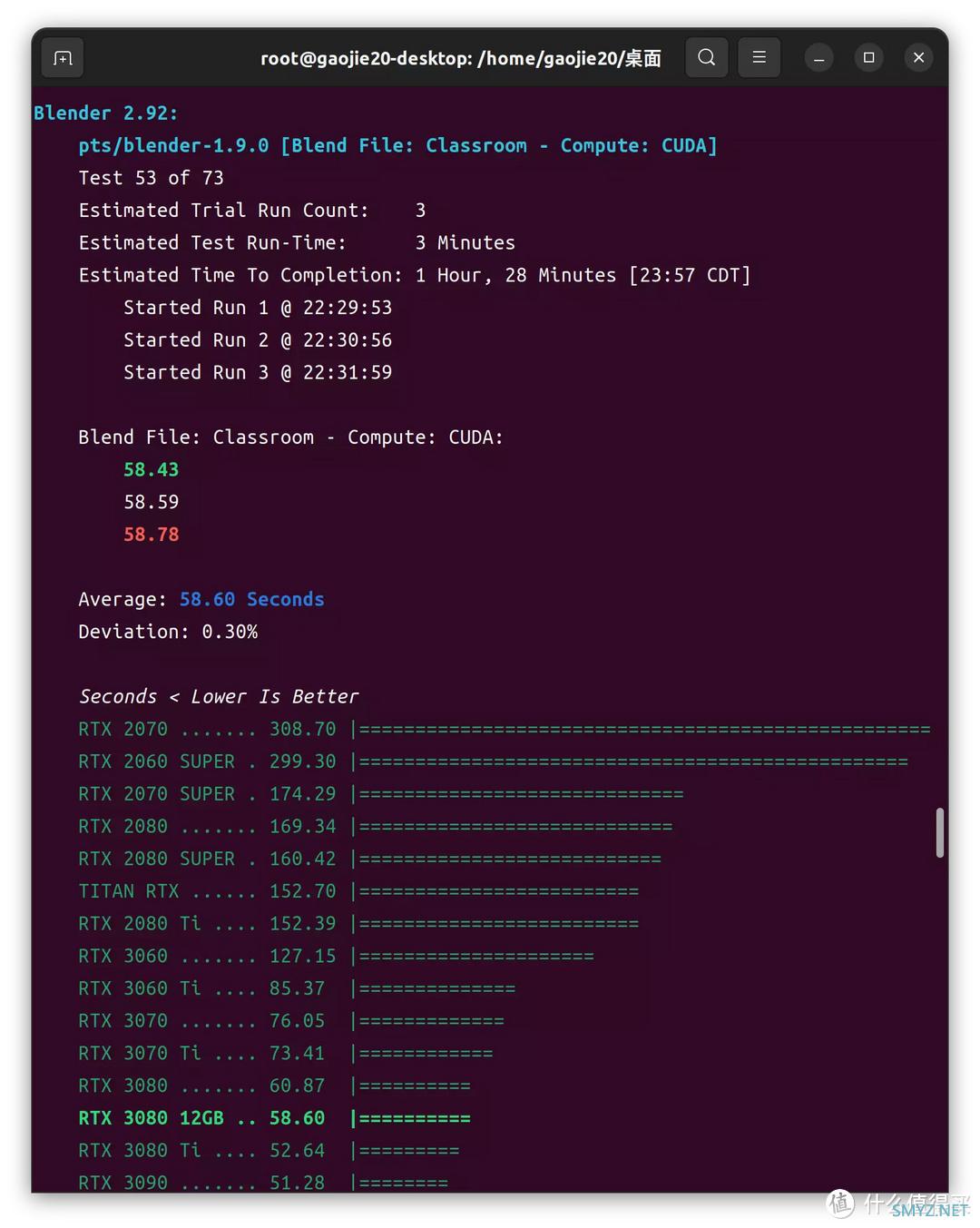

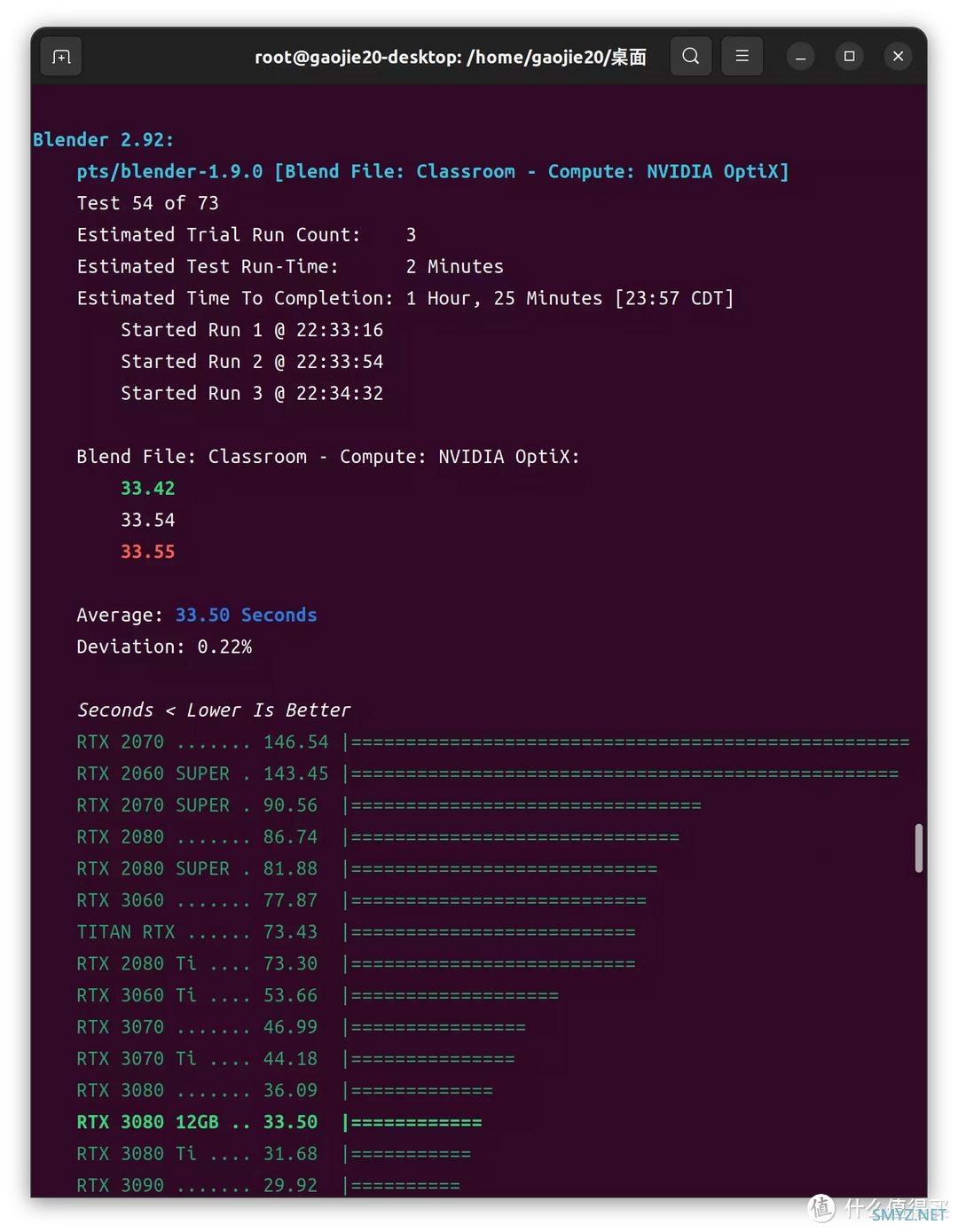

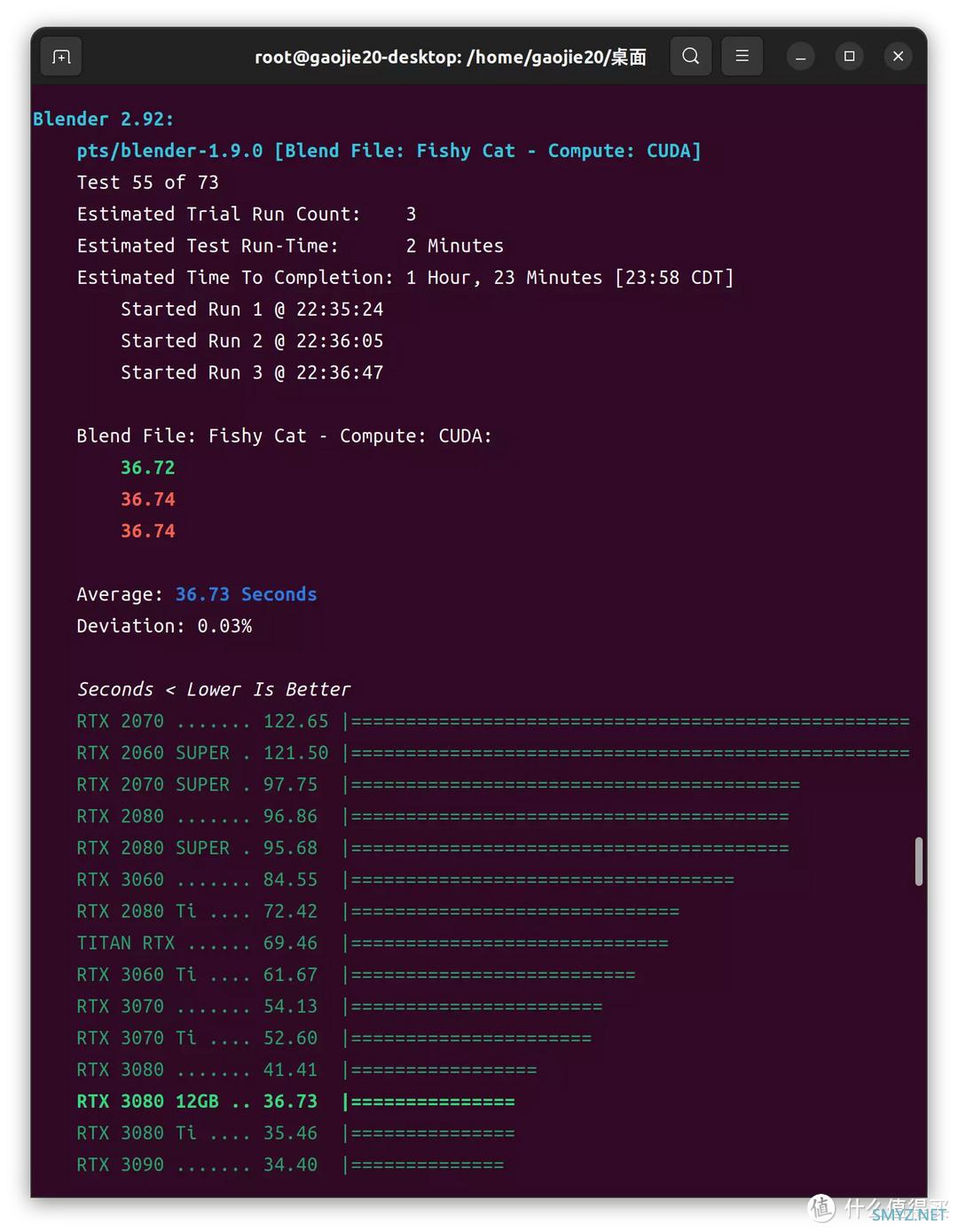

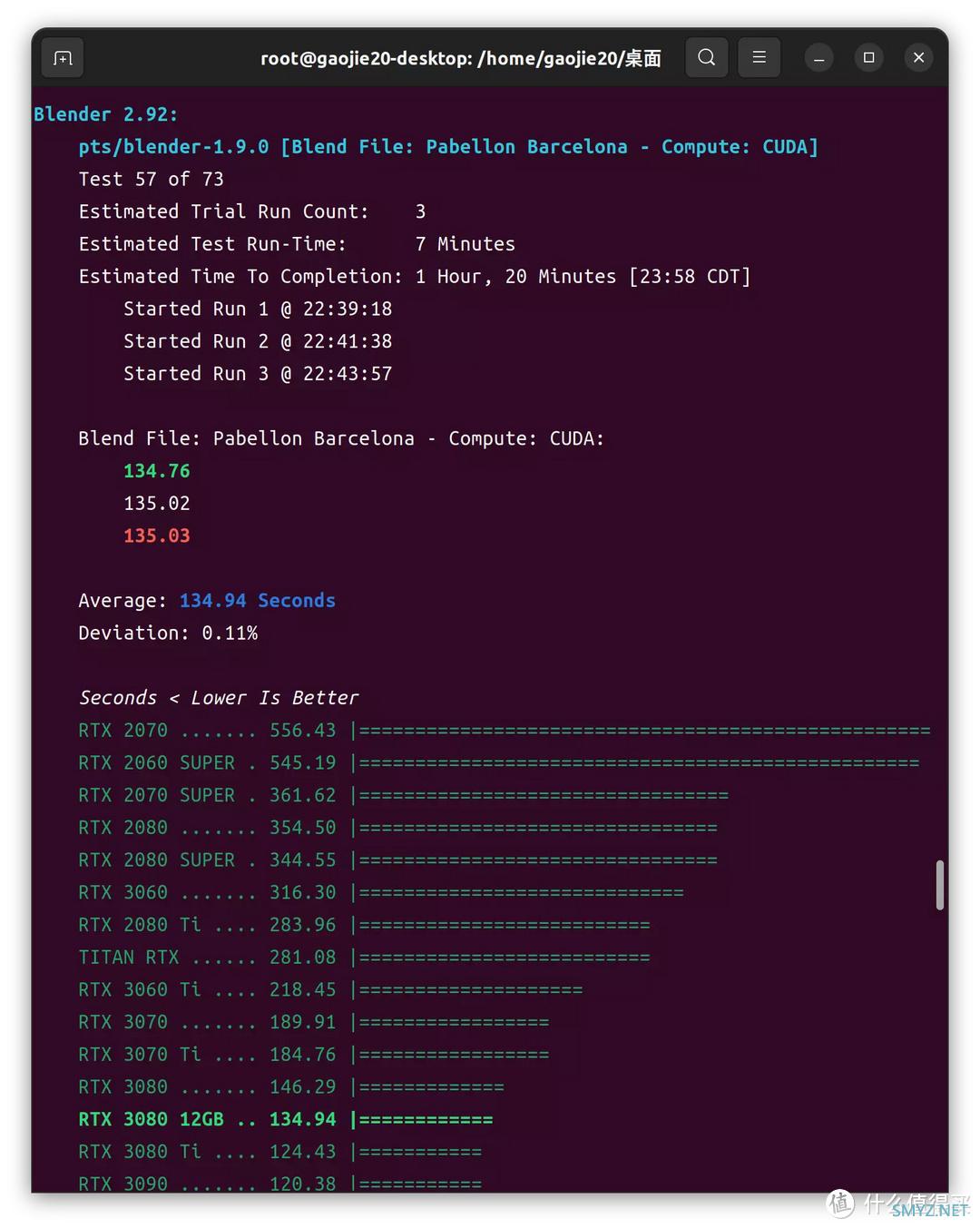

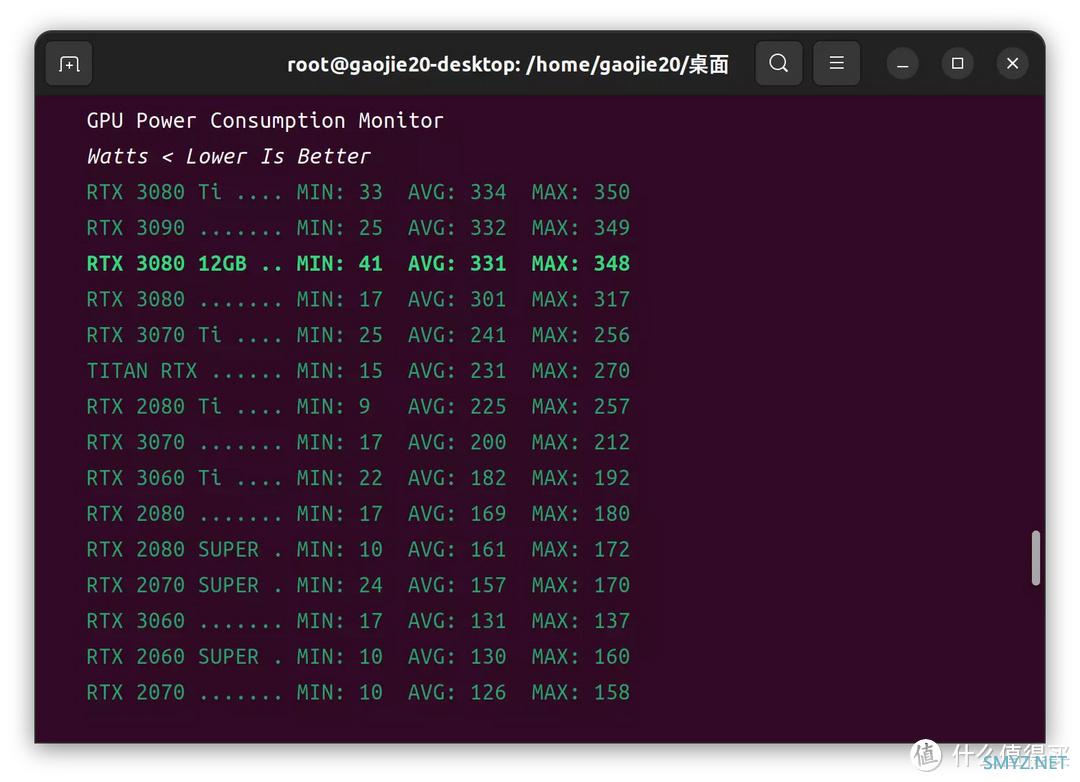

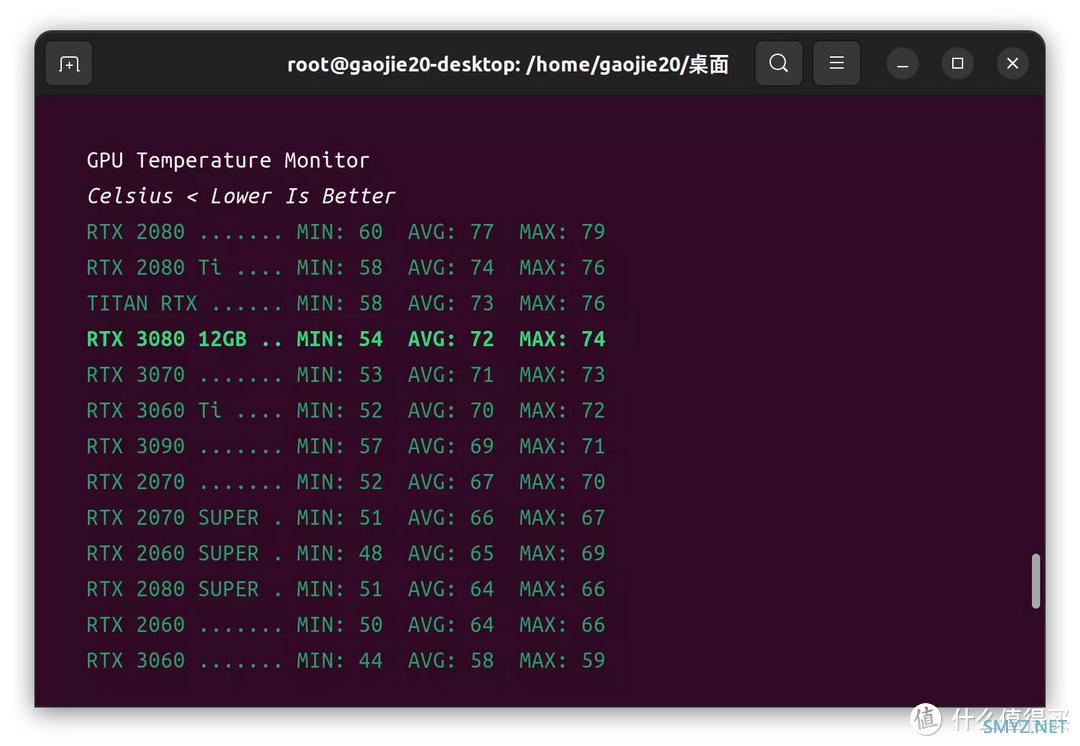

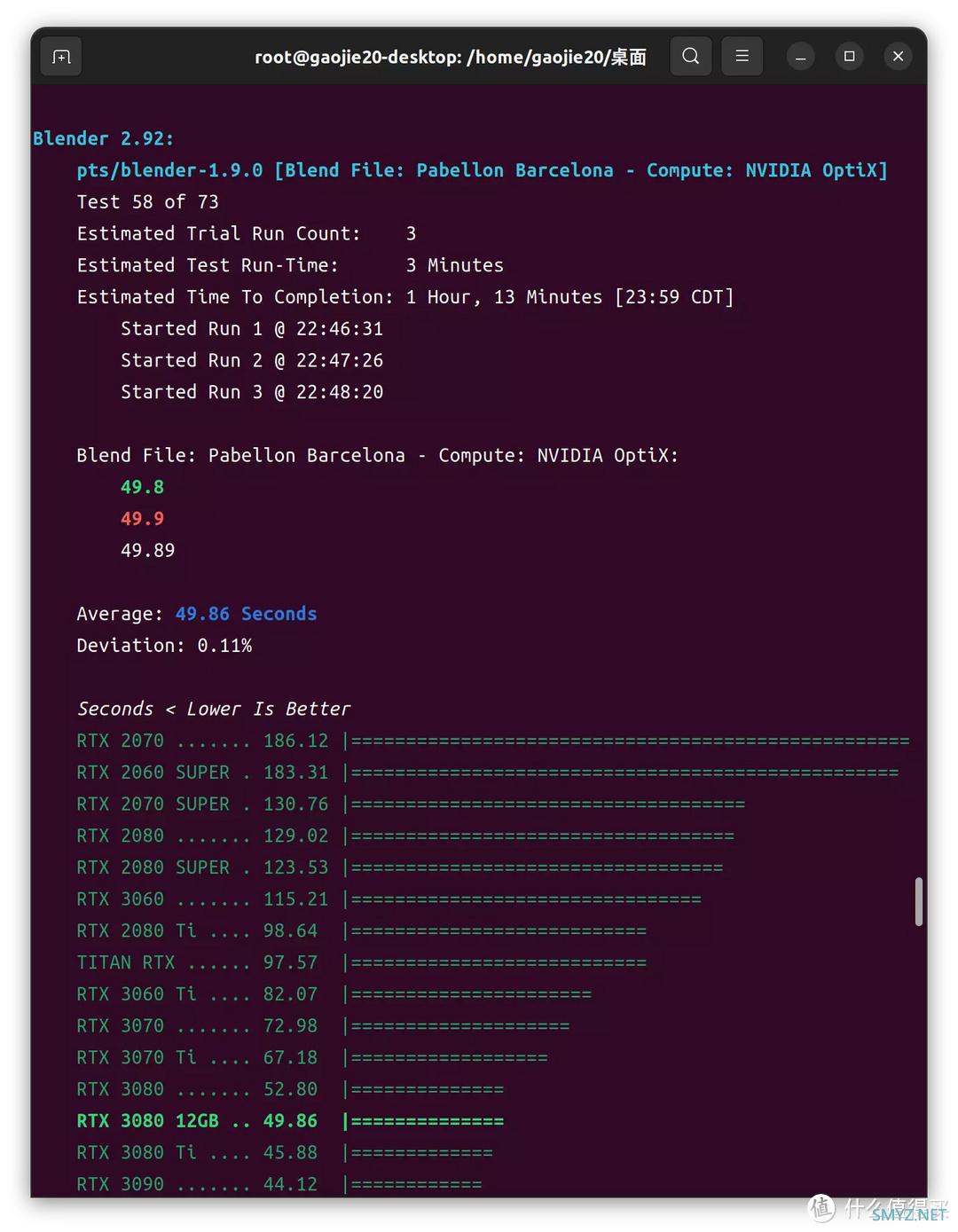

Blender 2.92

机器学习

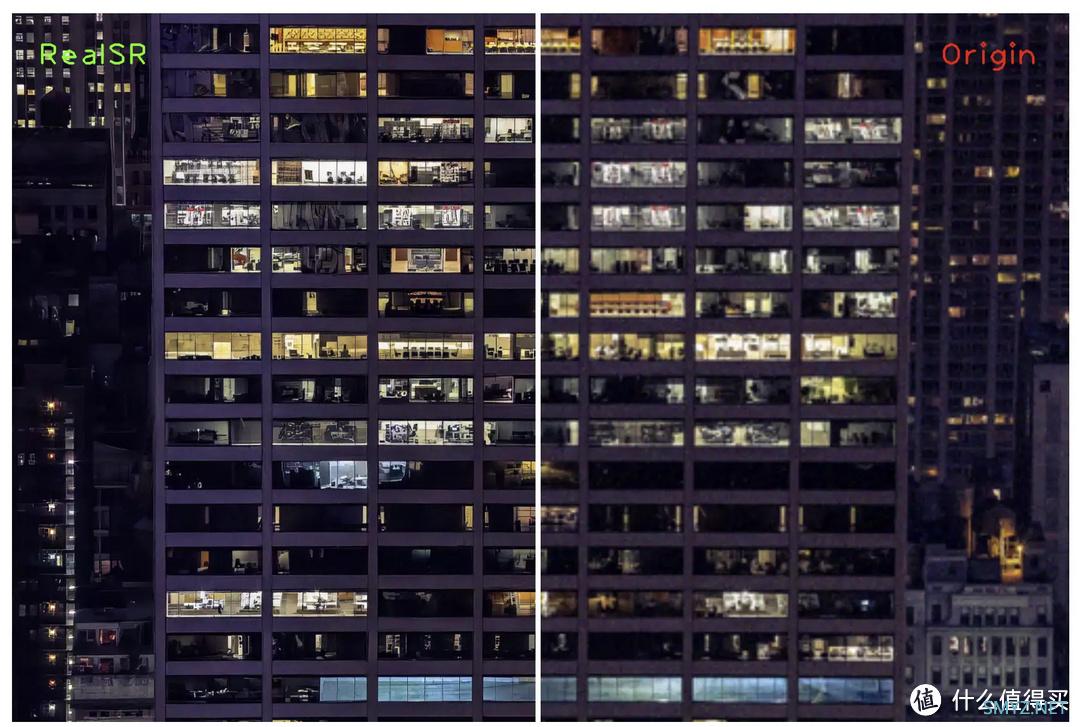

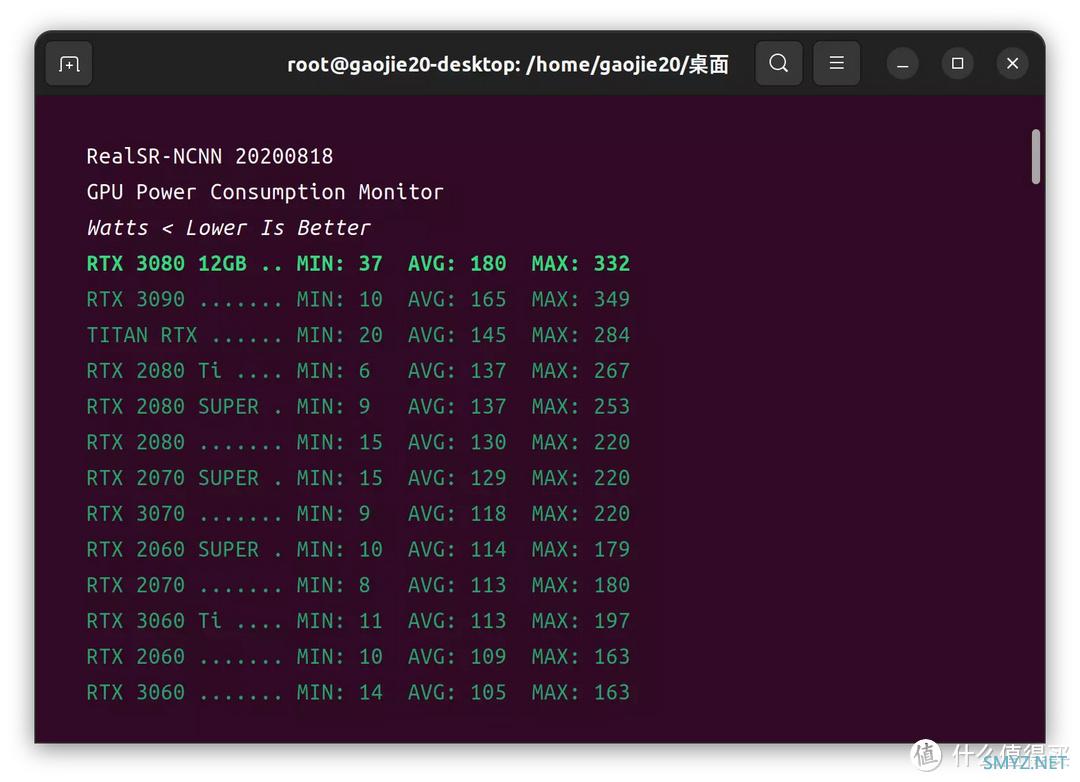

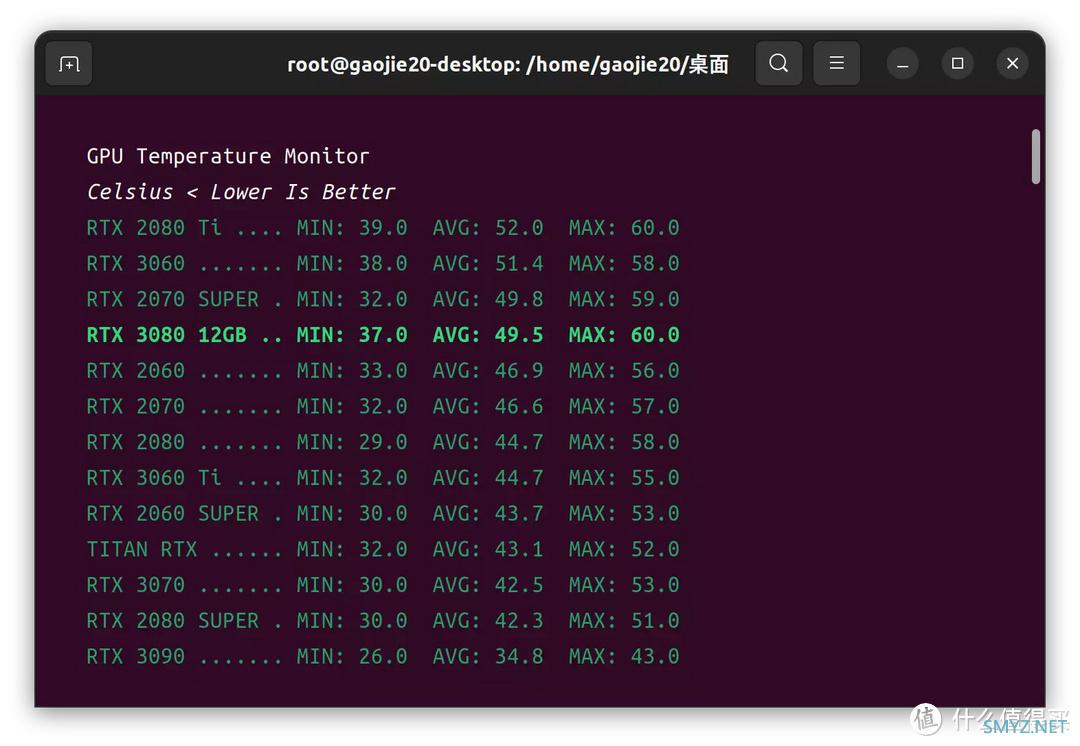

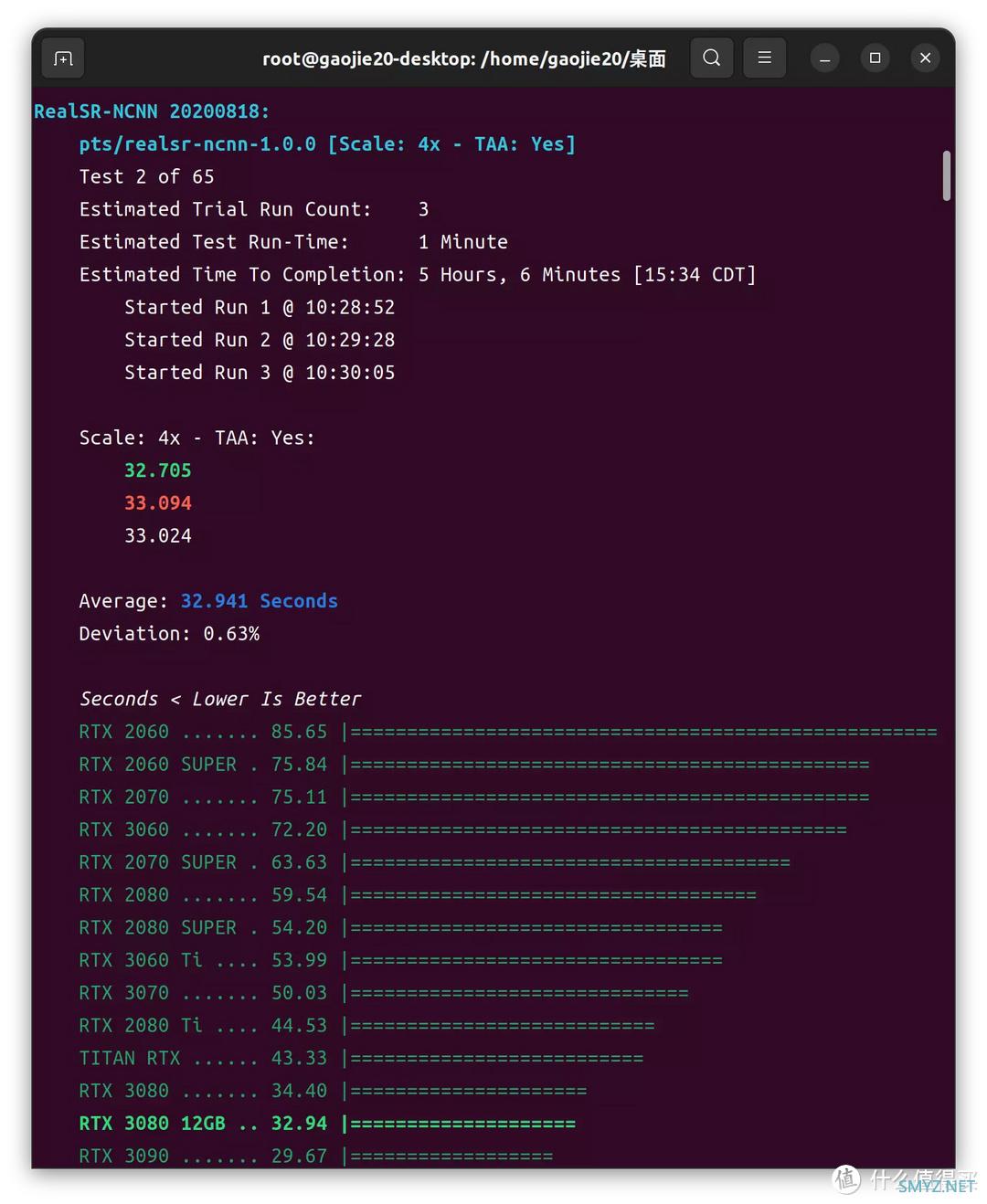

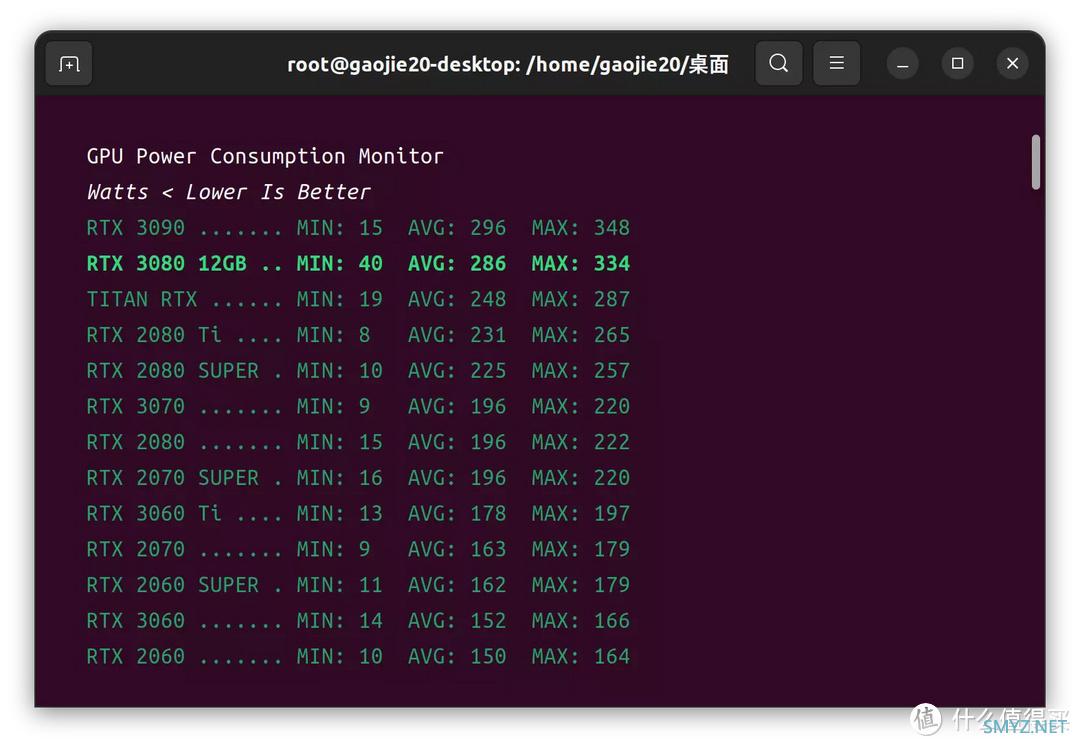

RealSR-NCNN

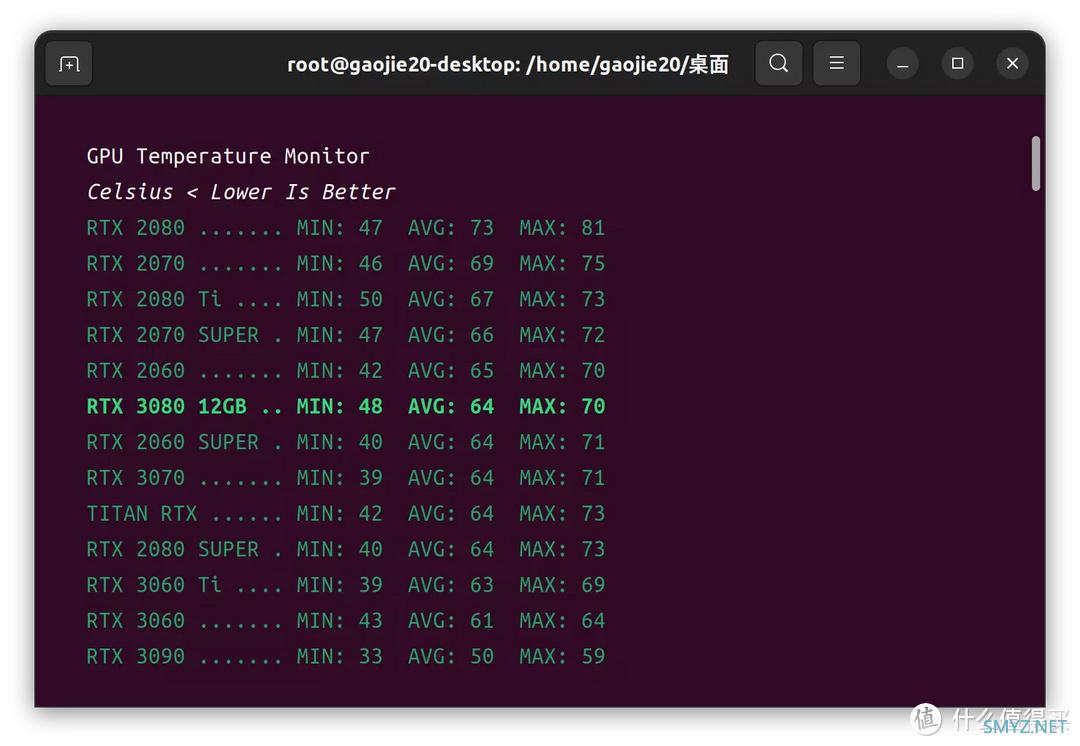

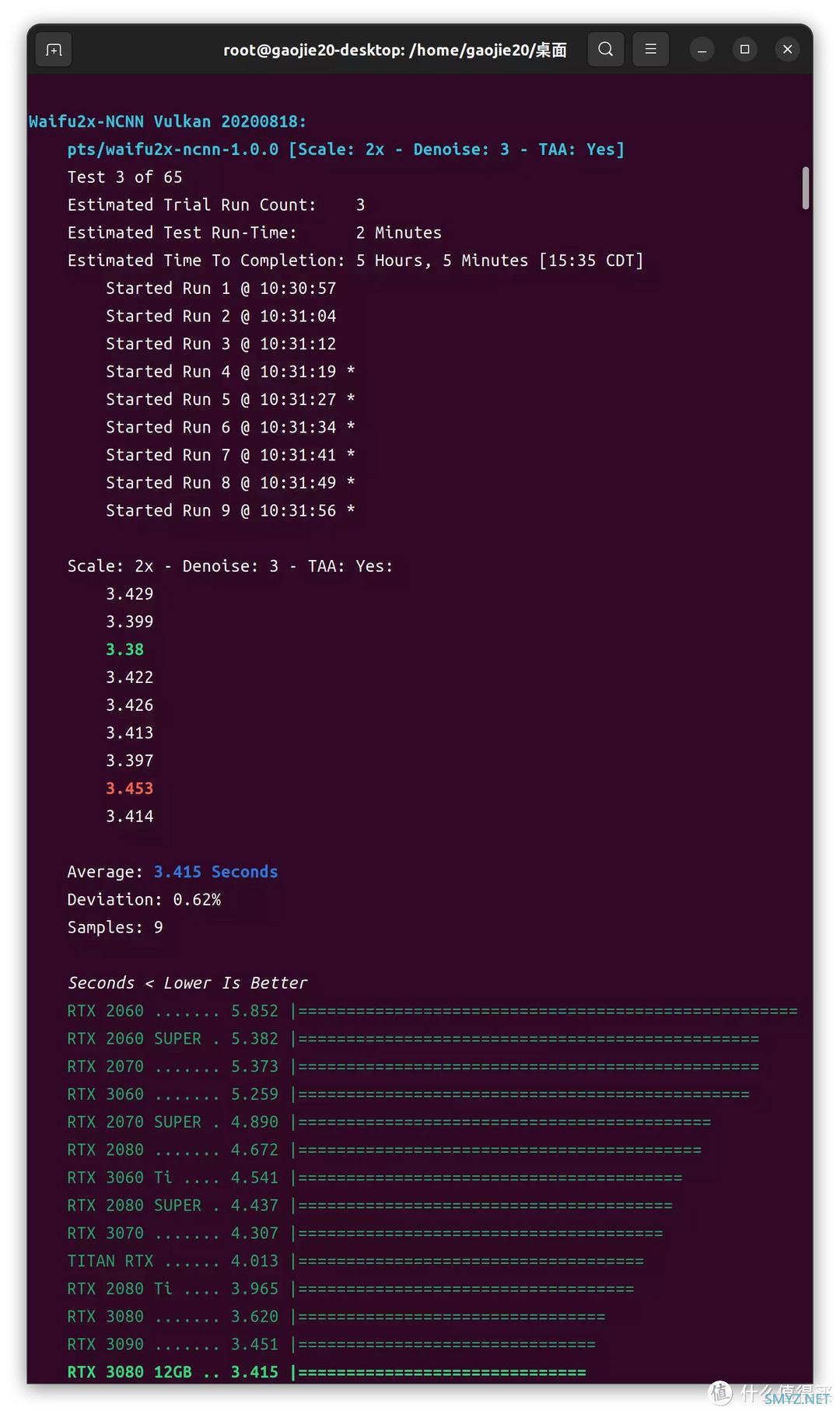

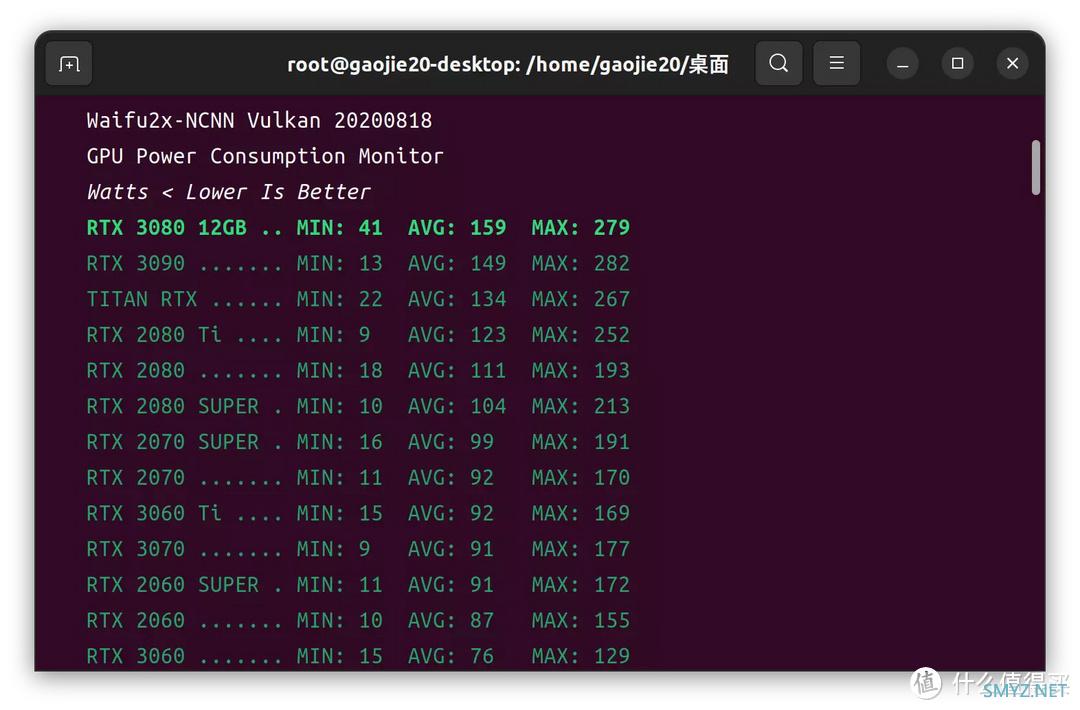

Waifu2x-NCNN

金融计算

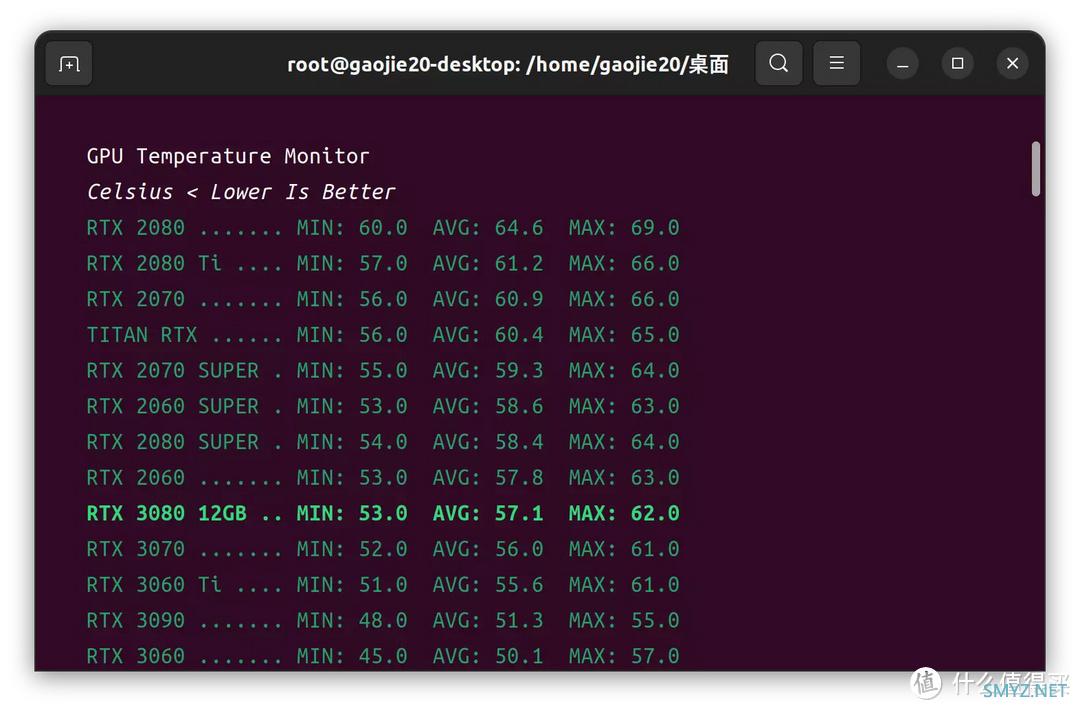

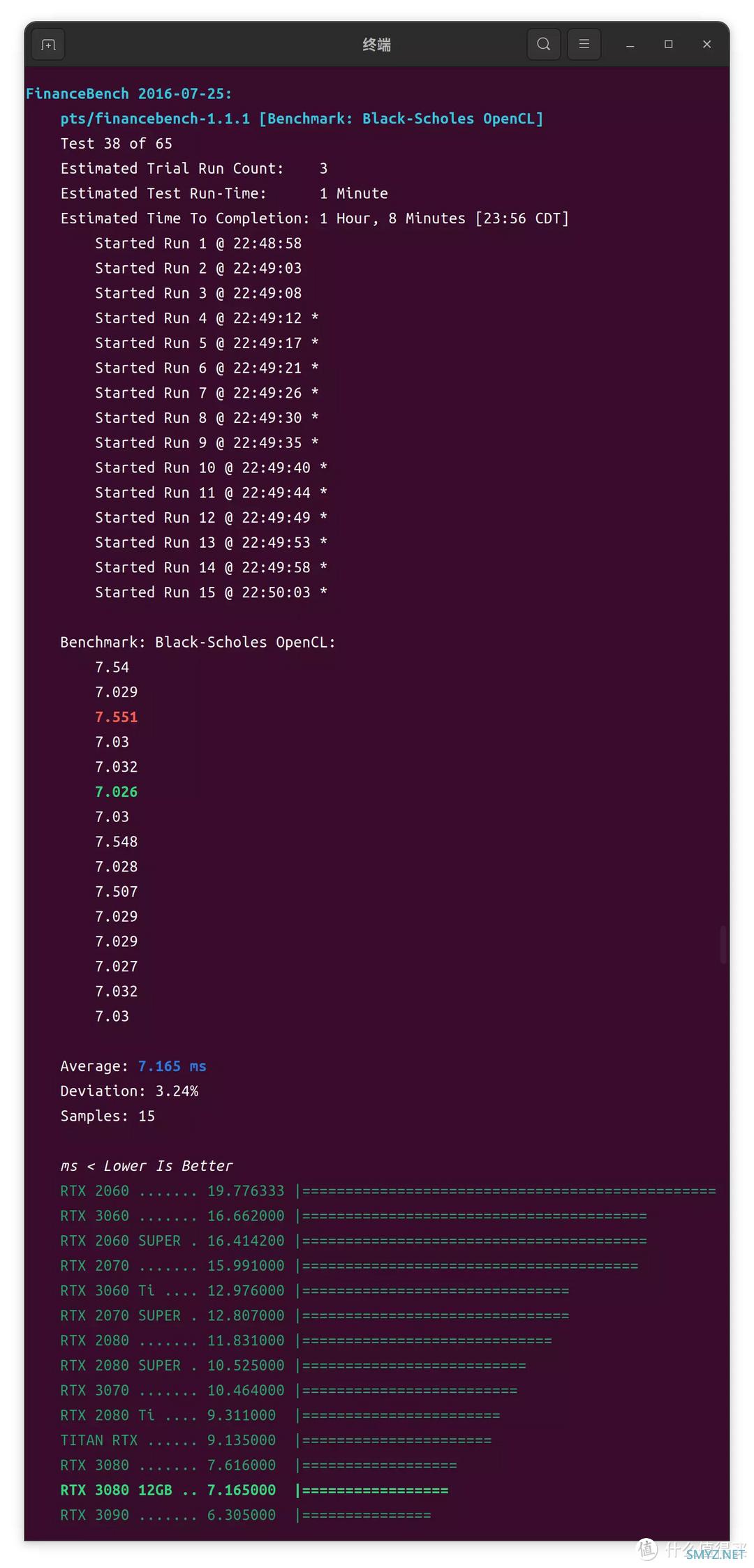

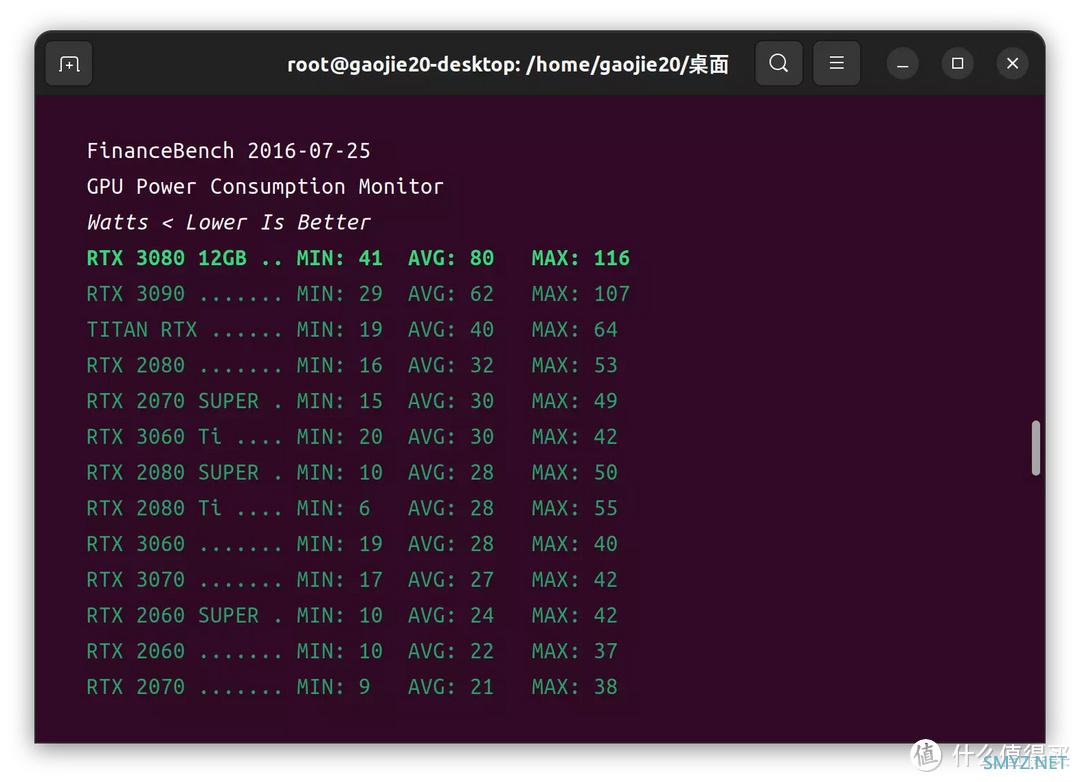

FinanceBench

分子动力学模拟

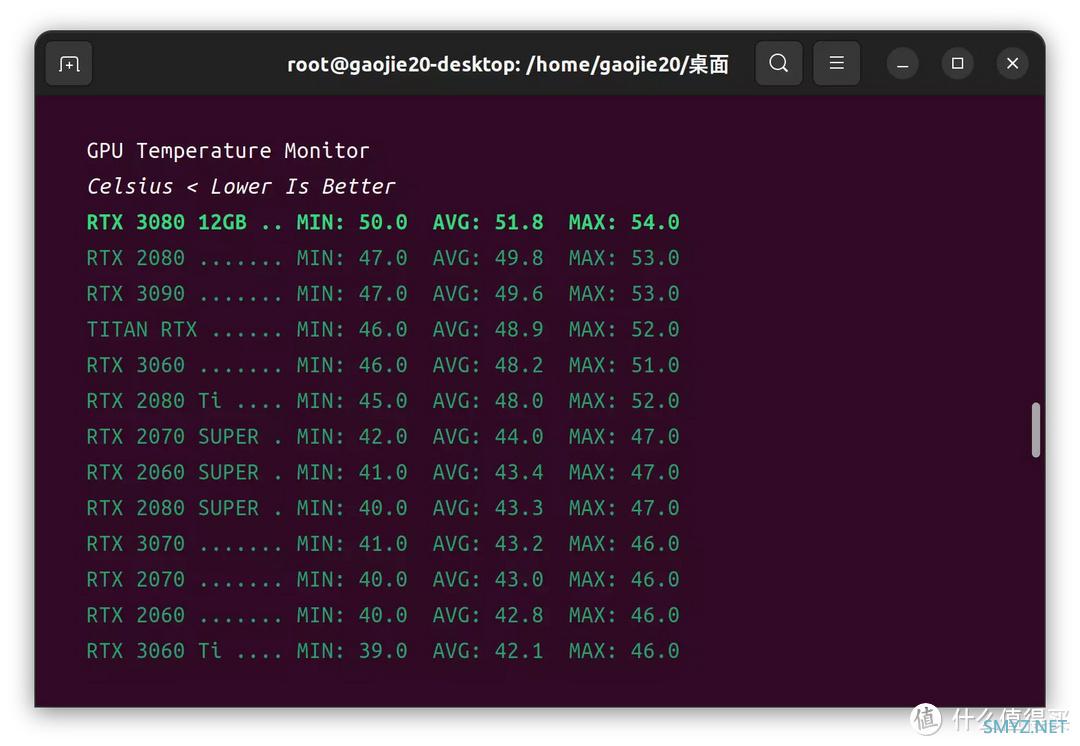

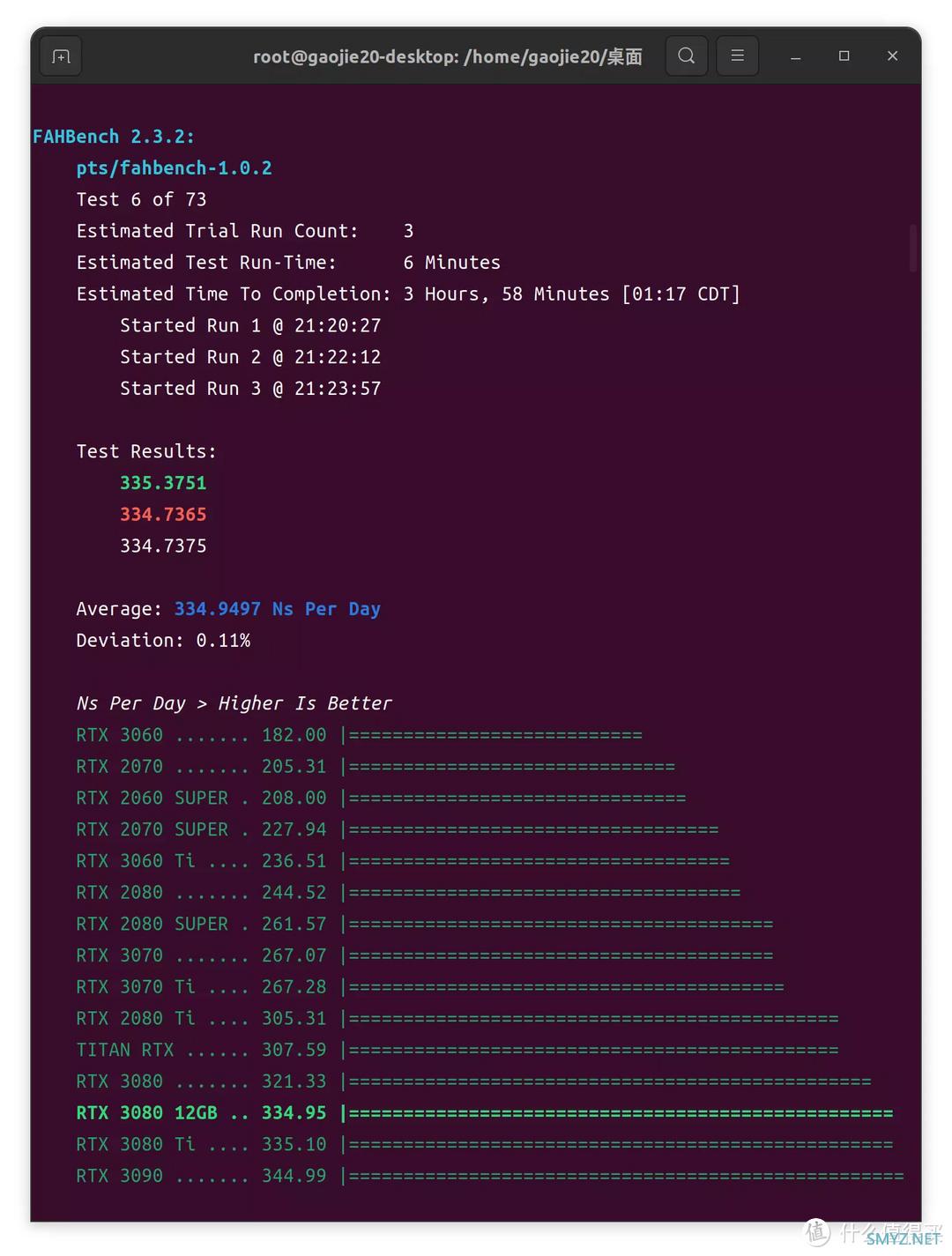

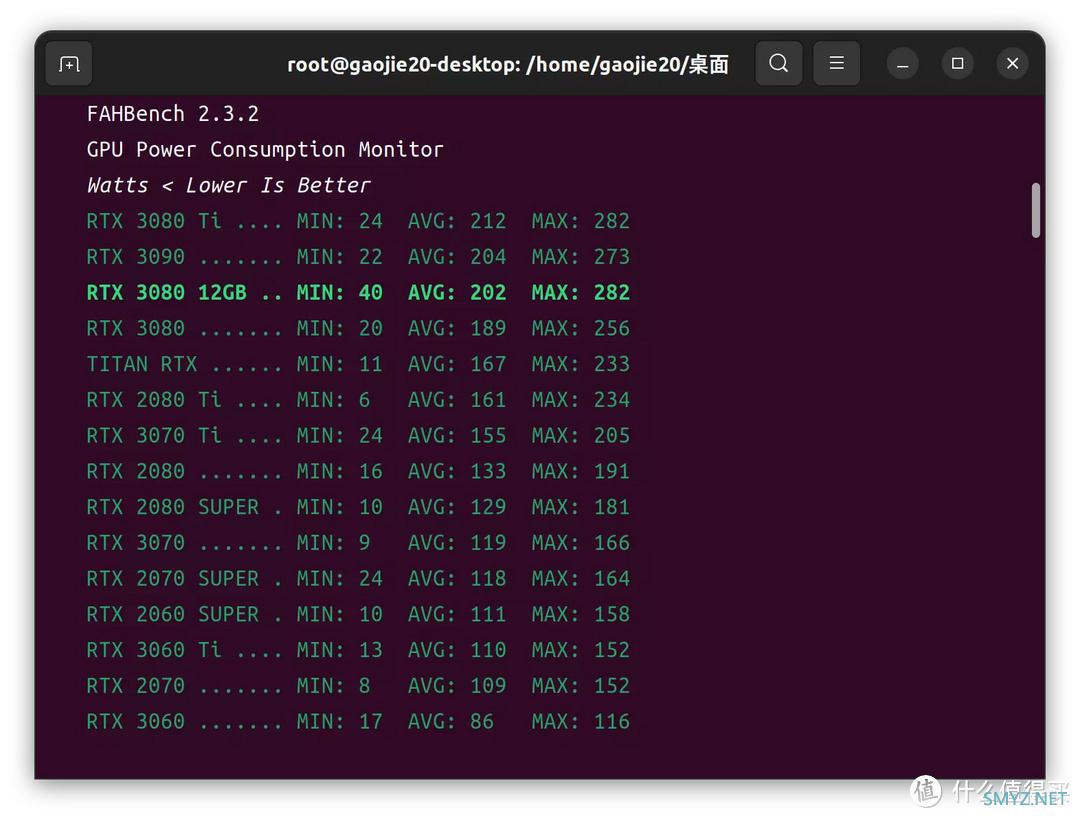

FAHBench

Windows 11 X64 21H2 测试部分

【系统】: Windows 11 Pro X64 21H2【驱动】: NVIDIA 516.59 DCH

游戏部分

用于对比的GPU为:

GPU1:ZOTAC Geforce RTX 3060 Apocalypse OC

GPU2:MSI Geforce RTX 3080 Ventus 3X

GPU3:ZOTAC Geforce RTX 3080 12GB Apocalypse OC

GPU4:,MSI Geforce RTX 3080 Ti Ventus 3X

GPU5:ZOTAC Geforce RTX 3090 Apocalypse OC

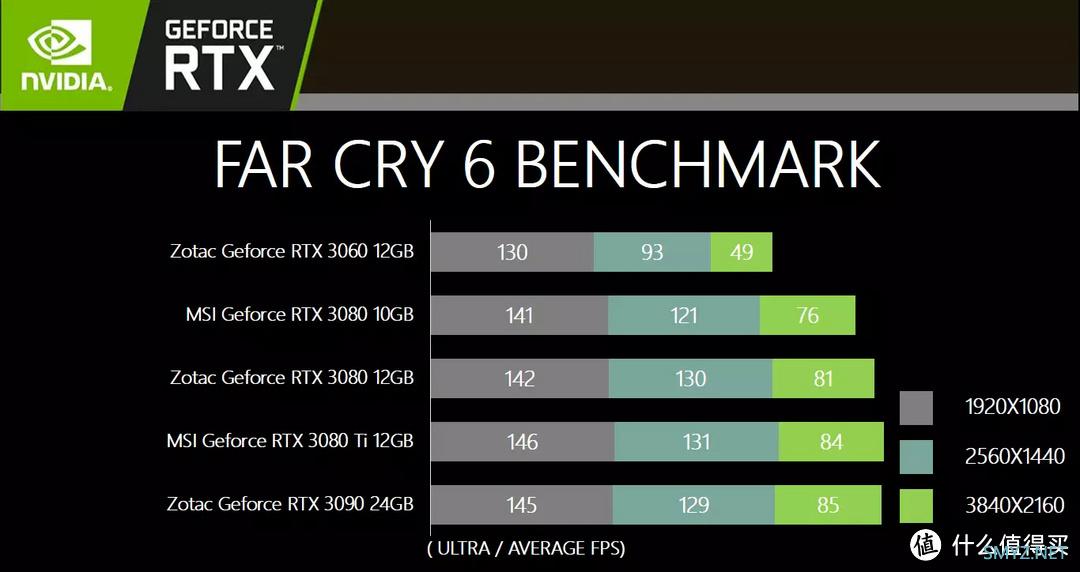

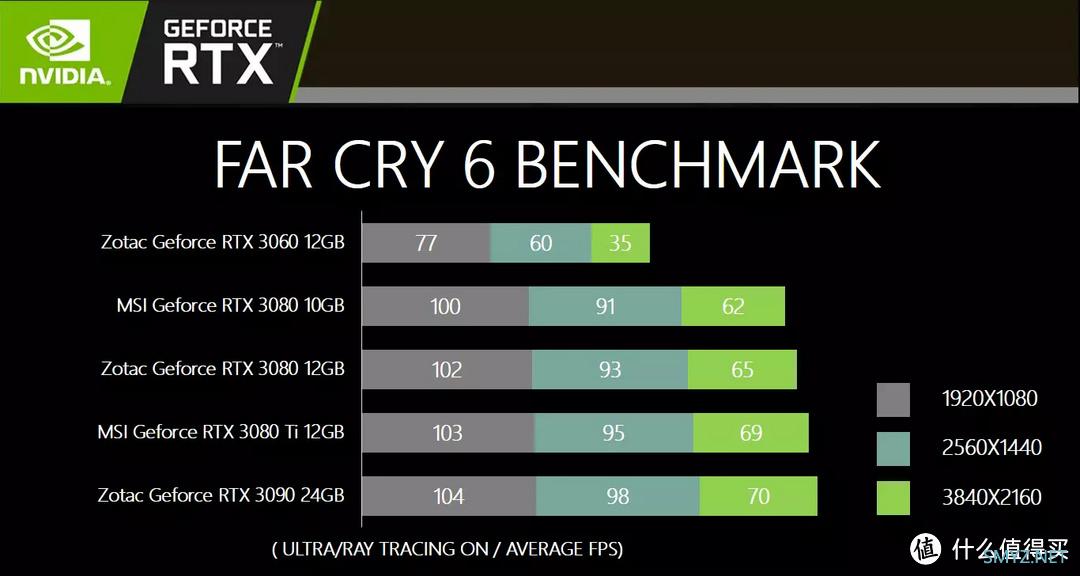

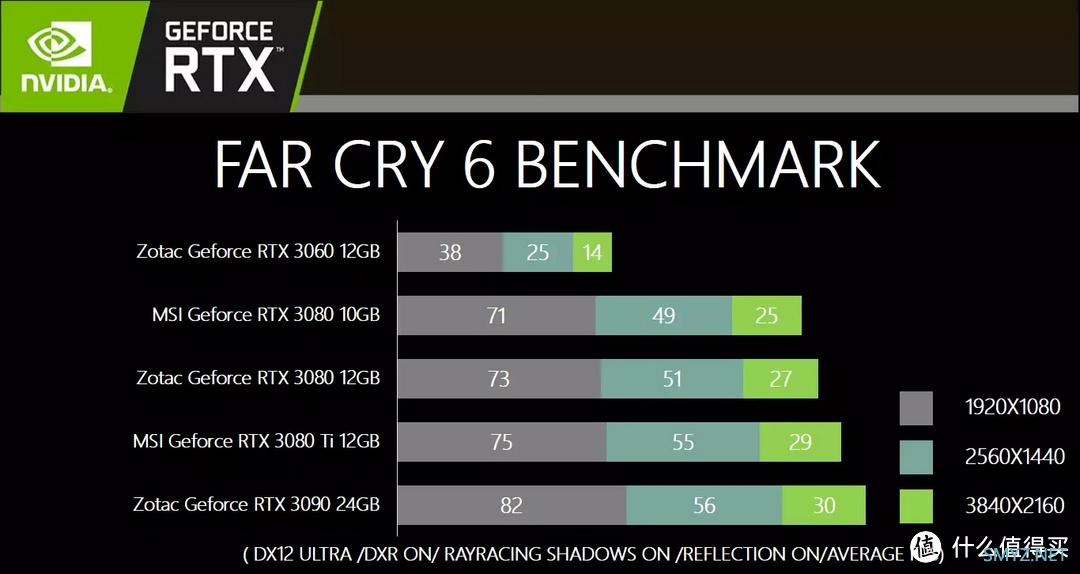

FARCRY6

▲硬件标杆性质的游戏

▲ULTRA画质三个分辨率下的平均FPS对比。

▲开启DXR,启用光线追踪开启阴影和反射的情况下以ULTRA画质测试三种分辨率的平均FPS。

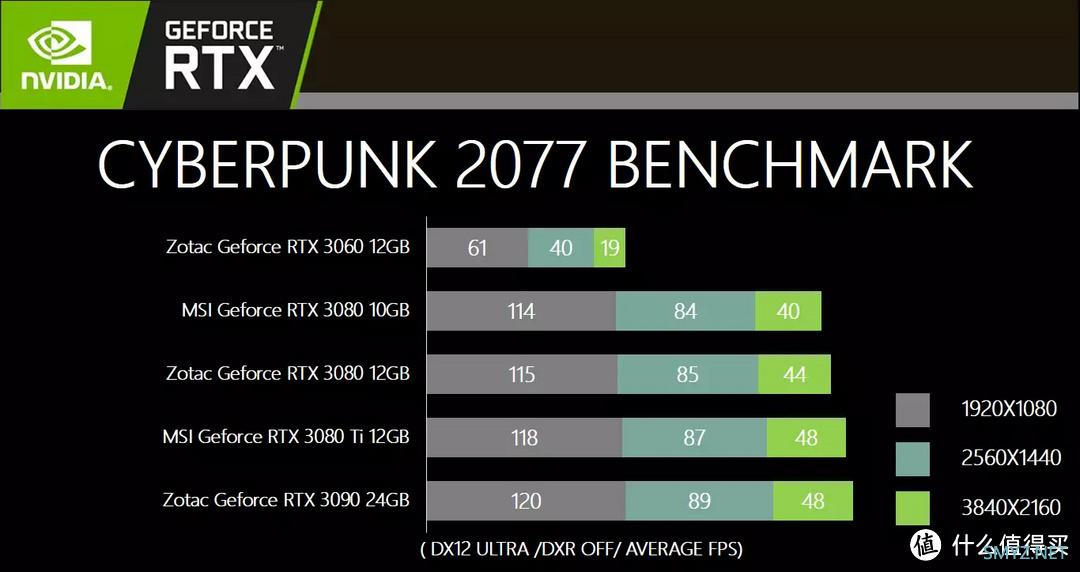

CYBERPUNK 2077

▲支持DXR的新一代硬件标杆性游戏

▲关闭DXR,使用ULTRA画质进行测试三种分辨率的平均FPS。

▲开启DXR,启用光线追踪开启阴影和反射的情况下以ULTRA画质测试三种分辨率的平均FPS。

Puget Systems Beenchmark

生产力测试环节使用了Puget Systems的三个测试脚本进行测试

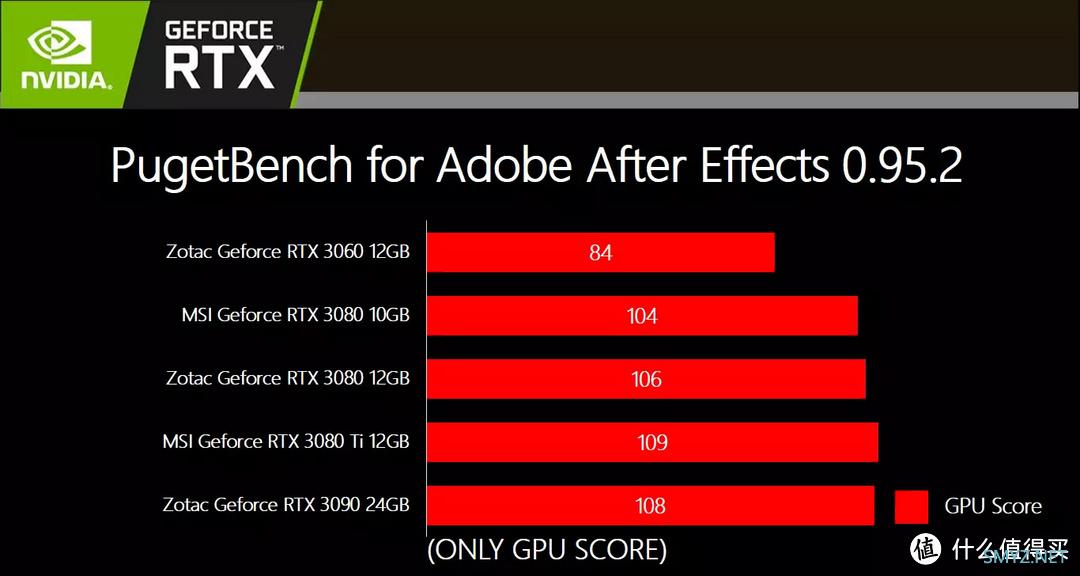

Adobe After Effects 2020

▲本测试以Adobe After Effects 2020为测试载体

▲以PugetBench for After Effects 0.95.2为工具基准进行测试

本测试涉及到了许多不同的项目,其中包括一个专用的“GPU 压力”测试,该测试旨在往 GPU 上施加尽可能多的负载,同时仍保持在某人在现实世界中可能实际执行的范围内。 在 After Effects 等应用程序中查看 GPU 性能通常是检查 GPU 承受重负载的极端情况的情况,因此通过每个 GPU 的 After Effects 基准测试中看到的整体性能开始,GPU 分数是根据“GPU Stress”组合的性能计算得出的,该组合旨在将尽可能多的负载置于 GPU 上,同时最大限度地减少 CPU 作为瓶颈,可以很好地显示 After Effects 中不同 GPU 之间的最大性能增量。

GPU分数的基准是以NVIDIA GeForce RTX 2080 8GB为100分参考基准。

NVIDIA GeForce RTX 2080 8GB

GPU分数:100

▲测试数据汇总

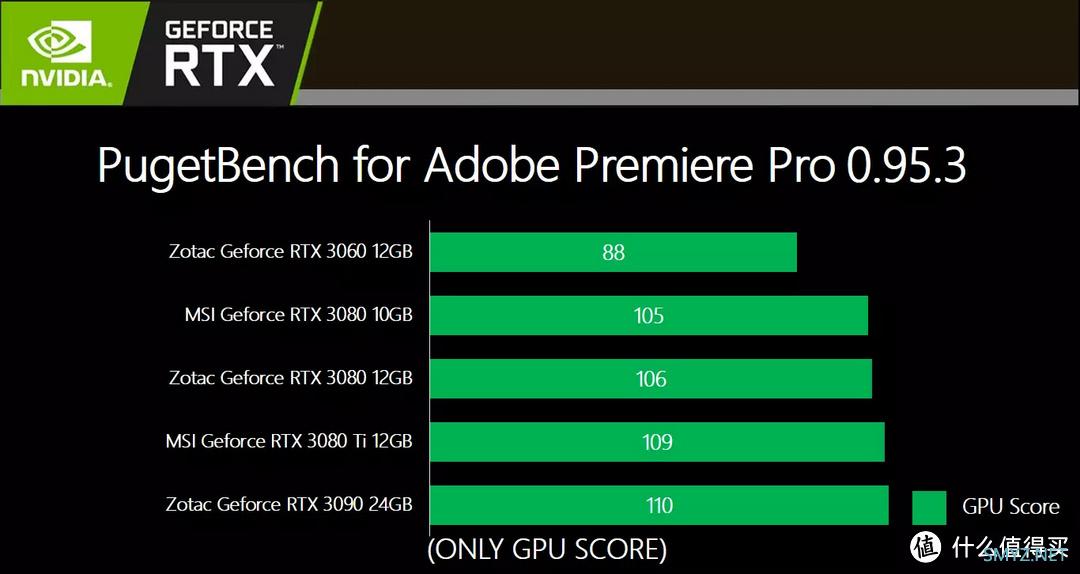

Adobe Premiere Pro 2020

▲本测试以Adobe Premiere Pro 2020为测试载体

▲以PugetBench for Premiere Pro 0.95.1为工具基准进行测试

这个基准测试通过4K和8K分辨率以及29.97和59.94 FPS的各种编解码器来研究实时回放和导出性能。对于GPU测试使用专用的“重载GPU效果”单独向GPU施加尽量多的压力,使其超出普通Premiere Pro用户的工作范围来进行测试。

测试的剪辑素材 (59.94 FPS)素材分辨率以及编码器包含:4K H.264 150mbps 8-bit (59.94FPS)、4K ProRes 422、4K RED、8K RED、8K H.265 100Mbps。

对于每种类型的测试素材,进行四种测试:

标准 - 两个 59.94FPS 片段串联,应用 Lumetri Color 效果

2x Forward - 四个 59.94FPS 剪辑,在 119.88FPS 序列中将 Lumetri 颜色设置为 200% 速度,以模拟以 2 倍速度播放时的性能。

4x Forward - 8 个 59.94FPS 剪辑,在 239.76FPS 序列中将 Lumetri 颜色设置为 400% 的速度,以模拟以 4 倍速度播放时的性能。

MultiCam - 在多机位序列中跨四六个轨道的多个剪辑。在“多相机”显示模式下测试播放。

这些测试都用于全回放分辨率的实时回放性能测试。

标准测试还使用“Youtube 2160p 4K 超高清”预设(H.264、4K、40mbps)以及导出到 4K ProRes 422HQ 8-bpc 来测试其导出性能。

关于GPU有一个“Heavy GPU Effects”测试,使用:

串联的 Twp ProRes 422 剪辑,每个剪辑之间有交叉溶解

高级效果:Lumetri Color、Ultra Key、Sharpen、Gaussian Blur、Basic 3D、Directional Blur 和 VR Digital Glitch。

极致效果:Lumetri Color、Ultra Key、Sharpen、Gaussian Blur、Basic 3D、Directional Blur、VR Digital Glitch 和 VR De-Noise。

通过导出到 ProRes 422HQ 来衡量性能。

GPU 分数是 GPU Effects测试和 H.264 导出测试结果的平均值,基准是以NVIDIA GeForce RTX 3080 10GB为100分参考基准:

NVIDIA GeForce RTX 3080 10GB

GPU分数:100

▲测试数据汇总

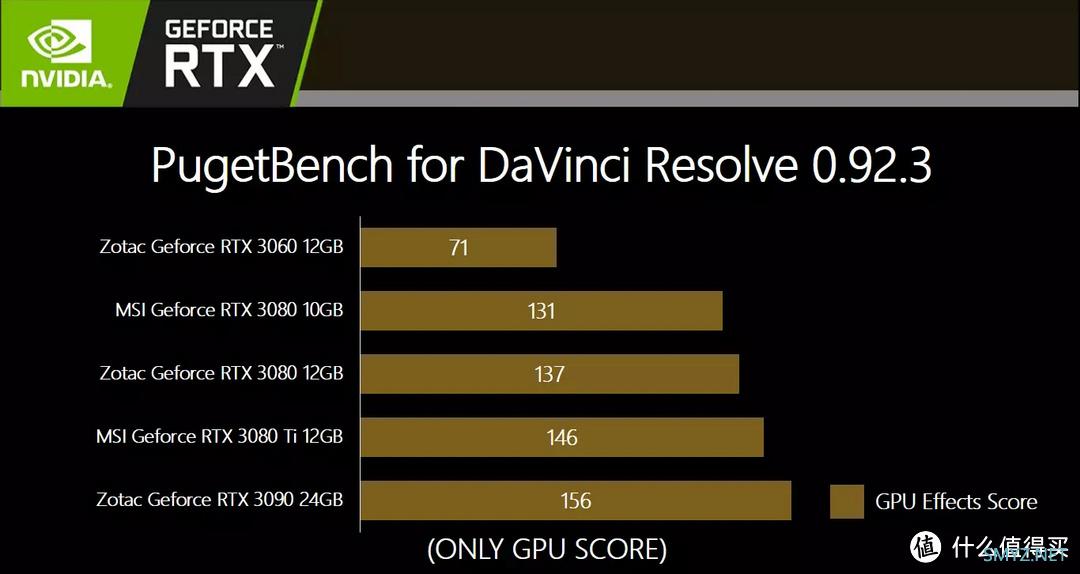

BlackMagic DaVinci Resolve Studio 17.3

▲本测试以BlackMagic DaVinci Resolve Studio 17.3为测试载体,以PugetBench for DaVinci Resolve 0.92.3为工具基准进行测试

本基准测试主要使用各种编解码器以 4K 和 8K(仅限扩展预设)分辨率、OpenFX 以及 Fusion 中的性能进行渲染。

测试的剪辑素材 (59.94 FPS)素材溯源自以下两家自媒体提供的样片:包含以下分辨率和编解码器:

4K H.264 150mbps 8-bit、4K ProRes 422、4K RED、8K RED以及8K H.265 100mbps

GPU 效果部分侧重于 OpenFX 和降噪,包含以下效果:

Temporal NR x3 - 2 Frames Better

Temporal NR - 2 Frames Better

Film Grain

Spatial NR - Better

Lens Blur x5

Lens Flare

Optical Flow - 50% Enhanced Better

Face Refinement

▲测试数据汇总

最后需要说明的是,本次测试的剪辑素材来自以下两家自媒体:

▲4K和8K RED剪辑视频来自老莱的工作室,这些剪辑也已转码以创建H.265和ProRes 422剪辑。Linus Media Group是老莱的公司,在YouTube上提供了流行的 LinusTips和 TechLinked频道。

▲Neil Purcell是伦敦著名的照明摄影师,在广播电视领域拥有超过25年的经验。从事各种各样的作品;从戏剧到木偶,现场新闻和事实,儿童节目,灯光娱乐,真人秀,外部广播,重大体育赛事,音乐演唱会,流行视频,企业电影和商业广告。图中Neil Purcell(灯光摄影师/摄影操作员)正在以他的松下 GH5 拍摄 4K H.264 素材。本次测试使用的4K H.264素材来源于他的剪辑作品。

总结

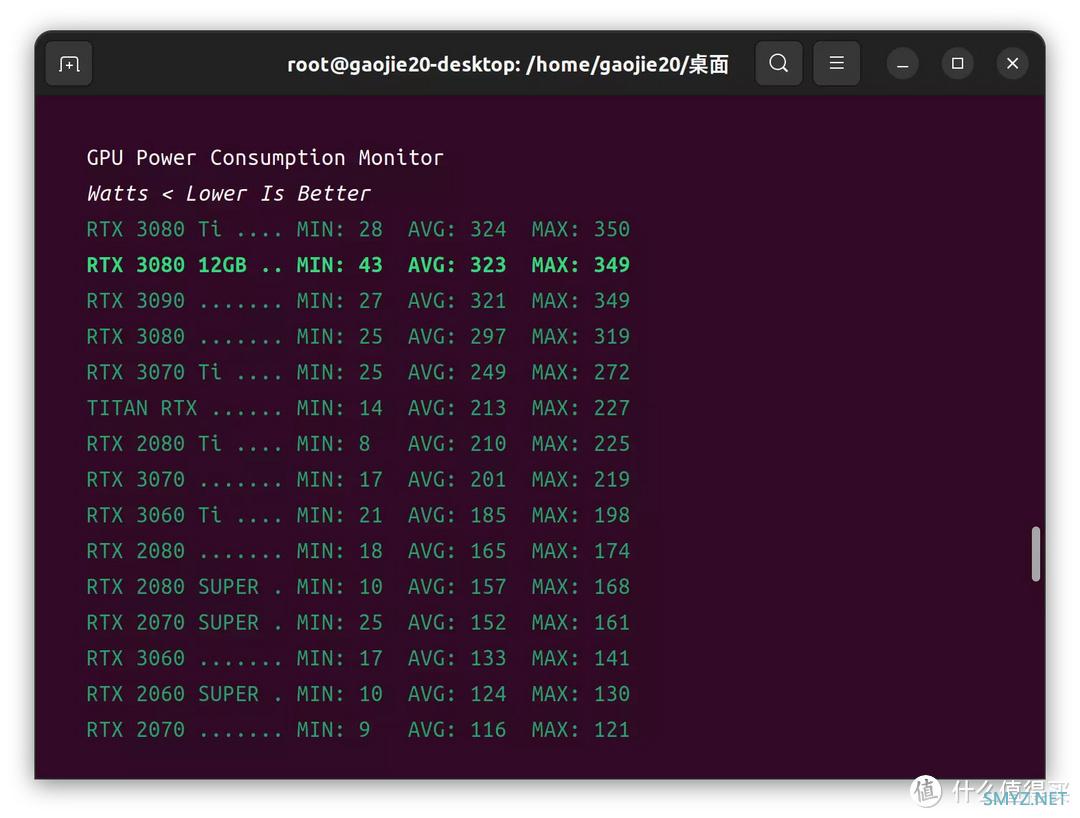

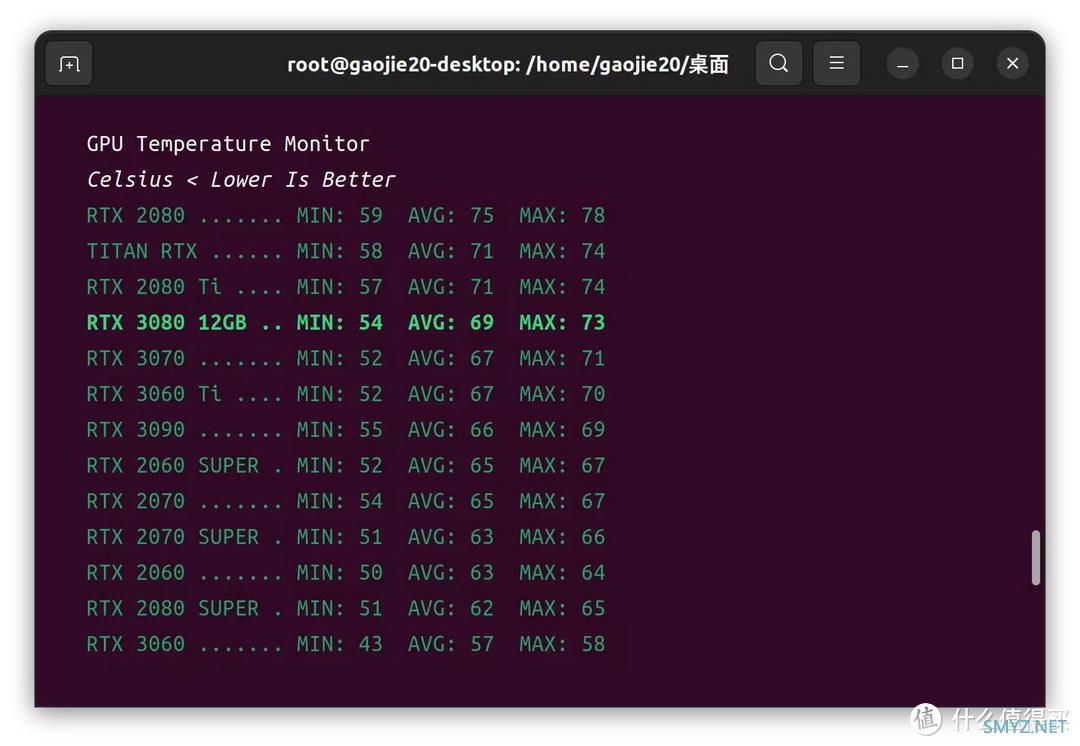

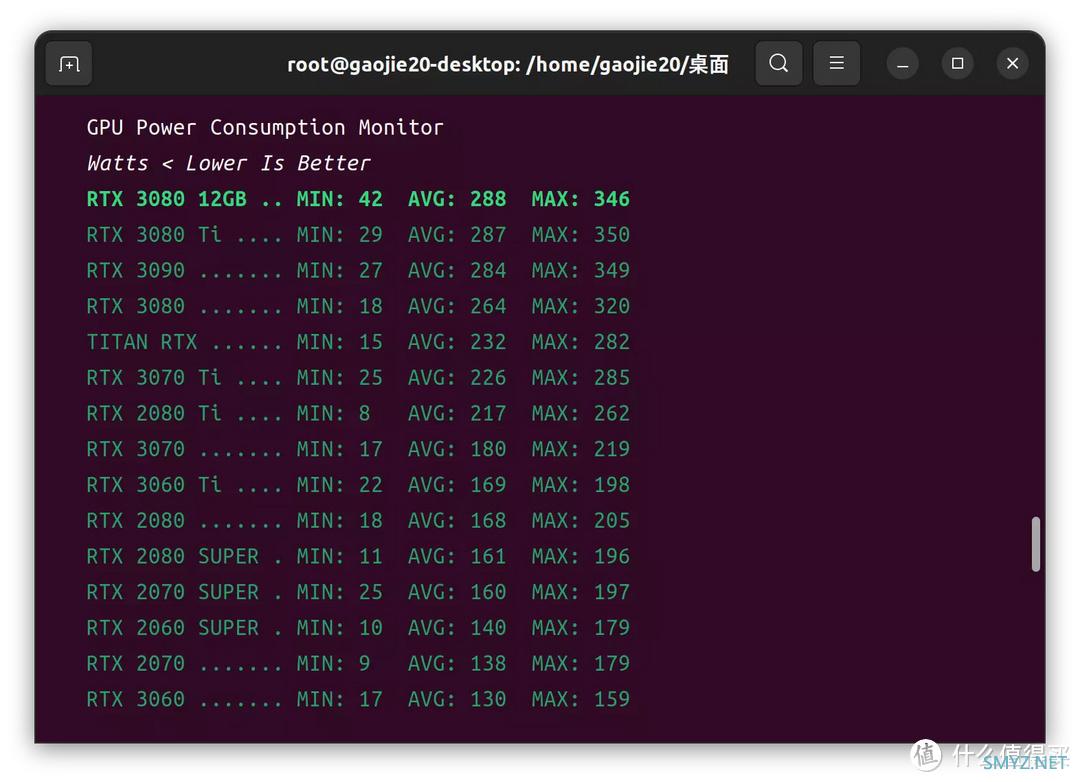

整个测试走完了LINUX和WIN11操作系统下的机器学习,图像识别,渲染,金融计算,模型推理以及游戏表现,ZOTAC RTX3080-12G6X天启OC 这张显卡给我的感受还是中规中距的,不黑不捧,感受如下1、从SM簇而言,RTX 3080 12GB只比RTX 3080多2组,比RTX 3080 Ti少10组,性能却更接近RTX 3080 Ti,并可以成功的与RTX 3080拉出性能分层。也只有在TDP和频率上入手提升才有可能,有得必有失,所以闲时功耗相比RTX 3090、RTX 3080 Ti、RTX 3080 10G而言,是最高的,基本在35-40W之间,满载功耗和RTX 3090以及RTX 3080 Ti一样是350W。个人感觉是NVIDIA在为了压榨GPU的性能提高了P0-P4的电压基点导致的。虽然散热器模组和RTX 3080 Ti以及RTX 3090天启版本是同规格,但是由于RTX 3080 12GB较高功耗带来的持续温度表现会略微偏高,并不低于RTX 3080 Ti以及RTX 3090的天启版本,甚至更高,所以对温度比较敏感的用户还是建议安装背面散热风扇模组,效果不大,但聊胜于无。

2、显卡供电在GPU和VRAM部分采用16+3的设计,用料还是比较务实,达到RTX 3080 Ti的供电水准。

3、支持个人送保的保修政策还是比较令人舒适。

4、由于NVIDIA对RTX 3080 12GB的性能定位,已经影响到了RTX 3080 Ti的销售情况,所以NVIDIA也在逐步停产RTX 3080 12GB,所以能不能买到这张卡还是个问题。

索泰(ZOTAC)索泰(ZOTAC)RTX3080天启OC显卡/台式机/游戏/12G显存6099元京东去购买

加载中,请稍侯......

加载中,请稍侯......

网友评论